خلاصه

- یه سیستم جدید به اسم VoXtream برای تبدیل متن به گفتار (TTS) معرفی شده که هدفش حل مشکل تاخیر تو مکالمات با هوش مصنوعی و دستیارهای صوتیه.

- VoXtream به صورت «فول استریم» کار میکنه، یعنی به محض شنیدن اولین کلمه، شروع به صحبت میکنه و مثل بقیه مدلها منتظر تموم شدن کل جمله نمیمونه.

- مهمترین مزیتش، تاخیر اولیه فوقالعاده پایینه: فقط ۱۰۲ میلیثانیه روی پردازنده گرافیکی (GPU) که بهترین عملکرد بین مدلهای مشابه محسوب میشه.

- این مدل میتونه صدای هر گویندهای رو بدون نیاز به آموزش قبلی تقلید کنه (قابلیت zero-shot) و برای کاربردهایی مثل ترجمه همزمان یا رباتهای گفتگو عالیه.

- VoXtream با اینکه روی دادههای آموزشی کمتری (حدود ۹ هزار ساعت) آموزش دیده، تو خیلی از تستها کیفیت و وضوح صدای بالایی داره و حتی با مدلهای بزرگتر رقابت میکنه.

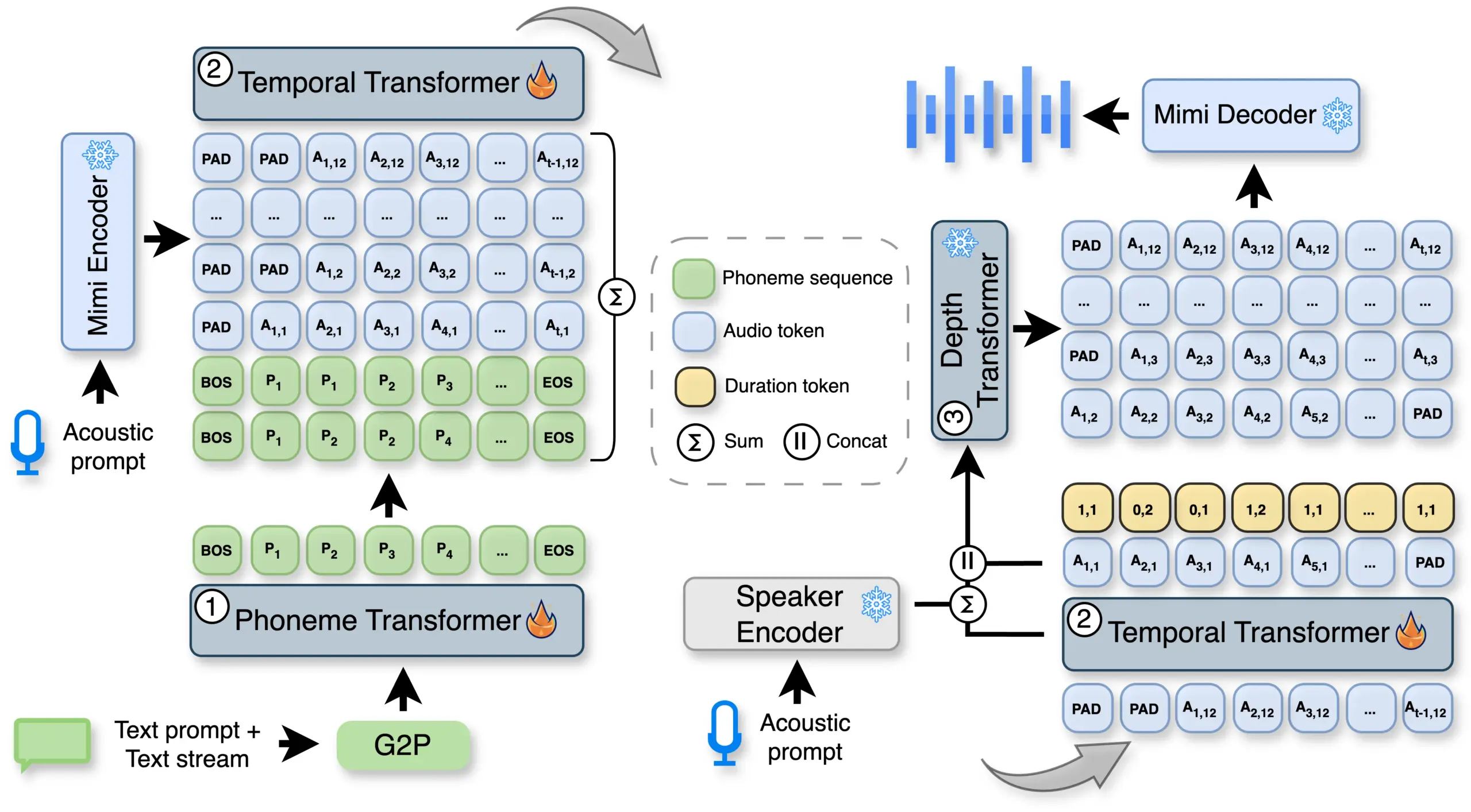

- معماری VoXtream شامل سه بخش اصلی (Phoneme Transformer، Temporal Transformer و Depth Transformer) میشه که با هم کار میکنن تا این سرعت و کیفیت رو فراهم کنن.

- این سیستم با یه روش همترازی یکنواخت و نگاه به جلوی پویا کار میکنه که باعث میشه تاخیر تو شروع صحبت به حداقل برسه.

تا حالا شده با یه دستیار صوتی یا هوش مصنوعی صحبت کنید و یه مکث کوتاه اما رو اعصاب بین حرف شما و جواب اون وجود داشته باشه؟ همین تاخیر کوچیک میتونه حس طبیعی بودن مکالمه رو از بین ببره. اینجور وقتها، سرعت پاسخگویی، مخصوصا شروع صحبت هوش مصنوعی، خیلی مهمه. یه سیستم جدید به اسم VoXtream معرفی شده که هدفش دقیقا حل همین مشکله. این سیستم یه مدل تبدیل متن به گفتار (TTS) هست که به صورت «فول استریم» کار میکنه، یعنی به محض اینکه اولین کلمه رو میشنوه، شروع به صحبت میکنه و منتظر تموم شدن جمله نمیمونه.

ایده اصلی VoXtream اینه که با کمترین تاخیر ممکن، متن رو به صدا تبدیل کنه. این سیستم برای کاربردهای زنده و همزمان مثل دستیارهای صوتی، ترجمه همزمان یا رباتهای گفتگو طراحی شده. برخلاف خیلی از مدلهای دیگه که باید کل متن رو بگیرن تا شروع به تولید صدا کنن، VoXtream این کار رو به صورت کلمه به کلمه انجام میده. این سیستم از یه ساختار کاملا خودرگرسیو (autoregressive) استفاده میکنه و میتونه صدای هر گویندهای رو بدون نیاز به آموزش قبلی روی اون صدا، تقلید کنه (به این قابلیت میگن zero-shot).

این سیستم با استفاده از یه معماری یکپارچه، فونمها (واحدهای پایهای صدا در زبان) رو مستقیما به توکنهای صوتی تبدیل میکنه. این کار با یه روش همترازی یکنواخت و یه نگاه به جلو پویا انجام میشه که باعث تاخیر در شروع صحبت نمیشه. در نتیجه، VoXtream تونسته به کمترین تاخیر اولیه در بین سیستمهای TTS استریمینگ عمومی دست پیدا کنه: فقط ۱۰۲ میلیثانیه روی پردازنده گرافیکی (GPU). نکته جالب اینه که با وجود اینکه روی یه مجموعه داده متوسط (حدود ۹ هزار ساعت) آموزش دیده، عملکردش در بسیاری از معیارها با مدلهای بزرگتر برابری میکنه یا حتی از اونها بهتره و کیفیت صدای خوبی هم در حالتهای مختلف استریمینگ ارائه میده.

مشکل سیستمهای فعلی چیه؟

پیشرفتهای اخیر توی مدلهای زبان بزرگ (LLM) و تولید گفتار، اهمیت سیستمهای تبدیل متن به گفتار استریمینگ با تاخیر کم رو خیلی بیشتر کرده. برای اینکه یه تجربه کاربری خوب و جذاب داشته باشیم، کم کردن فاصله زمانی بین دریافت متن و تولید صدا، به خصوص تاخیر در تولید اولین بسته صوتی (first-packet latency)، خیلی مهمه. اما بیشتر مدلهای TTS موجود یا به صورت آفلاین کار میکنن (یعنی باید کل متن رو داشته باشن) یا از یه سری مراحل پیچیده و چندگانه استفاده میکنن که سرعت پاسخگویی رو کم میکنه، به متن ورودی زیادی برای شروع نیاز داره یا چالشهای همترازی ایجاد میکنه.

مدلهای تولیدکننده صدا به لطف دادههای آموزشی بزرگتر، خیلی پیشرفت کردن و الان مدلهای zero-shot زیادی وجود دارن که میتونن صدای افراد جدید رو با طبیعی بودن و وضوح بالا تولید کنن. بین سیستمهای خودرگرسیو (AR)، مدلهای دو مرحلهای اول یه نمایش میانی از گفتار رو پیشبینی میکنن و بعد اون رو با یه رمزگشا (decoder) غیرخودرگرسیو به صدا تبدیل میکنن. سیستمهای AR تک مرحلهای هم مستقیما متن رو با یه مدل زبان واحد به توکنهای صوتی تبدیل میکنن. با اینکه این مدلها کیفیت بالایی دارن، اساسا برای پردازش کل متن قبل از تولید صدا طراحی شدن.

بعضی تحقیقات سعی کردن با تولید صدا به صورت تکه تکه (chunk-based)، تاخیر رو کم کنن. این روش بهش «استریم خروجی» (output streaming) میگن. اما این مدلها مشکل تاخیر در ورودی رو حل نمیکنن و هنوز باید کل متن رو دریافت کنن تا تولید صدا شروع بشه. از طرفی، مدلهای غیرخودرگرسیو (NAR) که بر اساس مدلهای زبان، دیفیوژن یا فلو مچینگ کار میکنن، در حالت آفلاین عملکرد خیلی خوبی دارن و اغلب از مدلهای AR سریعتر هستن، اما معماری غیرترتیبی اونها برای کاربردهای استریمینگ مناسب نیست.

کارهای جدید در زمینه TTS استریمینگ روی تولید صدای همزمان از طریق پردازش متن و گفتار به صورت تکه تکه یا در هم تنیده تمرکز دارن. برای مثال:

- SpeakStream: از یه ترنسفورمر فقط-رمزگشا استفاده میکنه که روی دنبالههای در هم تنیده متن و گفتار آموزش دیده و تاخیر اولیه کمی داره، اما قابلیت zero-shot رو بررسی نکرده.

- SyncSpeech: یه ترنسفورمر با ماسک زمانی و نگاه به جلوی یک توکنی معرفی کرده، اما برای تولید صدا باید توکنها رو جمعآوری کنه که باعث تاخیر میشه.

- IST-LM و CosyVoice2: متن و گفتار رو با نسبتهای ثابت در یک رمزگشای AR در هم تنیده میکنن تا از عملکرد فول استریم پشتیبانی کنن، اما هر دو از یه رمزگشای NAR مبتنی بر فلو مچینگ استفاده میکنن که روی تکهها کار میکنه و این به تاخیر اولیه آسیب میزنه.

- Speak While You Think: از یه مدل غیر استریمینگ الگوبرداری میکنه و برای حفظ کیفیت حداقل به دو کلمه نگاه به جلو نیاز داره.

- LiveSpeech2: متن رو به بخشهای کوچکتر تقسیم میکنه و صدا رو به صورت استریمینگ تولید میکنه، اما از عدم تطابق بین تولید گفتار و تکههای متن رنج میبره.

VoXtream چطور کار میکنه؟

معماری VoXtream از سه بخش اصلی تشکیل شده که در یک سیستم یکپارچه با هم کار میکنن تا تاخیر رو به حداقل برسونن. این سیستم برخلاف مدلهای قبلی به رمزگشایی چندمرحلهای، مکانیزمهای همترازی پیچیده یا نگاه به جلوی زیاد نیازی نداره.

- ترنسفورمر فونم (Phoneme Transformer – PT)

این بخش یه ترنسفورمر فقط-رمزگشا (decoder-only) هست که دنبالهای از فونمها رو دریافت میکنه و برای هر فونم یه امبدینگ (embedding) یا نمایش عددی مربوط به اون رو تولید میکنه. این مدل به صورت افزایشی کار میکنه، یعنی با هر کلمه جدیدی که از جریان متن میاد، ورودی اون هم بزرگتر میشه. برای اینکه لحن و آهنگ کلام (prosody) طبیعیتر باشه، به PT اجازه داده میشه تا N توکن فونم به جلو نگاه کنه (look-ahead).

یه مزیت کلیدی اینجا، نگاه به جلوی پویا (dynamic LA) هست. یعنی مدل منتظر نمیمونه تا N تا فونم جمع بشه و بعد تولید صدا رو شروع کنه، بلکه بلافاصله بعد از دریافت اولین کلمه کارش رو شروع میکنه. حداقل مقدار نگاه به جلو توسط اندازه بافر متن تعیین میشه و حداکثر اون به ۱۰ فونم محدود شده. برای تبدیل متن ورودی به فونم، از ابزار g2pE در سطح کلمه استفاده میشه.

- ترنسفورمر زمانی (Temporal Transformer – TT)

این بخش یه ترنسفورمر خودرگرسیو هست که بر اساس توکنهای صوتی و دنباله فونم مربوط به اونها شرطی شده. توکنهای صوتی با استفاده از کدک Mimi با فرکانس ۱۲.۵ هرتز استخراج میشن. به خاطر نرخ فریم پایین، به هر فریم صوتی حداکثر دو فونم اختصاص داده میشه. همترازی بین صدای نمونه (prompt) و دنباله فونمها با استفاده از Montreal Forced Aligner (MFA) به دست میاد. برای پایداری بیشتر، یه تاخیر صوتی یک مرحلهای اعمال میشه.

خروجی TT شامل اولین کتابکد (codebook) کدک Mimi (که بهش توکنهای معنایی یا semantic tokens میگن) و یه توکن مدت زمان (duration token) هست. اینجا از یه ایده همترازی یکنواخت فونم استفاده شده. به جای اینکه مدل پیشبینی کنه فونم بعدی چیه، یه توکن مدت زمان پیشبینی میکنه که دو تا اطلاعات داره:

- پرچم تغییر (shift flag): که میگه «بمان» (stay) یا «برو» (go). اگه «بمان» باشه، یعنی در فریم بعدی هم تولید صدای فونم فعلی ادامه پیدا میکنه. اگه «برو» باشه، یعنی باید به فونم بعدی بریم.

- تعداد فونمها: که میتونه ۱ یا ۲ باشه و به تلفظ سریعتر یا کندتر مربوط میشه.

توکنهای معنایی و مدت زمان توسط یک سر طبقهبندی واحد پیشبینی میشن.

- ترنسفورمر عمق (Depth Transformer – DT)

این بخش هم یه ترنسفورمر خودرگرسیو هست که بر اساس خروجی TT و توکن معنایی شرطی شده. DT وظیفه تولید بقیه توکنهای صوتی (از کتابکد دوم به بعد کدک Mimi) رو بر عهده داره که بهشون توکنهای آکوستیک یا صوتی (acoustic tokens) میگن. این بخش همچنین بر اساس امبدینگ گوینده که از مدل ReDimNet گرفته شده شرطی میشه تا بتونه صدای گوینده مورد نظر رو تقلید کنه. در این سیستم از ۱۲ کتابکد Mimi استفاده شده که یه تعادل خوب بین تاخیر و کیفیت ایجاد میکنه.

در نهایت، رمزگشای Mimi توکنهای معنایی و آکوستیک هر فریم رو میگیره و اونها رو به صورت استریمینگ به ۸۰ میلیثانیه صدا تبدیل میکنه. آموزش کل سیستم VoXtream با کمینه کردن منفی لگاریتم درستنمایی خروجیهای TT و DT انجام میشه.

آزمایشها و ارزیابیها

برای اینکه ببینن VoXtream چطور عمل میکنه، یه سری آزمایشهای دقیق انجام دادن و اون رو با مدلهای دیگه مقایسه کردن.

تنظیمات آزمایش

- مجموعه داده (Dataset): برای آموزش از ترکیبی از دو مجموعه داده Emilia و HiFiTTS-2 استفاده شده که هم سبک گفتار خودجوش و هم سبک خواندن از روی متن رو پوشش میدن. از هر کدوم ۴.۵ هزار ساعت انتخاب شده که در مجموع ۹ هزار ساعت داده آموزشی میشه. روی دادهها یه سری پاکسازیها انجام شده، مثلا صداهایی که چند نفر همزمان صحبت میکردن یا کیفیت پایینی داشتن حذف شدن. برای همترازی فونمها از MFA و برای توکنیزه کردن صدا از کدک استریمینگ Mimi با فرکانس ۲۴ کیلوهرتز استفاده شده.

- مدل (Model): برای تمام بخشها از ترنسفورمر به سبک Llama استفاده شده. ترنسفورمر زمانی (TT) ۱۲ لایه و ۱۶ هد توجه داره. ترنسفورمر فونم (PT) ۶ لایه و ۸ هد داره و ترنسفورمر عمق (DT) ۴ لایه و ۸ هد داره. بخش DT از یه مدل از پیش آموزش دیده به اسم CSM-DT گرفته شده و وزنهاش در طول آموزش ثابت نگه داشته شده (frozen). برای استخراج ویژگیهای صدای گوینده هم از مدل ReDimNet (SPK-ENC) استفاده شده که روی بیش از ۱۰۰ هزار هویت مختلف آموزش دیده.

- آموزش (Training): مدلها روی دو تا پردازنده گرافیکی NVIDIA A100-80GB برای ۹ دوره (epoch) آموزش دیدن. ورودیها تکههای صوتی ۲۰ ثانیهای و فونمهای مربوط به اونها بودن.

- مدلهای پایه (Baselines): برای مقایسه، چندین مدل AR که به صورت عمومی در دسترس بودن انتخاب شدن. این مدلها به دو گروه بزرگ (Large) و متوسط (Mid) بر اساس حجم دادههای آموزشی تقسیم شدن تا مقایسه عادلانه باشه. مدلهایی مثل CosyVoice، Spark-TTS، VoiceCraft، XTTS-v2 و CosyVoice2 جزو این گروه بودن. برای ارزیابی استریمینگ هم از XTTS و CosyVoice2 استفاده شده.

روش ارزیابی

VoXtream روی سه مجموعه داده آزمایشی ارزیابی شد:

- LibriSpeech test-clean: برای ارزیابی وظیفه ادامه دادن یک جمله.

- SEED-TTS test-en: برای ارزیابی وظیفه بین جملهای.

- LibriSpeech long: یه زیرمجموعه از LibriSpeech که جملاتش طولانیتر از ۱۰ ثانیه هستن تا مقاومت مدل در حالت فول استریم سنجیده بشه.

برای ارزیابی از سه معیار مبتنی بر مدل استفاده شد:

- نرخ خطای کلمه (WER): برای سنجش وضوح و قابل فهم بودن صدا. این معیار تفاوت بین متن رونویسی شده از صدای تولیدی و متن اصلی رو اندازه میگیره.

- شباهت به گوینده (SPK-SIM): برای سنجش اینکه صدای تولید شده چقدر شبیه به صدای نمونه هست. این معیار با محاسبه شباهت کسینوسی بین امبدینگهای صدای نمونه و صدای تولیدی به دست میاد.

- کیفیت صدا (UTMOS): یه پیشبینیکننده خودکار برای امتیاز میانگین عقیده (MOS) که کیفیت کلی صدا رو میسنجه.

علاوه بر این، دو نظرسنجی از کاربران در پلتفرم Prolific برای ارزیابی طبیعی بودن صدا انجام شد. در مطالعه اول، ۴۰ شنونده بومی به طبیعی بودن صدای تولید شده توسط سیستمهای مختلف در مقیاس ۰ تا ۱۰۰ امتیاز دادن. در مطالعه دوم، ۳۰ شنونده بومی بین صدای دو سیستم در حالت فول استریم، یکی رو به عنوان گزینه بهتر انتخاب کردن.

در ارزیابی فول استریم، متن به صورت کلمه به کلمه به مدل داده میشد تا شرایطی مثل ورودی گرفتن از یه LLM شبیهسازی بشه. در این حالت دو معیار مهم هم اندازهگیری شد:

- تاخیر اولین بسته (FPL): زمان لازم برای تولید اولین فریم صوتی.

- ضریب همزمانی (RTF): نسبت مدت زمان صدای تولید شده به زمان واقعی که برای تولیدش صرف شده.

نتایج چه چیزی رو نشون میدن؟

نتایج آزمایشها نشون میده که VoXtream در مقایسه با رقبای خودش عملکرد خیلی خوبی داشته.

مقایسه کلی با مدلهای دیگه

جدول زیر نتایج VoXtream رو در کنار مدلهای پایه نشون میده.

| گروه | مدل | نوع توکن | حجم داده (ساعت) | تعداد پارامتر | SEED test-en | LibriSpeech test-clean | طبیعی بودن صدا (۹۵٪ CI) |

|---|---|---|---|---|---|---|---|

| – | انسان | – | – | – | WER: 2.17, SPK-SIM: 0.734, UTMOS: 3.53 | WER: 2.30, SPK-SIM: 0.664, UTMOS: 4.10 | ۵۸.۴ ± ۲.۵ |

| بزرگ | CosyVoice | BPE | ۱۷۰ هزار | ۴۱۶ میلیون | WER: 4.75, SPK-SIM: 0.635, UTMOS: 3.88 | WER: 3.75, SPK-SIM: 0.575, UTMOS: 4.09 | – |

| بزرگ | Spark-TTS | BPE | ۱۰۲ هزار | ۵۰۷ میلیون | WER: 3.29, SPK-SIM: 0.570, UTMOS: 3.94 | WER: 3.02, SPK-SIM: 0.513, UTMOS: 4.20 | – |

| بزرگ | Llasa-1B | BPE | ۲۵۰ هزار | ۱ میلیارد | WER: 3.18, SPK-SIM: 0.578, UTMOS: 4.08 | WER: 3.18, SPK-SIM: 0.490, UTMOS: 4.19 | – |

| بزرگ | VoiceStar | Phone | ۶۵ هزار | ۸۴۰ میلیون | WER: 2.91, SPK-SIM: 0.605, UTMOS: 3.92 | WER: 3.92, SPK-SIM: 0.509, UTMOS: 4.10 | – |

| بزرگ | CosyVoice2 | BPE | ۱۶۷ هزار | ۶۱۸ میلیون | WER: 2.87, SPK-SIM: 0.656, UTMOS: 4.18 | WER: 2.97, SPK-SIM: 0.587, UTMOS: 4.23 | – |

| بزرگ | FireRedTTS-1S | BPE | ۵۰۰ هزار | ۵۵۰ میلیون | WER: 2.66, SPK-SIM: 0.633, UTMOS: 3.62 | WER: 6.43, SPK-SIM: 0.540, UTMOS: 3.82 | – |

| متوسط | VoiceCraft | Phone | ۹ هزار | ۸۳۰ میلیون | WER: 3.77, SPK-SIM: 0.515, UTMOS: 3.63 | WER: 3.11, SPK-SIM: 0.444, UTMOS: 3.90 | ۵۳.۶ ± ۲.۵ |

| متوسط | XTTS-v2 | BPE | ۲۷ هزار | ۴۷۰ میلیون | WER: 3.64, SPK-SIM: 0.467, UTMOS: 3.57 | WER: 3.90, SPK-SIM: 0.444, UTMOS: 3.72 | ۵۳.۸ ± ۲.۷ |

| متوسط | VoXtream-NS | Phone | ۹ هزار | ۴۷۱ میلیون | WER: 3.64, SPK-SIM: 0.537, UTMOS: 3.89 | WER: 2.99, SPK-SIM: 0.465, UTMOS: 4.07 | ۵۱.۸ ± ۲.۶ |

| استریم | CosyVoice2:Out | BPE | ۱۶۷ هزار | ۶۱۸ میلیون | WER: 2.70, SPK-SIM: 0.662, UTMOS: 4.05 | WER: 2.65, SPK-SIM: 0.592, UTMOS: 4.19 | ۶۰.۶ ± ۲.۴ |

| استریم | XTTS-v2:Out | BPE | ۲۷ هزار | ۴۷۰ میلیون | WER: 3.99, SPK-SIM: 0.480, UTMOS: 3.59 | WER: 4.06, SPK-SIM: 0.440, UTMOS: 3.64 | ۵۳.۰ ± ۲.۷ |

| استریم | VoXtream:Out | Phone | ۹ هزار | ۴۷۱ میلیون | WER: 3.82, SPK-SIM: 0.529, UTMOS: 3.88 | WER: 3.09, SPK-SIM: 0.461, UTMOS: 4.08 | ۵۳.۴ ± ۲.۵ |

| استریم | VoXtream:Full | Phone | ۹ هزار | ۴۷۱ میلیون | WER: 3.81, SPK-SIM: 0.529, UTMOS: 3.90 | WER: 3.15, SPK-SIM: 0.458, UTMOS: 4.07 | ۵۱.۹ ± ۲.۶ |

- در مقایسه با مدلهای هماندازه (گروه متوسط): VoXtream بهترین امتیاز رو در معیارهای شباهت به گوینده (SPK-SIM) و کیفیت (UTMOS) به دست آورده و از نظر نرخ خطای کلمه (WER) هم قابل رقابت هست.

- حفظ کیفیت در حالت استریم: حتی با نگاه به جلوی محدود، کیفیت VoXtream بالا باقی میمونه و فقط افت خیلی کمی در WER و SPK-SIM نسبت به نسخه غیر استریمینگ (NS) خودش داره.

- در مقایسه با مدلهای بزرگ: با اینکه VoXtream روی دادههای خیلی کمتری آموزش دیده، به عملکرد مدلهایی مثل Spark-TTS و CosyVoice نزدیک شده و همزمان قابلیت استریمینگ رو هم ارائه میده. علاوه بر این، VoXtream دومین WER برتر رو در بین تمام سیستمها روی مجموعه داده LibriSpeech test-clean به دست آورده که نشون دهنده وضوح بالای صدای تولیدی هست.

- ارزیابی ذهنی: نتایج نظرسنجیها هم نشون میده که نسخه استریمینگ VoXtream با مدلهای غیر استریمینگ مثل VoiceCraft و XTTS قابل مقایسه هست.

ارزیابی فول استریم در جملات طولانی

در این بخش، VoXtream با CosyVoice2 روی جملات طولانی مقایسه شد.

| مدل | WER (%) | SPK-SIM | UTMOS | ترجیح کاربران (%) |

|---|---|---|---|---|

| انسان | ۱.۹۷ | ۰.۷۸۴ | ۴.۱۶ | – |

| CosyVoice2:Full | ۶.۱۱ | ۰.۶۸۵ | ۴.۱۹ | ۳۱ |

| VoXtream:Full | ۳.۲۴ | ۰.۵۶۴ | ۴.۲۳ | ۵۷ |

همونطور که در جدول بالا مشخصه، VoXtream نرخ خطای کلمه خیلی کمتری نسبت به CosyVoice2 داره. در ارزیابی ذهنی هم کاربران به طور قابل توجهی صدای تولید شده توسط VoXtream رو ترجیح دادن. CosyVoice2 به خاطر رمزگشای NAR مبتنی بر فلو مچینگ، شباهت به گوینده بهتری داره، اما این به قیمت تاخیر اولیه بالا (FPL) به دست میاد.

تاخیر بسیار کم: برگ برنده VoXtream

یکی از مهمترین دستاوردهای VoXtream، تاخیر اولیه فوقالعاده پایین اون هست.

| مدل | FPL (میلیثانیه) | RTF |

|---|---|---|

| CosyVoice2 | ۱۶۴۳ | ۰.۸۵ |

| XTTS-v2 | ۲۹۵ | ۰.۳۷ |

| XTTS-v2:DS | ۱۹۶ | ۰.۲۶ |

| VoXtream | ۱۷۱ | ۱.۰۰ |

| VoXtream:TC | ۱۰۲ | ۰.۱۷ |

VoXtream کمترین FPL رو در بین مدلهای TTS استریمینگ عمومی داره و با استفاده از torch.compile این زمان به ۱۰۲ میلیثانیه میرسه. این سیستم بدون هیچ شتابدهنده اضافهای به صورت همزمان (real-time) روی GPU اجرا میشه (RTF=1.00) و با torch.compile حتی سریعتر از زمان واقعی عمل میکنه (RTF=0.17) که بهترین عملکرد در بین رقبای استریمینگ هست.

بررسی اجزای مختلف مدل (Ablation Study)

برای اینکه مشخص بشه هر کدوم از اجزای مدل چقدر در عملکرد نهایی تاثیر دارن، یه مطالعه حذفی انجام شد. در این مطالعه، تاثیر دو بخش کلیدی یعنی رمزگذار گوینده (SPK-ENC) و ترنسفورمر عمق از پیش آموزش دیده (CSM-DT) بررسی شد.

| CSM-DT | SPK-ENC | WER (%) | SPK-SIM | UTMOS |

|---|---|---|---|---|

| ✗ | ✗ | ۳.۵۳ | ۰.۴۷۱ | ۳.۳۹ |

| ✓ | ✗ | ۳.۷۰ | ۰.۵۰۴ | ۳.۹۰ |

| ✗ | ✓ | ۳.۶۵ | ۰.۵۵۸ | ۳.۳۹ |

| ✓ | ✓ | ۳.۶۴ | ۰.۵۳۷ | ۳.۸۹ |

نتایج نشون میده که:

- استفاده از CSM-DT به طور قابل توجهی کیفیت و شباهت به گوینده رو از طریق انتقال دانش بهبود میده.

- استفاده از SPK-ENC شباهت به گوینده رو تا ۱۹ درصد در حالت zero-shot (وقتی DT از اول آموزش داده میشه) و تا ۶ درصد (وقتی DT ثابت هست) افزایش میده.

- از نظر وضوح صدا، مدل پایه (بدون این دو بخش) بهترین WER رو به دست آورده که نشوندهنده کارایی روش پیشنهادی هست. افزایش جزئی WER در سیستم نهایی، قابل توجه نیست.

دیدگاهتان را بنویسید