خلاصه

- یک گزارش جدید نشون میده مدلهای هوش مصنوعی منبع باز روی سرویسدهندههای مختلف (مثل مایکروسافت، آمازون و…) اصلا یک جور کار نمیکنن.

- این تفاوتها هم توی سرعت و هزینه هست، هم توی دقت و عملکرد روی تسکهای تخصصی مثل ریاضی.

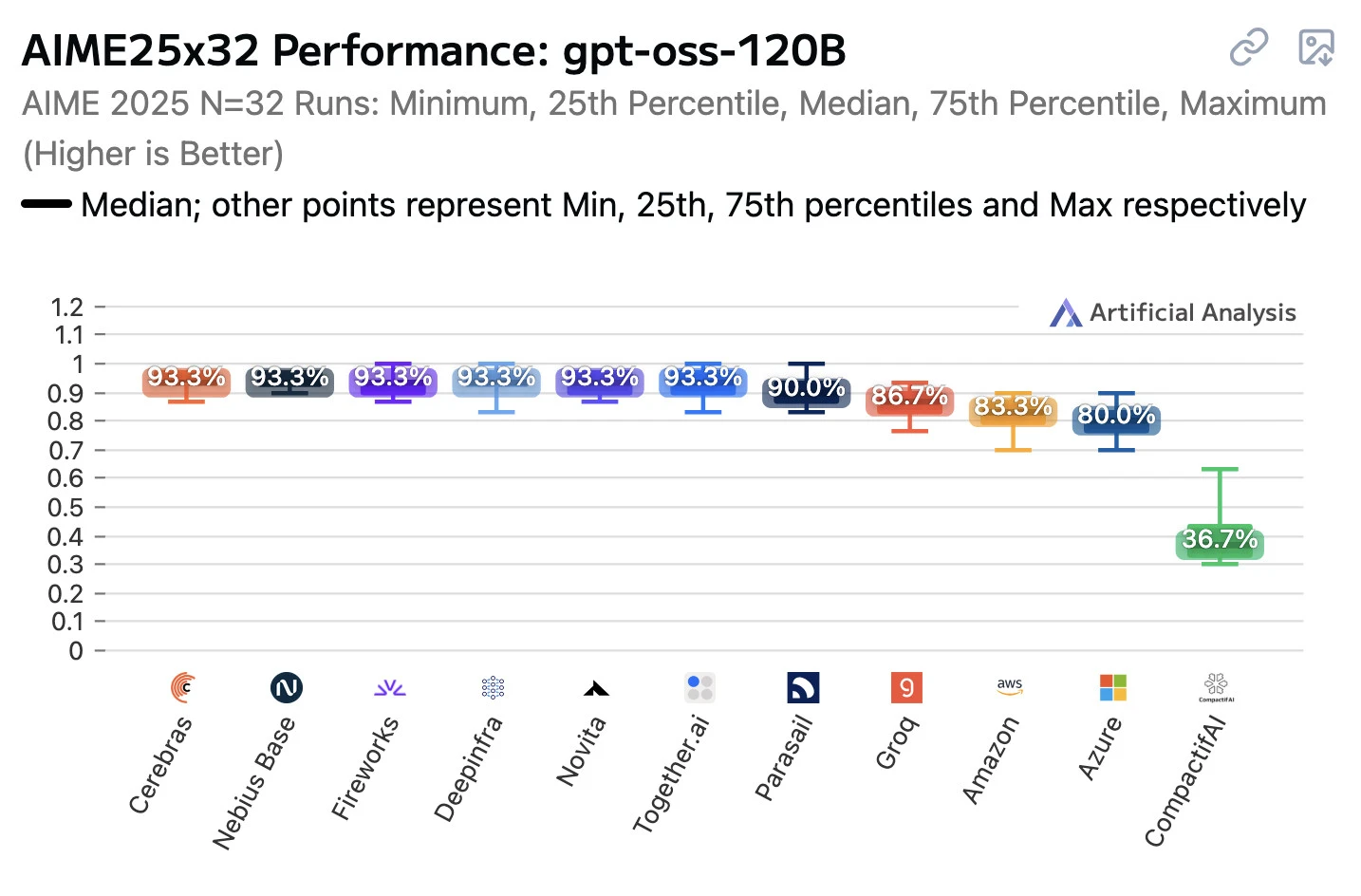

- مثلاً توی آزمون ریاضی AIME، بعضی سرویسدهندهها بالای ۹۰ درصد امتیاز گرفتن، ولی بعضیها کمتر از ۴۰ درصد.

- دلیل این ناهماهنگی میتونه استفاده از نسخههای مختلف فریمورکهای اجرایی (مثل vLLM) یا فشردهسازی مدل باشه.

- این موضوع یه چالش برای مشتریها ایجاد میکنه، چون نمیدونن دقیقاً چه کیفیتی رو دریافت میکنن.

- راه حل پیشنهاد شده، داشتن تستهای سازگاریه که اوپنایآی هم برای مدل gpt-oss داره انجامش میده تا پیادهسازیها استاندارد بشن.

فکر کن یه مدل هوش مصنوعی مثل gpt-oss-120B رو از چند تا شرکت مختلف اجاره کنی. منطقیه که انتظار داشته باشی همشون یه جور کار کنن، درسته؟ اما یه گزارش جدید از Artificial Analysis نشون میده که داستان اصلا اینطوری نیست. این گزارش عملکرد این مدل رو روی سرویسدهندههای مختلفی مثل مایکروسافت آژور، آمازون بدارک، Groq، Together.ai، گوگل، Fireworks، Cerebras، Deepinfra، Nebius، Parasail، CompactifAI، vLLM و Novita بررسی کرده و نتایج جالبی به دست اومده.

مقایسه کلی سرویسدهندهها

بیایید نگاهی به خلاصهای از نتایج این بررسی بندازیم تا ببینیم هر شرکت توی چه زمینهای بهتر عمل کرده:

- سرعت خروجی (توکن در ثانیه): توی این بخش، Cerebras با ۲۹۳۸ توکن در ثانیه و Groq با ۵۸۹ توکن در ثانیه سریعترینها بودن. بعد از اونها هم Novita با ۲۶۸، Google Vertex با ۲۶۰ و Fireworks با ۲۵۵ توکن در ثانیه قرار گرفتن.

- تاخیر یا لیتنسی (زمان تا دریافت اولین توکن): اگه سرعت پاسخ اولیه براتون مهمه، Groq با ۰.۲۱ ثانیه و Deepinfra با ۰.۲۲ ثانیه کمترین تاخیر رو داشتن. Cerebras با ۰.۲۴ ثانیه، CompactifAI با ۰.۲۷ ثانیه و Parasail با ۰.۳۹ ثانیه هم در ردههای بعدی هستن.

- قیمت ترکیبی (به ازای هر یک میلیون توکن): از نظر هزینه، CompactifAI با ۰.۱۰ دلار و Deepinfra با ۰.۱۸ دلار به صرفهترین گزینهها بودن. Novita با ۰.۲۰ دلار، Parasail با ۰.۲۶ دلار و آمازون با ۰.۲۶ دلار هم قیمتهای مناسبی داشتن.

- قیمت توکن ورودی: برای هزینه پردازش متن ورودی شما، باز هم CompactifAI با ۰.۰۵ دلار و Deepinfra با ۰.۰۹ دلار ارزونترین بودن. بعد از اونها Novita با ۰.۱۰ دلار، Parasail با ۰.۱۵ دلار و آمازون با ۰.۱۵ دلار قرار دارن.

- قیمت توکن خروجی: برای متنی که مدل تولید میکنه، CompactifAI با ۰.۲۳ دلار و Deepinfra با ۰.۴۵ دلار کمترین قیمت رو داشتن و بعد از اونها Novita با ۰.۵۰ دلار، Parasail با ۰.۶۰ دلار و آمازون با ۰.۶۰ دلار قرار گرفتن.

نتایج عجیب در آزمونهای تخصصی

جایی که تفاوتها واقعا عجیب و غریب میشه، توی آزمونهای تخصصی هست. برای مثال، در آزمون ریاضیات پیشرفته AIME 2025 که ۳۲ بار روی هر سرویسدهنده اجرا شد، نتایج خیلی متفاوت بود:

- امتیاز ۹۳.۳ درصد: Cerebras، Nebius Base، Fireworks، Deepinfra، Novita، Together.ai و vLLM 0.1.0

- امتیاز ۹۰.۰ درصد: Parasail

- امتیاز ۸۶.۷ درصد: Groq

- امتیاز ۸۳.۳ درصد: Amazon

- امتیاز ۸۰.۰ درصد: Azure

- امتیاز ۳۶.۷ درصد: CompactifAI

این اختلاف عملکرد خیلی زیاده. بیشتر شرکتهایی که امتیاز ۹۳.۳ درصد گرفتن، از آخرین نسخه vLLM استفاده میکردن (به جز Cerebras که ظاهرا سیستم اختصاصی خودشو داره).

شرکت CompactifAI که کمترین امتیاز رو گرفت، قبلا در یک بیانیه مطبوعاتی اعلام کرده بود که مدلهاش «نسخههای خیلی فشردهشده از مدلهای منبع باز پیشرو هستن که دقت اصلی رو حفظ میکنن، ۴ تا ۱۲ برابر سریعترن و ۵۰ تا ۸۰ درصد هزینههای پردازش رو کاهش میدن». این موضوع میتونه دلیل امتیاز پایینترشون رو توضیح بده.

در مورد امتیاز ۸۰ درصدی مایکروسافت آژور، لوکاس پیکاپ از این شرکت تایید کرد که مشکل به خاطر استفاده از یک نسخه قدیمی vLLM بوده که الان برطرف شده. به گفته اون، نسخه قدیمی به تنظیمات مربوط به «میزان تلاش برای استدلال» (reasoning effort) توجه نمیکرده و همه درخواستها رو با کیفیت متوسط پردازش میکرده. هنوز خبری در مورد دلیل عملکرد ضعیفتر نسخه آمازون بدارک منتشر نشده.

چالشی برای مشتریان مدلهای منبع باز

این نتایج نشون میده که به عنوان مشتری، باید به چیزهایی فکر کنیم که قبلا شاید بهشون توجه نمیکردیم. البته این موضوع خیلی هم غافلگیرکننده نیست. وقتی خودمون مدلی رو اجرا میکنیم، باید در مورد فریمورک اجرایی (مثلا GGPF/llama.cpp یا MLX) و اندازه کوانتیزیشن (Quantization) تصمیم بگیریم. میدونیم که کوانتیزیشن روی عملکرد تاثیر داره اما اندازهگیری این تاثیر سخته.

حالا به نظر میرسه حتی دونستن اینکه یک سرویسدهنده از چه کوانتیزیشنی استفاده میکنه، برای پیشبینی عملکرد مدل کافی نیست. این یک چالش کلی برای مدلهای منبع بازه. معمولا این مدلها به صورت یک سری وزن منتشر میشن و دستورالعملهای کلی برای اجرا روی یک پلتفرم دارن. کارهایی مثل کوانتیزیشن و تبدیل فرمت معمولا به جامعه کاربری و شرکتهای ثالث سپرده میشه.

خیلی چیزها میتونه در این فرایند اشتباه پیش بره. برای مثال قابلیت «فراخوانی ابزار» (Tool Calling) به این تفاوتها خیلی حساسه. مدلها برای استفاده از یک فرمت خاص برای این قابلیت آموزش دیدن و اگه یک سرویسدهنده اون رو دقیق پیادهسازی نکنه، نتایج غیرقابل پیشبینی میشه و پیدا کردن مشکل هم سخته.

چیزی که میتونه خیلی کمک کنه، داشتن یک جور «مجموعه تست انطباق» هست. اگه مدلها عملکرد قطعی و مشخصی داشتن، میشد یک سری تست منتشر کرد تا سرویسدهندهها یا مشتریان بتونن با اجرای اونها از پیادهسازی درست مدل مطمئن بشن.

اما مدلها حتی با دمای صفر هم عملکرد قطعی ندارن. شاید همین تلاش جدید Artificial Analysis دقیقا همون چیزیه که بهش نیاز داریم، مخصوصا که اجرای یک مجموعه کامل از بنچمارکها روی یک سرویسدهنده میتونه از نظر هزینه توکن خیلی گرون باشه.

جالبه بدونید که به گفته دومینیک کوندل از OpenAI، این شرکت حالا یک تست سازگاری در مخزن GitHub مدل gpt-oss قرار داده تا به سرویسدهندهها کمک کنه مطمئن بشن که مواردی مثل تمپلیتهای فراخوانی ابزار رو درست پیادهسازی کردن. جزئیات بیشتر این موضوع در راهنمای «تایید پیادهسازیهای gpt-oss» توضیح داده شده.

دیدگاهتان را بنویسید