- اهداف:

- یاد میگیریم مدل اقدام بزرگ یا LAM چیه و چه فرقی با بقیه مدلهای هوش مصنوعی داره.

- با کاربردهای مختلفش توی زندگی روزمره و محیطهای کاری آشنا میشیم.

- چالشها و نکات مهمی که توی استفاده از این مدلها وجود داره رو میفهمیم.

فصل اول: مدل اقدام بزرگ (LAM) اصلا چی هست؟

وقتی تیمها و شرکتها میخوان یک سری کارهای خودکار و اتوماتیک رو با هوش مصنوعی انجام بدن، متوجه میشن که ساختن سیستمهای جداگونه برای هر کار مشخص، محدودیتهای خودشو داره. اینجا مفهومی به اسم «مدلهای اقدام بزرگ» یا LAM (مخفف Large Action Models) وارد بازی میشه. این مدلها مثل یک لایه زیرساختی عمل میکنن و قابلیتهای عمومی مثل درک کردن، برنامهریزی کردن و اجرا کردن کارها رو فراهم میکنن. به این ترتیب، به جای اینکه برای هر کاری یک ابزار اتوماسیون جدا بسازیم، میشه از این مدلها استفاده کرد تا سیستمهای هوشمند تواناتر و سازگارتری بسازیم که میتونن توی موقعیتها و برنامههای مختلف کار کنن.

LAM ها یه جورایی دنیای هوش مصنوعی رو از تولید محتوای صرف، به سمت انجام دادن کارها هل میدن. مدلهای زبانی بزرگ (LLM) توی تولید و درک متن عالی هستن و مدلهای زبان بصری (VLM) متن و تصویر رو با هم پردازش میکنن. اما LAM ها برای این طراحی شدن که به صورت خودکار، مراحل مختلف یک کار رو توی محیطهای دیجیتال یا حتی فیزیکی درک کنن، براش برنامهریزی کنن و در نهایت اجرا کنن. در حالی که مامورهای هوش مصنوعی (AI agents) میتونن کارهای مشخص و خودکاری رو انجام بدن، LAM ها نقش معماری اصلی رو بازی میکنن که اجازه میده سیستمهای هوشمند عمومیتری ساخته بشن که با زبان کار میکنن و توی حوزههای متنوعی فعالیت دارن.

تفاوت اصلی در روش کارشونه. یک LLM میتونه به شما بگه چجوری بلیط هواپیما رزرو کنید. یک VLM میتونه اسکرینشات صفحه رزرو رو تحلیل کنه. اما یک LAM واقعا وارد سایت میشه و رزرو رو برای شما کامل میکنه. البته، مدلهای فعلی بیشتر توی محیطهای کنترل شده و مشخص بهترین عملکرد رو دارن. خیلی از این مدلها با ترکیب ماژولهای درک عصبی و برنامهریزهای نمادین توی یک معماری «عصبی-نمادین» به این توانایی میرسن، هرچند بعضی از سیستمهای جدیدتر فقط به یک شبکه عصبی یکپارچه متکی هستن.

اتفاقات اخیر هم این پتانسیل رو تایید کرده. مامور چتجیپیتی (ChatGPT agent) که توسط OpenAI در جولای ۲۰۲۵ عرضه شد، اولین پیادهسازی بزرگ و عمومی از یک سیستم LAM یکپارچه به حساب میاد. این سیستم با ترکیب قابلیتهای وبگردی، تحقیق عمیق و دسترسی به ترمینال توی یک مدل واحد، نشون میده که LAM ها چطور میتونن از محیطهای کنترل شده خارج بشن و کارهای پیچیده و چند مرحلهای رو توی برنامههای مختلف انجام بدن. این سیستم تونست توی بنچمارکهایی مثل Humanity’s Last Exam با دقت ۴۱.۶ درصد و FrontierMath با دقت ۲۷.۴ درصد به عملکرد بالایی برسه و همزمان کنترلهای امنیتی لازم برای استفادههای شرکتی رو هم حفظ کنه.

در مورد مامور چتجیپیتی، مدل اقدام بزرگ اصلی به صورت جداگانه در دسترس نیست؛ OpenAI اون رو به شکل یک سرویس مدیریت شده با محافظهای امنیتی ارائه میده. بعضیها ممکنه بگن که «LAM» خود مدل داخل این سرویسه، در حالی که «ChatGPT Agent» یک مامور هوشمنده که با قدرت یک LAM کار میکنه.

فصل دوم: LAM ها کجا به کار میان؟ از دستیار شخصی تا کارهای پیچیده شرکتی

مدلهای اقدام بزرگ دارن از یک مفهوم تئوری به یک واقعیت عملی تبدیل میشن و میتونن کارهای پیچیده و چند مرحلهای که قبلا فقط انسانها انجام میدادن رو به عهده بگیرن. توی حوزه مصرفکننده، این تکنولوژی داره توی گوشیهای موبایل خودش رو نشون میده. مثلا:

- Google Gemini Live: اطلاعات شخصی شما رو بین برنامههای مختلف سازماندهی میکنه.

- دستیارهای شخصی مثل Motorola LAM یا Rabbit R1: کارهایی مثل سفارش غذا یا گرفتن تاکسی رو انجام میدن. البته، پیادهسازیهای اولیه این دستیارها نتایج متفاوتی در دنیای واقعی داشتن.

همین قدرت داره برای بهینهسازی عملیاتهای تجاری هم استفاده میشه. توی شرکتها، مامورهای ServiceNow میتونن کارهای داخلی مربوط به IT و منابع انسانی رو خودکار کنن. ابزارهای تخصصیتری مثل «آلیس» (Alice) از شرکت 11x هم هستن که کارهای بیرونی مثل تحقیق در مورد مشتریان بالقوه و ارتباط با اونها برای فروش رو انجام میدن. به همین شکل، مامورهای تخصصی مثل Shortcut دارن برای خودکار کردن کارهای فکری پیچیده توی برنامههای خاص، مثل مدلسازی و تحلیل دادههای چند مرحلهای توی مایکروسافت اکسل، ظهور میکنن.

عرضه مامور چتجیپیتی یک نقطه عطف مهم در بلوغ LAM هاست، چون اولین سیستم یکپارچهایه که به صورت گسترده در دسترسه و چندین قابلیت رو با هم ترکیب کرده. برخلاف ابزارهای تخصصی قدیمیتر، مامور چتجیپیتی وبگردی بصری، تحقیق مبتنی بر متن، دسترسی به ترمینال و اتصال به API رو توی یک مدل واحد جمع کرده. این رویکرد معماری اجازه میده که سیستم به راحتی بین حالتهای مختلف جابجا بشه؛ مثلا اطلاعات تقویم رو از طریق API بگیره، محتوای یک وبسایت رو با پردازش متن تحلیل کنه و یک تراکنش رو با دستکاری رابط کاربری بصری تکمیل کنه.

برای تیمهای توسعه، این یعنی یک تغییر بزرگ: به جای اینکه چند مامور تخصصی رو با هم ترکیب کنن، حالا میتونن از یک LAM زیرساختی استفاده کنن که خودش رو بر اساس نیازهای کار تطبیق میده. توانایی این سیستم در تولید فایلهای قابل ویرایش (مثل پاورپوینت، اکسل و کد) در حالی که زمینه و مفهوم رو بین ابزارهای مختلف حفظ میکنه، ارزش عملی معماریهای یکپارچه LAM رو در مقایسه با روشهای زنجیرهای کردن ابزارها نشون میده.

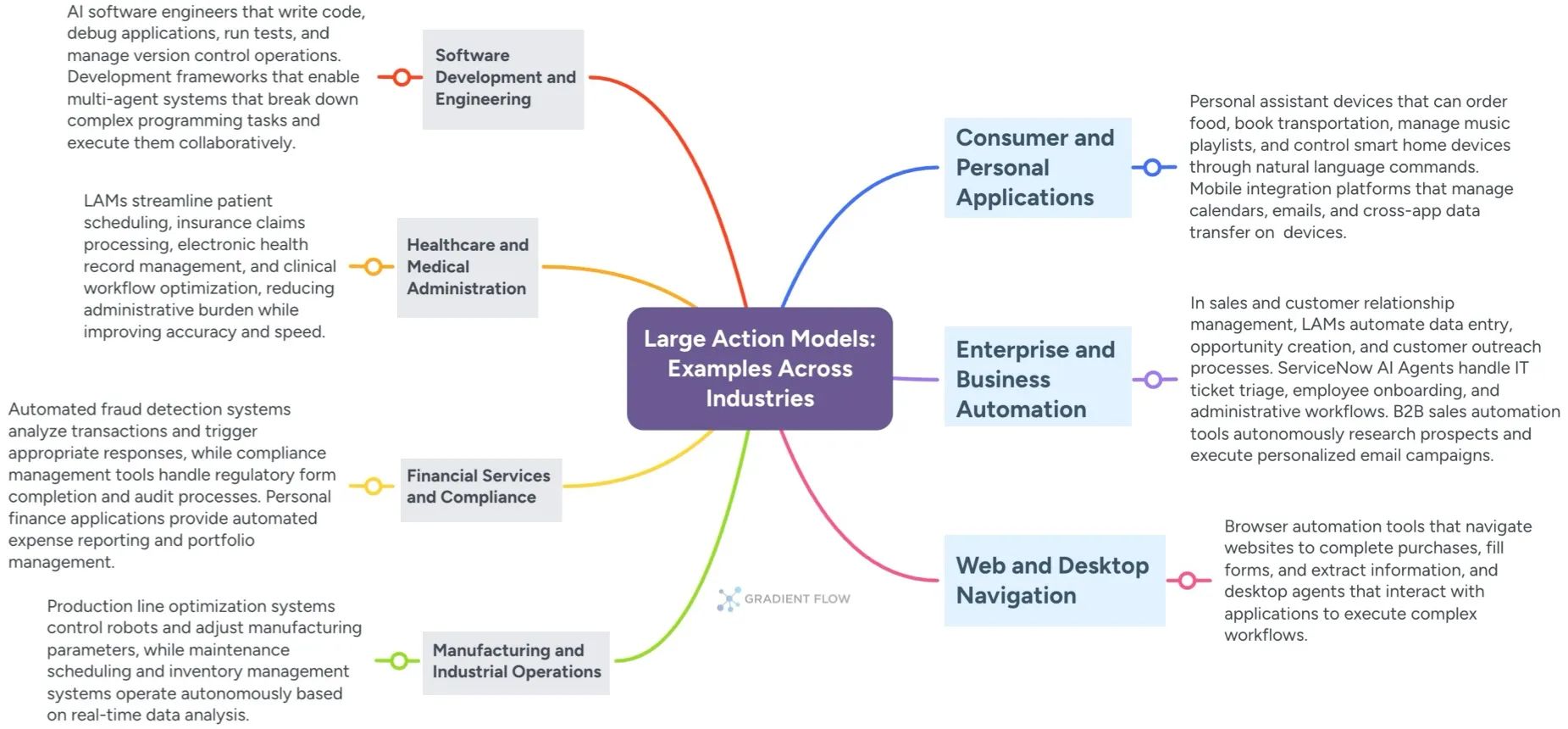

کاربرد LAM ها به حوزههای بسیار تخصصی و قانونمند هم کشیده شده. در مهندسی نرمافزار، توسعهدهندههای هوش مصنوعی مثل Cognition Devin تلاش میکنن به صورت مستقل کد بنویسن، تست کنن و اشکالزدایی کنن. فریمورکهایی مثل Microsoft AutoDev هم تیمهایی از مامورهای هوشمند رو برای پروژههای برنامهنویسی پیچیده هماهنگ میکنن. توی بخشهای پر از داده مثل بهداشت و درمان و امور مالی، این مدلها با مدیریت زمانبندی بیماران و درخواستهای بیمه، بار کارهای اداری رو کم میکنن. یا با تحلیل آنی کلاهبرداری و خودکارسازی گزارشهای قانونی، امنیت و تطابق با مقررات رو افزایش میدن. از کنترل رباتهای صنعتی در کارخونه گرفته تا گشت و گذار در وبسایتها و برنامههای دسکتاپ، LAM ها قابلیتهای اساسی رو برای دوره جدیدی از اتوماسیون دیجیتال و فیزیکی فراهم میکنن.

فصل سوم: وضعیت فعلی و نگاه صنعت به LAM ها

چشمانداز LAM ها حول محور قابلیت استفاده در دنیای واقعی شکل گرفته و مامور چتجیپیتی یک معیار جدید برای سیستمهای هوشمند یکپارچه تعریف کرده. تصمیم OpenAI برای کنار گذاشتن ابزار مستقل Operator به نفع رویکرد مامور یکپارچه، نشون میده که صنعت به سمت پلتفرمهای جامع LAM حرکت میکنه، نه ابزارهای تخصصی و جداگونه.

برای تیمهای شرکتی که دارن به استفاده از LAM فکر میکنن، این یکپارچگی تصمیمگیری رو سادهتر میکنه. به جای اینکه بین ابزارهای جدا برای وبگردی، تحقیق و اتوماسیون یکی رو انتخاب کنن، حالا میتونن از سیستمهای یکپارچهای استفاده کنن که تعاملات چند حالته رو مدیریت میکنن. معیارهای عملکرد مامور چتجیپیتی، مثل ۴۵.۵ درصد دقت در کارهای مربوط به اکسل و ۶۸.۹ درصد دقت در بنچمارکهای تحقیقاتی وب، یک خطکش مشخص برای ارزیابی تواناییها فراهم میکنه.

بعد از بررسی تیمهایی که دارن مدلهای اقدام بزرگ رو ارزیابی میکنن، میشه دید که دو دیدگاه متفاوت وجود داره. بعضی از تیمهای شرکتی واقعا از افزایش بهرهوری که میبینن هیجانزده هستن، به خصوص توی خودکارسازی جریانهای کاری که LAM ها میتونن اون فرآیندهای خستهکننده و چند مرحلهای که وقت توسعهدهندهها رو میگیره، انجام بدن. اما یک شک و تردید منطقی هم وجود داره، مخصوصا بعد از اینکه بعضی از محصولات مصرفکننده پر سر و صدا مثل Rabbit R1 در شروع کارشون لغزش داشتن. بحث اغلب به این سمت میره که آیا ما شاهد یک تغییر واقعی در مفهوم استقلال ماشینها هستیم، یا فقط با یک شکل پیچیدهتر و شاید شکنندهتر از زنجیره ابزارها طرفیم که توی یک بستهبندی جدید ارائه شده.

واقعیت اینه که بیشتر پیادهسازیهای امروزی LAM ها توی سناریوهای محدود و کاملا تعریف شده خوب کار میکنن، اما با غیرقابل پیشبینی بودن محیطهای واقعی مشکل دارن. داستانهای موفقیت معمولا از پیادهسازیهای با دقت کنترل شده میان که در اونها محدوده اقدامات مشخصه و محیط پایداره.

عرضه مامور چتجیپیتی، حس و حال صنعت رو از ارزیابی محتاطانه به سمت برنامهریزی کمی فعالتر تغییر داده. اونهایی که زودتر شروع به استفاده کردن، موفقیتهای خوبی رو توی خودکارسازی کارهای فکری گزارش میدن؛ مثل تحلیل رقبا، مدلسازی مالی و تولید ارائهها، یعنی جاهایی که توانایی مامور در ترکیب تحقیق و تولید محتوا ارزش فوری داره. با این حال، محدودیت ۴۰۰ پیام در ماه برای کاربران Pro و ۴۰ پیام برای بقیه سطوح، نشون میده که حتی LAM های در حال تولید هم نیاز به مدیریت مصرف دارن، چون سازمانها استفاده ازشون رو گسترش میدن.

کنترلهای امنیتی که در مامور چتجیپیتی تعبیه شده، مثل گرفتن تایید صریح از کاربر برای اقدامات مهم و حالت «نظارت» یا «Watch Mode» برای کارهای حساس مثل ارسال ایمیل، به نگرانیهای شرکتها در مورد سیستمهای خودکار پاسخ میده. این کنترلها یک رویکرد عملگرایانه برای پیادهسازی LAM هستن که نظارت کاربر رو در اولویت قرار میدن و همزمان اجازه میدن کارهای روتین خودکار بشن.

با عملیتر شدن LAM ها، سازمانهای حساس به امنیت احتمالا همون استراتژی اولیه خودشون برای پذیرش سرویسهای ابری رو در پیش میگیرن و با همون احتیاطی که در ابتدا نسبت به کلاد داشتن، جلو میرن. نگرانیها در مورد افزایش سطح حمله واقعی هستن. وقتی به یک سیستم هوش مصنوعی این قابلیت رو میدی که از طرف شما در چندین برنامه اقدام کنه، انگار داری «کلیدهای پادشاهی دیجیتال» خودت رو بهش میدی. در همین حال، نگرانی از حذف شغلها در نقشهای خدمات مشتری و اداری کاملا محسوسه، هرچند به نظر میرسه تیمهایی که LAM ها رو به عنوان ابزاری برای تقویت نیروها و نه جایگزینی اونها معرفی میکنن، تجربه پذیرش بسیار روانتری دارن.

فصل چهارم: اولویتهای توسعه و درسهایی که گرفتیم

خب، از اینجا به بعد چه مسیری در پیشه؟ پیادهسازی مامور چتجیپیتی، فاز بعدی اولویتهای توسعه LAM ها رو مشخص میکنه. محدودیتهای استفاده (۴۰ تا ۴۰۰ پیام در ماه) نشون میده که بهینهسازی بهرهوری برای انجام حداکثر کار با تعاملات محدود، یک نیاز اساسیه. عملکرد سیستم، با اینکه امیدوارکنندهست، نشون میده که تولید فایلها و اسناد نیاز به بهبود قابل توجهی داره تا با استانداردهای حرفهای مطابقت داشته باشه.

پذیرش شرکتی، نیاز به کنترلهای امنیتی پیشرفتهتر، مسیرهای حسابرسی و چارچوبهای تطابق با مقررات رو افزایش میده. محافظهای امنیتی فعلی سیستم در برابر ریسکهای بیولوژیکی و حملات تزریق پرامپت، یک سطح پایه از انتظارات امنیتی رو تعیین میکنه که LAM های آینده باید اونها رو برآورده کنن یا ازشون فراتر برن.

درسهایی از پیادهسازی مامور چتجیپیتی

پیادهسازیهای اولیه مامور چتجیپیتی، دیدگاههای مشخصی رو برای تیمهایی که قصد دارن LAM رو به کار بگیرن فراهم میکنه:

- تصمیمهای معماری: رویکرد مدل یکپارچه (ترکیب وبگردی، تحقیق و دسترسی به ترمینال) برای تجربه کاربری موثرتر از معماریهای میکروسرویسه، هرچند پیچیدگی کنترلهای امنیتی و مدیریت منابع رو بیشتر میکنه.

- الگوهای استفاده: استفاده در دنیای واقعی بیشتر به سمت خودکارسازی کارهای فکری میره (ترکیب تحقیقات، تولید اسناد و تحلیل داده) تا تعاملات وب تراکنشی مثل خرید آنلاین. این نشون میده که پیادهسازی LAM ها باید گردش کارهای تولید محتوا رو در اولویت قرار بده.

- توازن بین ایمنی و عملکرد: نیاز به تایید کاربر برای اقدامات مهم، کمی اصطکاک ایجاد میکنه اما برای پذیرش شرکتی ضروریه. تیمهایی که LAM رو پیادهسازی میکنن باید برای گردش کارهای تایید برنامهریزی کنن که مزایای اتوماسیون رو با تحمل ریسک سازمانی متعادل کنه.

- استراتژیهای یکپارچهسازی: چارچوب اتصالدهندهها (مثل اتصال به Gmail و GitHub) نشون میده که LAM ها چطور میتونن برنامههای تجاری موجود رو گسترش بدن، نه اینکه جایگزینشون بشن. این رویکرد که اولویت رو به یکپارچهسازی میده، پیچیدگی پیادهسازی رو کم میکنه و ارزش سازمانی رو به حداکثر میرسونه.

منابع

- [۱] The Next Generation of AI Agents: Large Action Models Explained – Gradient Flow

دیدگاهتان را بنویسید