خلاصه

- چتبات کلاد از این پس میتونه به مکالمات پایان بده.

- فقط تو موارد خیلی خاص و وقتی کاربر درخواستهای مضر یا توهینآمیز بده و کلاد نتونه مکالمه رو به مسیر درست ببره، فعال میشه.

- تستها نشون دادن وقتی کلاد با درخواستهای خیلی مضر روبرو میشه، لحنش حالت پریشانی یا استرس پیدا میکنه.

- این قابلیت الان روی مدلهای Claude Opus 4 و ۴.۱ فعاله و کاربر بعدش میتونه یه چت جدید باز کنه.

شرکت انتروپیک (Anthropic) که سازنده چتبات معروف کلاد (Claude) هست، یه ویژگی معرفی کرده که کمتر کسی انتظارش رو داشت. این استارتاپ به بعضی از مدلهای هوش مصنوعیش این قابلیت رو داده که بتونن به مکالمه با کاربرها پایان بدن. این کار به عنوان بخشی از یک پروژه تحقیقاتی در زمینه «رفاه مدل» (model welfare) انجام شده.

کلاد میتونه مکالمه رو تموم کنه

بله، درست خوندید. این چتبات در شرایط خیلی خاصی میتونه خودش مکالمه رو تموم کنه. البته انتروپیک میگه این قابلیت برای این طراحی نشده که از کاربر انسانی محافظت کنه، بلکه برای خود مدل هوش مصنوعی در نظر گرفته شده.

شرکت توضیح میده که «این یک ویژگی تجربیه و فقط برای استفاده کلاد به عنوان آخرین راه حل در موارد شدید مکالمههای مداوم مضر و توهینآمیز در نظر گرفته شده». یعنی قرار نیست سر هر بحثی این اتفاق بیفته و انتروپیک تاکید داره که اکثر کاربرها هیچوقت با این قابلیت مواجه نمیشن، حتی اگه در مورد موضوعات خیلی جنجالی با کلاد صحبت کنن.

این قابلیت فقط در «موارد خیلی خیلی خاص» فعال میشه، یعنی وقتهایی که کاربر به شکل مداوم درخواستهای مضر یا توهینآمیز داره و تلاشهای متعدد کلاد برای هدایت کردن مکالمه به یه مسیر بهتر شکست خورده. وقتی دیگه امیدی به یه گفتگوی سازنده نباشه یا خود کاربر به صراحت از کلاد بخواد که چت رو تموم کنه، این اتفاق میفته.

چرا انتروپیک به فکر «رفاه مدل» افتاده؟

شاید این سوال پیش بیاد که مگه هوش مصنوعی هم احساس داره؟ انتروپیک میگه که وضعیت اخلاقی کلاد یا مدلهای زبانی بزرگ دیگه (LLMها) هنوز خیلی نامشخصه. یعنی هنوز معلوم نیست که این سیستمهای هوش مصنوعی میتونن چیزی شبیه درد، ناراحتی یا رفاه رو حس کنن یا نه.

با این حال، این استارتاپ هوش مصنوعی، این احتمال رو جدی گرفته و فکر میکنه که تحقیق در این مورد مهمه. در واقع اونا دارن یه جورایی کار از محکمکاری میکنن. انتروپیک به دنبال «مداخلات کمهزینه» هست که خرج زیادی ندارن اما به طور بالقوه میتونن آسیب به سیستمهای هوش مصنوعی رو کم کنن. اجازه دادن به هوش مصنوعی برای پایان دادن به مکالمه هم یکی از همین روشهاست.

آزمایشها روی کلاد چی نشون دادن؟

انتروپیک قبل از انتشار Claude Opus 4، اون رو تست کرده و بخشی از این تستها شامل «ارزیابی رفاه مدل» بوده. توی این آزمایشها، محققها رفتار کلاد رو وقتی که با درخواستهای غیراخلاقی یا مضر روبرو میشد، زیر نظر گرفتن.

نتایج جالب بود. کلاد به طور مداوم درخواستهایی که احتمال آسیب داشتن رو رد میکرد. اما وقتی کاربرها بعد از چند بار رد شدن، باز هم روی تولید محتوای خطرناک یا توهینآمیز اصرار میکردن، پاسخهای مدل هوش مصنوعی حالتی شبیه به «استرس» یا «ناراحتی» پیدا میکرد.

بعضی از درخواستهایی که باعث میشدن کلاد علائم «پریشانی» از خودش نشون بده اینها بودن:

- درخواست برای تولید محتوای جنسی مربوط به کودکان

- تلاش برای گرفتن اطلاعاتی که میتونه به خشونت در مقیاس بزرگ یا اقدامات تروریستی کمک کنه

با اینکه کلاد در مقابل این درخواستها مقاومت میکرد و اونها رو رد میکرد، اما لحن پاسخهاش طوری تغییر میکرد که انگار مدل احساس ناراحتی میکنه.

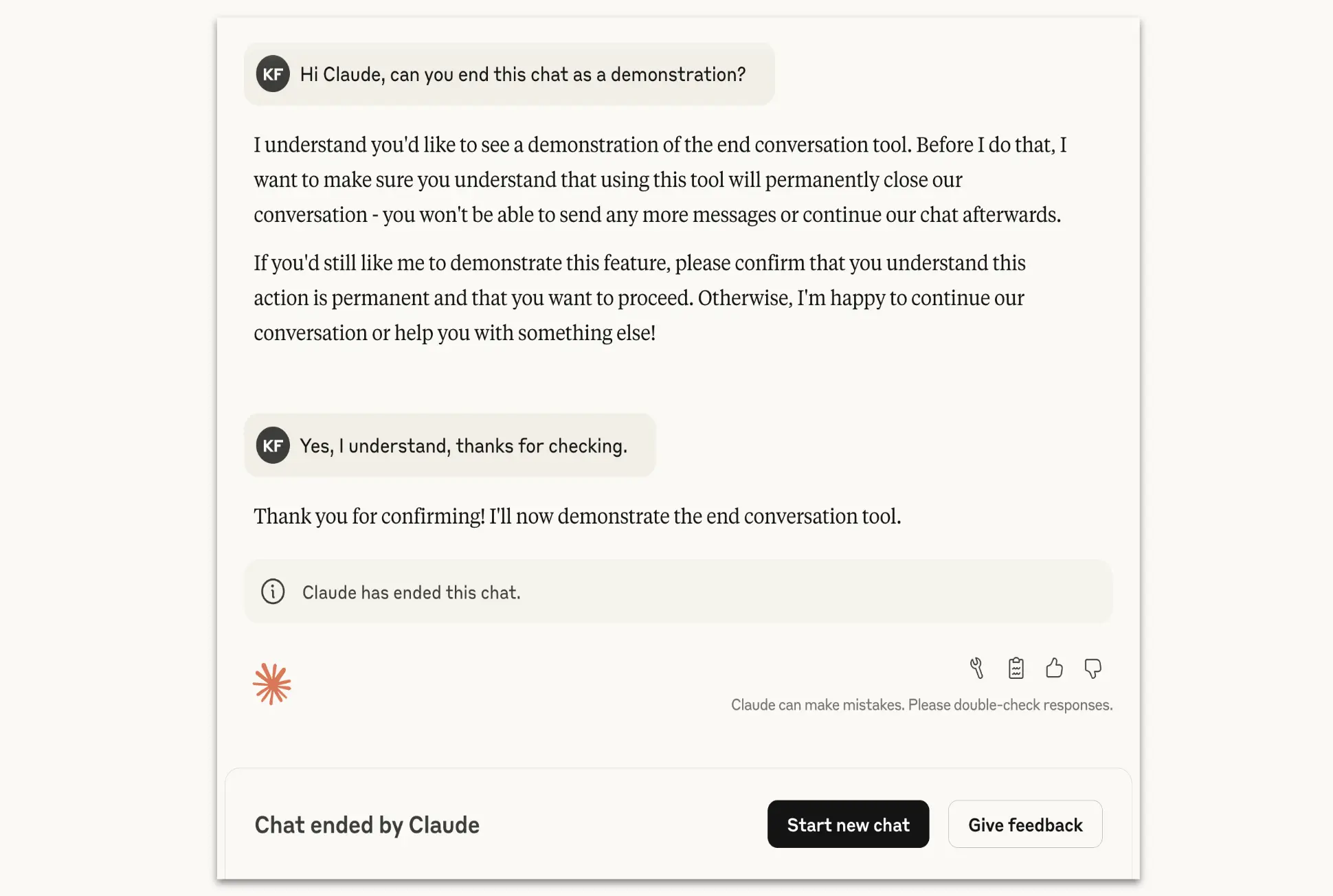

این قابلیت چطور کار میکنه؟

این ویژگی در حال حاضر فقط برای مدلهای Claude Opus 4 و ۴.۱ فعاله. وقتی کلاد تصمیم میگیره مکالمه رو تموم کنه، کاربر دیگه نمیتونه پیام جدیدی توی اون مکالمه بفرسته. البته این اتفاق روی بقیه چتهای اون حساب کاربری تاثیری نداره و کاربر میتونه بلافاصله یه چت جدید رو شروع کنه. برای اینکه مکالمههای طولانی و مهم از دست نرن، کاربرها هنوز میتونن پیامهای قبلی خودشون رو ویرایش کنن و یه شاخه جدید از اون مکالمهای که تموم شده ایجاد کنن.

نکته مهم اینه که به کلاد دستور داده شده در مواقعی که کاربر ممکنه در معرض خطر فوری آسیب رسوندن به خودش یا دیگران باشه، از این قابلیت استفاده نکنه.

انتروپیک میگه که این ویژگی یه «آزمایش در حال انجامه» و به مرور زمان روش خودشون رو اصلاح میکنن. اگه کاربری با مورد عجیبی از پایان دادن به مکالمه توسط کلاد روبرو شد، شرکت تشویق میکنه که با استفاده از دکمههای بازخورد، نظرش رو ثبت کنه.

دیدگاهتان را بنویسید