شرکت Arcee.ai که در زمینه توسعه مدلهای هوش مصنوعی کوچک برای استفادههای تجاری و سازمانی فعالیت میکند، مدل جدید خودش به اسم AFM-4.5B رو برای استفاده رایگان و محدود شرکتهای کوچک عرضه کرده. این شرکت وزنهای مدل رو در پلتفرم Hugging Face قرار داده و به شرکتهایی که درامد سالانه کمتر از ۱.۷۵ میلیون دلار دارن، اجازه میده تحت یک لایسنس سفارشی به اسم «لایسنس مدل ارسی» یا Arcee Model License از اون به صورت رایگان استفاده کنن.

این مدل با داشتن ۴.۵ میلیارد پارامتر، برای استفادههای واقعی در محیطهای سازمانی طراحی شده. اندازهاش خیلی کوچکتر از مدلهای پیشرفته و بزرگه که دهها میلیارد تا تریلیونها پارامتر دارن. این اندازه کوچکتر باعث میشه هم از نظر هزینه به صرفه باشه، هم با قوانین و مقررات سازگار باشه و هم عملکرد خوبی در یک پکیج جمعوجور داشته باشه.

مدل AFM-4.5B بخشی از دو محصولی بود که شرکت ارسی ماه گذشته منتشر کرد. این مدل از نوع «instruction tuned» یا «instruct» هست، یعنی برای کارهایی مثل چت، جستجو و نوشتن خلاقانه اموزش دیده و سازمانها میتونن فورا از اون برای این موارد استفاده کنن. یک مدل پایه دیگه هم همزمان با این مدل منتشر شد که فقط مرحله پیشاموزش رو گذرونده بود و هنوز برای دستورالعملها بهینه نشده بود تا مشتریان بتونن سفارشیسازی بیشتری روش انجام بدن. تا قبل از این، هر دو مدل فقط با شرایط لایسنس تجاری در دسترس بودن.

چرا این مدل ساخته شد؟ تمرکز روی نیازهای مشتریان سازمانی

مدل AFM-4.5B پاسخ شرکت Arcee.ai به چالشهای اصلی سازمانها در استفاده از هوش مصنوعی مولد هست: هزینه بالا، محدودیت در سفارشیسازی و نگرانیهای قانونی در مورد مدلهای زبان بزرگ اختصاصی (LLM).

تیم ارسی در طول یک سال گذشته با بیشتر از ۱۵۰ سازمان، از استارتاپها گرفته تا شرکتهای حاضر در لیست Fortune 100، صحبت کرد تا محدودیتهای مدلهای موجود رو بشناسه و اهداف مدل خودش رو مشخص کنه.

طبق گفته این شرکت، خیلی از کسبوکارها معتقد بودن مدلهای رایج مثل مدلهای شرکتهای OpenAI، Anthropic یا DeepSeek خیلی گرون هستن و به سختی میشه اونها رو برای نیازهای خاص یک صنعت سفارشی کرد. از طرفی، مدلهای کوچکتر با وزن باز مثل Llama، Mistral و Qwen انعطافپذیری بیشتری داشتن، اما نگرانیهایی در مورد لایسنس، منشا مالکیت معنوی (IP) و ریسکهای ژئوپلیتیکی به همراه داشتن.

AFM-4.5B به عنوان یک جایگزین «بدون مصالحه» توسعه پیدا کرد: قابل سفارشیسازی، سازگار با قوانین و مقررات، و از نظر هزینه بهینه، بدون اینکه کیفیت یا کارایی مدل فدا بشه.

دسترسی و نحوه استفاده از مدل

برای دسترسی به این مدل در پلتفرم Hugging Face، شما باید موافقت کنید که اطلاعات تماستون رو به اشتراک بذارید. این مخزن به صورت عمومی در دسترسه، اما برای دسترسی به فایلها و محتوای اون باید شرایط رو بپذیرید. وارد کردن اسم شرکت اختیاریه و اگه نمیخواید اون رو به اشتراک بذارید، میتونید به جاش NA وارد کنید. برای بررسی شرایط و دسترسی به محتوای مدل، باید وارد حساب کاربری خودتون بشید یا ثبتنام کنید.

این مدل از طریق کتابخانه transformers قابل استفاده است. برای عملکرد بهتر، توصیه میشه از دمای (temperature) پایین، حدود ۰.۵، استفاده کنید.

تنظیمات پیشنهادی:

- temperature: 0.۵

- top_k: 50

- top_p: 0.۹۵

- repeat_penalty: 1.۱

در ادامه چند نمونه کد برای استفاده از این مدل ارائه شده.

استفاده با کتابخانه transformers:

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

model_id = "arcee-ai/AFM-4.5B"

tokenizer = AutoTokenizer.from_pretrained(model_id)

model = AutoModelForCausalLM.from_pretrained(

model_id,

torch_dtype=torch.bfloat16,

device_map="auto"

)

messages = [

{"role": "user", "content": "Who are you?"},

]

input_ids = tokenizer.apply_chat_template(

messages,

add_generation_prompt=True,

return_tensors="pt"

).to(model.device)

outputs = model.generate(

input_ids,

max_new_tokens=256,

do_sample=True,

temperature=0.5,

top_k=50,

top_p=0.95

)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(response)استفاده از طریق Together Playground:

این مدل مستقیما از طریق Together Playground هم در دسترسه.

from together import Together

client = Together()

response = client.chat.completions.create(

model="arcee-ai/AFM-4.5B",

messages=[

{

"role": "user",

"content": "What are some fun things to do in New York?"

}

]

)

print(response.choices[0].message.content)استفاده با cURL:

curl -X POST "https://api.together.xyz/v1/chat/completions" \

-H "Authorization: Bearer $TOGETHER_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "arcee-ai/AFM-4.5B",

"messages": [

{

"role": "user",

"content": "What are some fun things to do in New York?"

}

]

}'پشتیبانی از llama.cpp هم موجوده و فایلهای کوانتایز شده در فرمت GGUF در این لینک ارائه شده. همچنین پشتیبانی از vLLM در انتظار تایید یک درخواست pull در گیتهاب با شماره ۲۱۷۲۵ هست.

جزئیات فنی: معماری و فرایند اموزش AFM-4.5B

مدل AFM-4.5B یک مدل ۴.۵ میلیارد پارامتریه که توسط Arcee.ai برای عملکرد در سطح سازمانی در محیطهای مختلف، از کلاد گرفته تا دستگاههای لبه (edge)، توسعه داده شده.

معماری مدل:

- نوع معماری: ArceeForCausalLM

- تعداد پارامترها: ۴.۵ میلیارد

- این مدل از یک معماری استاندارد ترنسفورمر فقط-دیکدر (decoder-only) بر اساس مقاله Vaswani و همکارانش استفاده میکنه، اما چند تغییر کلیدی برای بهبود عملکرد و کارایی در اون اعمال شده. ویژگیهای معماری قابل توجه شامل موارد زیره:

- Grouped Query Attention (GQA): برای بهبود کارایی در زمان استنتاج (inference).

- توابع فعالسازی ReLU^2: به جای SwiGLU استفاده شده تا امکان разреженность (sparsification) فراهم بشه و در عین حال عملکرد حفظ یا حتی بهتر بشه.

فرایند اموزش:

مدل پایه روی یک مجموعه داده شامل ۸ تریلیون توکن اموزش دیده. این فرایند در دو مرحله انجام شده:

- پیشاموزش عمومی: با ۶.۵ تریلیون توکن داده عمومی.

- اموزش میانی: با ۱.۵ تریلیون توکن داده با تمرکز ویژه روی استدلال ریاضی و تولید کد.

بعد از پیشاموزش، مدل وارد فاز تنظیم دقیق نظارت شده (supervised fine-tuning) روی مجموعهدادههای دستوری با کیفیت بالا شد. در نهایت، مدل از طریق یادگیری تقویتی (reinforcement learning) با استفاده از پاداشهای قابل تایید و همچنین بر اساس ترجیحات انسانی، اصلاح شد. برای این مراحل، از ابزارهای زیر استفاده شده:

- یک نسخه اصلاح شده از TorchTitan برای پیشاموزش.

- Axolotl برای تنظیم دقیق نظارت شده.

- یک نسخه اصلاح شده از Verifiers برای یادگیری تقویتی.

مدلی که در مخزن Hugging Face موجوده، مدل instruct هست که مراحل تنظیم دقیق نظارت شده و یادگیری تقویتی رو پشت سر گذاشته. برای جزئیات بیشتر، به مستندات ارسی در این لینک میشه مراجعه کرد.

تاکید بر کیفیت دادهها و همکاری با DatologyAI

در فرایند توسعه AFM-4.5B، کیفیت داده به عنوان یک نیاز اساسی برای رسیدن به عملکرد قوی مدل در اولویت قرار گرفت. ارسی در این زمینه با شرکت DatologyAI که در زمینه مدیریت و پالایش داده در مقیاس بزرگ تخصص داره، همکاری کرد.

پایپلاین پالایش داده DatologyAI مجموعهای از الگوریتمهای اختصاصی رو شامل میشه:

- فیلتر کردن کیفیت مبتنی بر مدل

- پالایش مبتنی بر embedding

- تطبیق با توزیع هدف

- ترکیب منابع

- دادههای مصنوعی

تخصص این شرکت به ایجاد یک مجموعه داده پالایش شده کمک کرد که برای پشتیبانی از عملکرد قوی در دنیای واقعی طراحی شده. تلاش زیادی هم برای حذف کتابهای دارای حق چاپ و مطالبی با لایسنس نامشخص انجام شد تا ریسکهای مربوط به مالکیت معنوی به حداقل برسه.

عملکرد و نتایج بنچمارکها

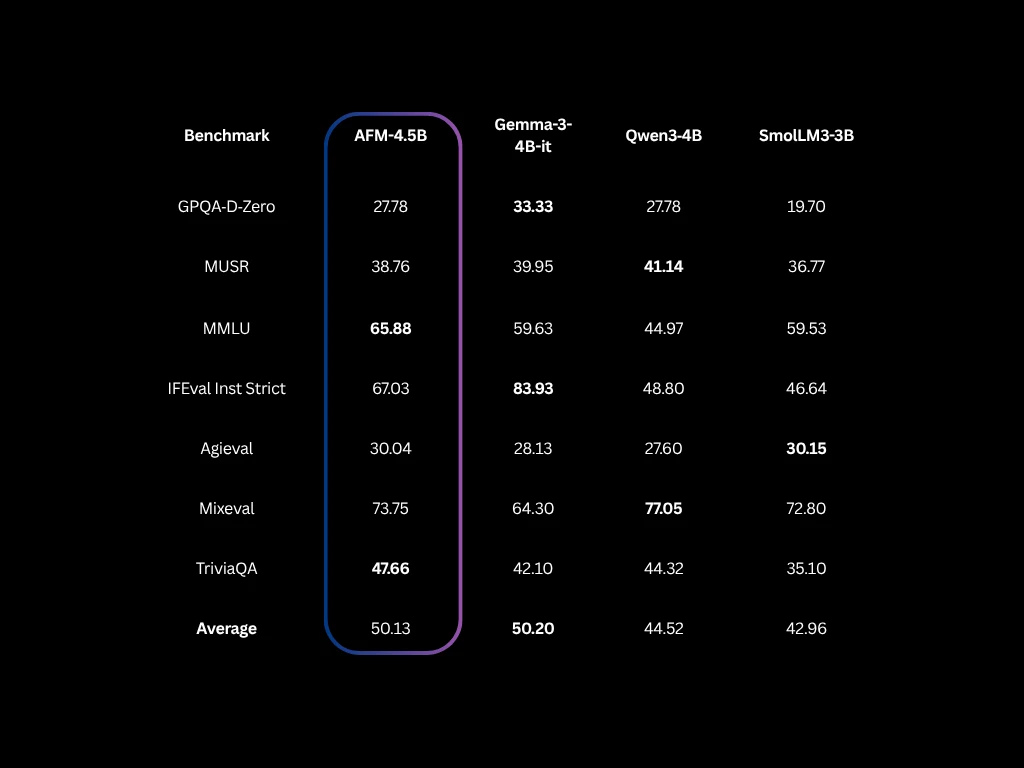

با وجود اندازه کوچکتر، AFM-4.5B در طیف گستردهای از بنچمارکها عملکرد رقابتی داره. نسخه instruction-tuned این مدل به طور میانگین امتیاز ۵۰.۱۳ رو در مجموعههای ارزیابی مثل MMLU، MixEval، TriviaQA و Agieval کسب کرده. این امتیاز با مدلهای هماندازه خودش مثل Gemma-3 4B-it، Qwen3-4B و SmolLM3-3B برابری میکنه یا از اونها بهتره.

یک نکته مهم در مورد مقایسه این مدلها اینه که رویکرد استدلال مدلهای Qwen3 و SmolLM باعث میشه امتیازاتشون در مجموعههای مختلف به شدت متغیر باشه. اما تمام امتیازات ذکر شده در بالا، بر اساس ابزار ارزیابی داخلی ارسی و با هایپرپارامترهای یکسان به دست اومده. البته برای مقایسه دقیقتر، باید به امتیازات گزارش شده توسط خود این مدلها هم مراجعه کرد.

این مدل در محیطهای ارزیابی عمومی هم تونسته توجهات رو به خودش جلب کنه. در یک لیدربورد که کیفیت مدلهای مکالمهمحور رو بر اساس رای کاربران و درصد پیروزی رتبهبندی میکنه، این مدل در رتبه سوم کل قرار گرفته و فقط از مدلهای Claude Opus 4 و Gemini 2.5 Pro پایینتره.

- نرخ پیروزی (Win Rate): ۵۹.۲ درصد

- تاخیر (Latency): ۰.۲ ثانیه (سریعترین در بین مدلهای برتر)

- سرعت تولید (Generation Speed): ۱۷۹ توکن در ثانیه

آزمایشهای چندزبانه هم نشون داده که این مدل در بیش از ۱۰ زبان، از جمله عربی، ماندارین، آلمانی و پرتغالی، عملکرد قوی داره. به گفته ارسی، به خاطر معماری ماژولار این مدل، اضافه کردن پشتیبانی از گویشهای جدید کار سادهای هست.

ویژگیهای داخلی و چشمانداز شرکت

AFM-4.5B علاوه بر قابلیتهای عمومی، از function calling و استدلال عاملگونه (agentic reasoning) هم به صورت داخلی پشتیبانی میکنه. هدف از این ویژگیها، سادهسازی فرایند ساخت ایجنتهای هوش مصنوعی و ابزارهای اتوماسیون گردش کار و کاهش نیاز به مهندسی پرامپت پیچیده یا لایههای هماهنگسازیه.

این قابلیت با استراتژی کلی ارسی برای توانمندسازی سازمانها در ساخت مدلهای سفارشی و اماده برای تولید، هماهنگه؛ مدلهایی که هزینه کل مالکیت (TCO) کمتری دارن و راحتتر در عملیات تجاری ادغام میشن.

چشمانداز و استراتژی شرکت ارسی تونسته حمایت سرمایهگذاران رو هم جلب کنه و این شرکت در سال ۲۰۲۴ موفق به جذب ۲۴ میلیون دلار سرمایه در دور سری A شد. مارک مککوید، مدیرعامل ارسی، در مصاحبهای با ونچربیت گفته بود: «شما برای موارد استفاده تجاری نیازی به مدلهای خیلی بزرگ ندارید». این شرکت بر تکرار سریع و سفارشیسازی مدل به عنوان بخش اصلی خدماتش تاکید داره.

شرایط استفاده و لایسنس مدل

مدل AFM-4.5B تحت لایسنس مدل ارسی (Arcee Model License یا AML) منتشر شده. شرایط این لایسنس به این صورته:

- اگه شرکت شما کمتر از ۱.۷۵ میلیون دلار درامد سالانه داره، میتونید آزادانه از این مدل برای اهداف تجاری استفاده کنید.

- شرط استفاده اینه که شما وزنهای مدل رو در اختیار شرکتی که درامدش بالاتر از این آستانه هست، قرار ندید.

- اگه محصول یا اپلیکیشن شما که از AFM-4.5B استفاده میکنه به یک شرکت بزرگتر فروخته بشه، مشکلی نداره، تا زمانی که اون شرکت بزرگتر به طور مستقیم وزنهای مدل رو دریافت یا اجرا نکنه.

ارسی اعلام کرده که هدفش اینه که بیشترین تعداد ممکن از توسعهدهندگان، محققان و سازندگان از AFM-4.5B بهرهمند بشن. در عین حال، این لایسنس تضمین میکنه که این شرکت بتونه به توسعه و پشتیبانی از مدل برای جامعه ادامه بده. در ماه گذشته، این مدل ۸۶۸ بار دانلود شده.

برنامههای آینده ارسی

لوکاس اتکینز، مدیر ارشد فناوری (CTO) ارسی، در پستی در شبکه اجتماعی X اشاره کرده که «مدلهای اختصاصی بیشتری برای استدلال و استفاده از ابزار در راه هستن». او در پستی دیگر نوشت: «ساخت AFM-4.5B یک تلاش تیمی بزرگ بود و ما از همه کسانی که از ما حمایت کردن عمیقا سپاسگزاریم. بیصبرانه منتظریم ببینیم شما با اون چه چیزی میسازید. ما تازه شروع کردهایم. اگه بازخورد یا ایدهای دارید، لطفا در هر زمانی با ما تماس بگیرید».

مدل AFM-4.5B نشاندهنده تلاش Arcee.ai برای تعریف یک دسته جدید از مدلهای زبانی اماده برای سازمانهاست: کوچک، با عملکرد بالا و کاملا قابل سفارشیسازی، بدون مصالحههایی که اغلب با مدلهای بزرگ اختصاصی یا مدلهای کوچک با وزن باز همراهه.

اینکه آیا ارسی میتونه یک نقش پایدار در چشمانداز به سرعت در حال تغییر هوش مصنوعی مولد برای خودش ایجاد کنه، به توانایی این شرکت در عمل به این وعدهها بستگی داره. اما با AFM-4.5B، این شرکت اولین حرکت مطمئن خودش رو انجام داده.

دیدگاهتان را بنویسید