اخیرا المپیاد جهانی ریاضی سال ۲۰۲۵ برگزار شد، رویدادی که به عنوان یکی از سختترین آزمونهای ریاضی دبیرستان در جهان شناخته میشه. هر سال در ماه ژوییه، باهوشترین دانشآموزان نوجوان از سراسر دنیا دور هم جمع میشن تا در این رقابت که دو روز طول میکشه و شامل نوشتن اثباتهای پیچیده است، شرکت کنن. اما در سال ۲۰۲۵، برای اولین بار، شش سوال این آزمون به صورت مجازی در اختیار دستهای جدید از شرکتکنندهها هم قرار گرفت: مدلهای زبان بزرگ یا همون الالامها. این اتفاق فرصتی بود تا ببینیم این مدلهای هوش مصنوعی در برابر مسائل ریاضی که به خلاقیت و استدلال عمیق نیاز دارن، چطور عمل میکنن.

در این مقاله، قراره به طور کامل و با جزییات به بررسی نتایج این آزمایش بپردازیم. ما به سراغ گزارشها و تحلیلهای مختلفی که در این زمینه منتشر شده رفتیم تا ببینیم این مدلها چطور ارزیابی شدن، چه نتایجی گرفتن و چه نکات جالبی از عملکردشون به دست اومده. از روششناسی دقیق این آزمون گرفته تا هزینههای انجامش و واکنشهای جامعه مجازی، همه رو پوشش میدیم.

نتایج انسانی به عنوان خط معیار: المپیاد ۲۰۲۵ برای انسانها

قبل از اینکه وارد دنیای هوش مصنوعی بشیم، خوبه که نگاهی به نتایج انسانی در همین المپیاد بندازیم تا یک معیاری برای مقایسه داشته باشیم. طبق گزارشها، در المپیاد ۲۰۲۵، تیم چین دوباره به مقام اول برگشت و با سه نمره کامل، مجموع امتیاز تیمی ۲۳۱ رو به دست آورد. حداکثر امتیاز ممکن ۲۵۲ بود. بعد از چین، تیم آمریکا با ۲۱۶ امتیاز در رده دوم و کره جنوبی با ۲۰۳ امتیاز در جایگاه سوم قرار گرفت.

یک نکته جالب در مورد آزمون امسال این بود که تعداد شرکتکنندههایی که تونستن مسائل ۱ تا ۵ رو به طور کامل حل کنن، به شکل غیرعادی زیاد بود. این موضوع در کنار این حقیقت که همه اعضای تیم چین این پنج مسئله رو بدون نقص جواب دادن، نشون میده که سطح سوالات یا آمادگی شرکتکنندهها در این بخش بالا بوده. به همین دلیل، حد نصاب نمره برای گرفتن مدال طلا به ۳۵ امتیاز رسید که گفته میشه بالاترین حد نصاب در تاریخ این مسابقات باشه. در مجموع ۶۷ مدال طلا در این دوره توزیع شد که این تعداد هم به خاطر کسب نمره مساوی ۳۵ توسط تعداد زیادی از دانشآموزان، بالا بود. در کنار مدالهای طلا، ۱۰۳ مدال نقره هم اهدا شد. این نتایج انسانی، چارچوبی رو برای درک بهتر عملکرد مدلهای هوش مصنوعی فراهم میکنه.

چرا المپیاد ریاضی یک آزمون استرس عالی برای مدلهای زبان است؟

شاید در نگاه اول، مسائل المپیاد ریاضی شبیه معماهای سرگرمکننده به نظر برسن، اما در واقعیت، اونها پروژههای تحقیقاتی کوچکی هستن. یک اشتباه کوچیک، مثل فراموش کردن یک حالت خاص یا یک نابرابری بدون توجیه، میتونه کل نمره سوال رو صفر کنه. در این آزمون، راهحلها بر اساس «دقت و استحکام منطقی» قضاوت میشن، نه صرفا قابل قبول بودن. همچنین، راهنماییهای متنی خیلی کمه و بیشتر با نمودارها و نمادهای رسمی سروکار داریم.

برای یک مدل زبان بزرگ که بیشتر روی متون اینترنتی آموزش دیده، این یک محیط کاملا چالشبرانگیز و حتی خصمانه محسوب میشه. اگه مدلی بتونه در چنین محیطی موفق عمل کنه، شانس موفقیتش در هر زمینهای که به منطق بینقص نیاز داره، مثل تایید نرمافزار، تنظیم بندهای حقوقی یا بررسی پروتکلهای پزشکی، بیشتر میشه.

روششناسی ارزیابی: مدلهای هوش مصنوعی چطور تست شدن؟

چندین گروه و پلتفرم به صورت مستقل عملکرد مدلهای هوش مصنوعی رو در المپیاد ۲۰۲۵ بررسی کردن. یکی از اصلیترین این تلاشها توسط پلتفرم «مثارینا» (MathArena) انجام شد. هدف اونها ایجاد بنچمارکهای سخت و جدید برای سنجش تواناییهای ریاضی مدلهای زبان بزرگ بود. همچنین یک مخزن متنباز به نام «IMO2025-LLM» هم ایجاد شد تا همه جزییات این آزمایش، از سوالات اصلی گرفته تا پاسخهای مدلها و گزارش بیطرفانه در مورد درستی و کامل بودن جوابها، در دسترس عموم قرار بگیره.

چیدمان و داوری

در ارزیابی مثارینا، از روشی شبیه به ارزیابی المپیاد ریاضی آمریکا (USAMO) در سال ۲۰۲۵ استفاده شد. چهار داور انسانی باتجربه که همگی تخصص ریاضی در سطح المپیاد جهانی داشتن، برای ارزیابی پاسخها استخدام شدن. فرآیند ارزیابی بلافاصله بعد از انتشار سوالات المپیاد ۲۰۲۵ شروع شد تا از هرگونه آلودگی دادهای جلوگیری بشه. داورها سوالات رو بررسی کردن و برای هر سوال که ۷ امتیاز داشت، یک طرح نمرهدهی تهیه کردن. برای اطمینان از عدالت، هر پاسخ به صورت ناشناس و توسط دو داور به طور مستقل نمرهدهی شد. این کار از طریق همان رابطی انجام شد که برای پروژه «اوپن پروف کورپس» (Open Proof Corpus) توسعه داده شده بود. گزارش دیگری هم اشاره میکنه که صحت پاسخها توسط حداقل دو مدالآور سابق المپیاد جهانی ریاضی بررسی شده و در صورت اختلاف نظر، یک داور سوم نظر نهایی رو میداده.

مدلهای شرکتکننده

در این ارزیابیها، چندین مدل پیشرفته مورد آزمایش قرار گرفتن. مثارینا پنج مدل رو بر اساس عملکرد قبلیشون در مسابقات خودش انتخاب کرد: o3، o4-mini، Gemini-2.5-Pro، Grok-4 و Deepseek-R1 (نسخه ۰۵/۲۸). گزارشهای دیگر به مدلهای دیگری مثل ByteDance Seed 1.6 هم اشاره کردن. هر مدل با هایپرپارامترهای توصیهشده و با محدودیت حداکثر ۶۴ هزار توکن اجرا شد، هرچند هیچکدوم از مدلها به این تعداد توکن نیاز پیدا نکردن.

استراتژی انتخاب بهترین پاسخ از بین چند پاسخ (Best-of-n)

یک نقد کلیدی به ارزیابیهای قبلی این بود که نباید از مدلها انتظار داشت مسائل فوقالعاده سخت رو در یک تلاش جواب بدن. این نقد در مورد مسائل به مراتب سختتر المپیاد جهانی ریاضی اهمیت بیشتری پیدا میکنه. برای حل این محدودیت، از یک استراتژی انتخاب بهترین پاسخ از بین ۳۲ پاسخ استفاده شد. این روش که بر اساس کارهای تحقیقاتی قبلی بود، در تولید اثباتهای ریاضی عملکرد خیلی خوبی از خودش نشون داده و تونسته بود عملکرد مدلها رو تقریبا دو برابر کنه.

روش کار به این صورت بود که برای هر مسئله، هر مدل ۳۲ پاسخ مختلف تولید میکرد. بعد، این پاسخها در یک تورنمنت حذفی با استفاده از یک سیستم «مدل زبان بزرگ به عنوان داور» ارزیابی میشدن. در این سیستم، خود مدل برای قضاوت بین پاسخهای خودش به کار گرفته میشد. مدل هر جفت پاسخ رو مقایسه و پاسخ قویتر رو انتخاب میکرد. این فرآیند اونقدر تکرار میشد تا در نهایت یک پاسخ به عنوان بهترین باقی بمونه و اون پاسخ برای ارزیابی نهایی به داوران انسانی ارائه میشد.

این فرآیند انتخاب از نظر محاسباتی و مالی بسیار سنگین بود. به طور متوسط، تولید هر پاسخ نهایی برای مدلها حداقل ۳ دلار هزینه داشت و این هزینه برای مدل Grok-4 به بیش از ۲۰ دلار برای هر پاسخ میرسید. بنابراین، عملکردی که اینجا گزارش شده، بهترین خروجی ممکن مدلها در یک بودجه منطقی به حساب میاد.

نتایج عملکرد: هوش مصنوعی در برابر غولهای ریاضی

نتایج به دست اومده از این ارزیابیها تصویر جالبی از وضعیت فعلی مدلهای هوش مصنوعی در حل مسائل ریاضی سطح بالا ارائه میده. البته باید توجه داشت که گزارشهای مختلف، اعداد و ارقام متفاوتی رو اعلام کردن که ما هر دو رو به صورت بیطرفانه بیان میکنیم.

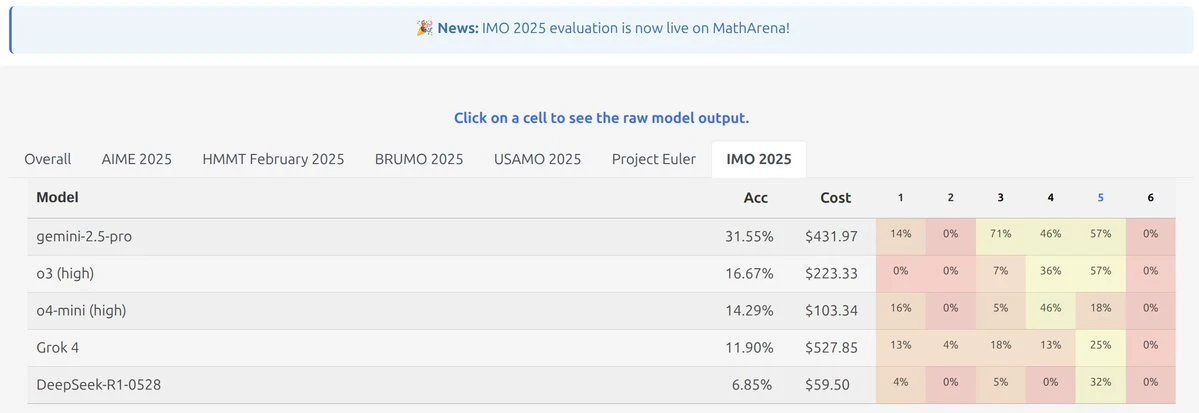

یافتههای پلتفرم مثارینا

بر اساس گزارش مثارینا که توسط افرادی مثل «دنی ژو» و «دیدی داس» در شبکههای اجتماعی به اشتراک گذاشته شد، بهترین عملکرد متعلق به مدل Gemini 2.5 Pro بود. این مدل تونست به امتیاز ۱۳ از ۴۲ برسه که معادل ۳۱.۵۵ درصد کل امتیازات میشه. هرچند این امتیاز با توجه به سختی شدید المپیاد جهانی ریاضی، یک عملکرد قوی به حساب میاد، اما برای کسب مدال برنز که نیاز به امتیاز ۱۹ از ۴۲ داشت، کافی نبود.

مدلهای دیگه با فاصله قابل توجهی عقبتر بودن. مدل o3 high با کسب ۱۶.۶۷ درصد در رتبه بعدی قرار گرفت و Grok 4 با ۱۱.۹۰ درصد سوم شد. به خصوص عملکرد Grok-4 و DeepSeek-R1 نسبت به نتایج قبلیشون در بنچمارکهای دیگر مثارینا، ضعیفتر بود. دیدی داس در پستی اشاره کرد که هزینه تولید پاسخهای مدل Gemini 2.5 Pro در این ارزیابی «بهترین از ۳۲»، به ۴۳۱.۹۷ دلار رسیده. او نتیجهگیری کرد که هوش مصنوعی هنوز راه درازی برای حل مسائل سخت ریاضی در پیش داره.

یافتههای مخزن IMO2025-LLM

در مقابل، گزارش دیگهای که بر اساس مخزن متنباز IMO2025-LLM منتشر شده، تصویر متفاوتی رو نشون میده. تیتر اصلی این گزارش اینه: «فقط دو مدل — ByteDance Seed 1.6 و Google Gemini 2.5 Pro — تونستن راهحلهای کاملا درست و کامل برای مسئله ۵ ارائه بدن». مسئله ۵ به عنوان سختترین مسئله آزمون شناخته میشد.

در بخش پرسش و پاسخ این گزارش، ادعای جالبی مطرح شده. در جواب به این سوال که آیا مدلی نمره کامل ۴۲ از ۴۲ گرفته، گفته شده «نه». اما در ادامه میگه: «بهترین امتیاز کل ۳۹ از ۴۲ بود که توسط Gemini 2.5 Pro به دست اومد. این مدل فقط یک امتیاز در مسئله ۳ به خاطر یک حالت خاص ناقص از دست داد». این امتیاز به شکل قابل توجهی با امتیاز ۱۳ از ۴۲ که توسط مثارینا گزارش شده، تفاوت داره.

یک ادعای دیگر: مدال طلا برای OpenAI

در میان بحثها و نظرات در لینکدین، یکی از کاربران به نام «سامبودا روی» به پستی از «نوام براون» از شرکت OpenAI اشاره کرد. طبق گفته او، به نظر میرسه یک مدل استدلال جدید از OpenAI تونسته در المپیاد امسال به سطح مدال طلا برسه. این ادعا به صورت رسمی تایید نشده و در حد یک اشاره در گفتگوها باقی مونده، اما نشون میده که رقابت در این زمینه بسیار داغه.

تحلیل کیفی: نگاهی عمیقتر به پاسخهای مدلها

فراتر از اعداد و امتیازات، بررسی خود پاسخها نکات جالبی رو در مورد رفتار و اشتباهات مدلهای هوش مصنوعی آشکار میکنه.

عملکرد ضعیف Grok-4

مدل Grok-4 به طور قابل توجهی پایینتر از انتظارات عمل کرد. خیلی از پاسخهای اولیهاش به شدت کوتاه بودن و اغلب فقط شامل جواب نهایی بدون هیچ توضیحی میشدن. هرچند فرآیند انتخاب بهترین پاسخ به فیلتر کردن جوابهای بهتر کمک کرد، اما اشاره شده که اکثریت قاطع پاسخهای این مدل (اونهایی که انتخاب نشدن) صرفا جواب نهایی رو بدون هیچ توجیه اضافهای بیان میکردن. این مشکل در بنچمارکهای دیگه مثارینا هم دیده شده بود، جایی که پاسخهای Grok-4 اغلب عمق یا توجیه کافی ندارن.

جمینی و استنادهای ساختگی

مدل Gemini-2.5-Pro همچنان تمایل نگرانکنندهای به استناد به قضیههایی که وجود خارجی ندارن، از خودش نشون میده، به خصوص وقتی که در پیدا کردن یک اثبات معتبر شکست میخوره. این رفتار به طور خاص نگرانکننده است، چون با ارائه یک منبع قدرت دروغین، کاربران رو گمراه میکنه و اعتماد به استدلال مدل رو از بین میبره. با این حال، ذکر شده که این رفتار در پاسخهای المپیاد جهانی ریاضی نسبت به ارزیابی المپیاد ریاضی آمریکا کمتر دیده شده که نشوندهنده مقداری پیشرفت در این زمینه است.

پاسخهای «محکمتر»

در مقایسه با ارزیابیهای قبلی، موارد کمتری از مشکلات فرمتبندی عجیب یا رفتارهایی که ناشی از بهینهسازی بیش از حد مدلها برای فرمتهای پاسخ نهایی بود، مشاهده شد. برای مثال، مدلها کمتر کل اثبات رو داخل کادر قرار میدادن یا فرض میکردن که جواب همیشه باید عددی باشه. این موضوع نشون میده که مدلها در مدیریت وظایف استدلال ریاضی باز و بدون ساختار مشخص، پیشرفت کردن.

امتیازات parcial یا جزئی

در مسابقاتی مثل المپیاد جهانی ریاضی، نسبتا نادره که شرکتکنندههای انسانی نمره متوسطی مثل ۳ یا ۴ از ۷ در یک سوال بگیرن. در مقابل، مدلهای زبان بزرگ اغلب از داورها امتیازات جزئی میگرفتن، به خصوص در مسائل ۴ و ۵. برای مسئله ۴، دلیلش این بود که بیشتر مدلها یک رویکرد کلی شبیه به انسانها رو در پیش میگرفتن اما دچار لغزشهای منطقی میشدن که به طور قابل توجهی امتیاز اونها رو کم میکرد. برای مسئله ۵، مدلها اغلب استراتژیهای درست رو تشخیص میدادن اما در اثبات اونها شکست میخوردن؛ قسمتی که به طرز کنایهآمیزی برای یک شرکتکننده انسانی در المپیاد، بخش آسانتر ماجراست. این تضاد، تفاوتهای کلیدی بین عملکرد انسان و مدل رو برجسته میکنه و نشون میده که اگه این مشکلات منطقی نسبتا جزئی برطرف بشن، مدلها میتونن در آینده نزدیک به طور قابل توجهی پیشرفت کنن.

اهمیت فرآیند انتخاب بهترین پاسخ

یکی از داورها به طور خلاصه نگاهی به بخشی از ۳۲ پاسخ خام تولید شده توسط مدلها قبل از فرآیند انتخاب بهترین پاسخ انداخت. او مشاهده کرد که بسیاری از این پاسخها خیلی ضعیف بودن و تخمین زد که بدون فیلتر کردن، امتیاز مدلها احتمالا به زیر ۱۰ درصد میرسید. نکته جالب اینجا بود که به گفته این داور، برخی از پاسخهایی که انتخاب نشده بودن، در ظاهر منسجمتر از پاسخهای انتخاب شده به نظر میرسیدن، اما در واقعیت خطاهای محتوایی بیشتری داشتن. این نشون میده که مدلها به طرز شگفتانگیزی در تشخیص کیفیت نسبی خروجیهای خودشون در طول فرآیند انتخاب بهترین پاسخ، موثر هستن و میتونن فراتر از انسجام ظاهری، به بررسی صحت و درستی بپردازن.

چالش مسئله ۵ و رمز موفقیت

گزارش مخزن IMO2025-LLM یک تحلیل عمیق روی مسئله ۵، که سختترین سوال آزمون بود، ارائه میده. این مسئله که «بازی نابرابری» نام داشت، در مورد دو بازیکن بود که به نوبت اعداد حقیقی مثبت رو روی تخته سیاه مینویسن و باید دو محدودیت کلی رو رعایت کنن: یک حد بالا برای مجموع اعداد و یک حد پایین برای حاصلضرب اونها. هدف این بود که اثبات بشه بازی باید بعد از تعداد محدودی حرکت تموم بشه.

تله این مسئله در این بود که نابرابریهای واضح بعد از سه یا چهار حرکت به شدت پیچیده میشدن و کوچکترین اشتباه در تخمین باعث میشد حاصلضرب به سمت بینهایت بره. مدلهای ByteDance Seed 1.6 و Gemini 2.5 Pro با دنبال کردن یک دستورالعمل منظم موفق شدن:

- ساختن یک مثال حدی برای نشون دادن اینکه کران مورد نظر، تنگ است.

- استفاده از استقرا بر روی تعداد حرکات و تقسیمبندی به موارد مختلف فقط در جایی که لازم بود.

- توضیح هر نابرابری به زبان محاورهای قبل از نوشتن خط رسمی ریاضی.

مدلهای دیگه یا این بررسی حدی رو انجام ندادن یا به یک نابرابری کلی تکیه کردن که در بررسی دقیقتر، شکست میخورد.

نگاهی به دستورالعملها و پارامترها

برای رسیدن به این نتایج، به مدلها دستورالعملهای بسیار دقیقی داده شد. این دستورالعملها که «پرامپت» نامیده میشن، به مدل میگن که دقیقا چه کاری باید انجام بده.

پرامپت تولید راهحل: به مدل گفته شده بود: «وظیفه شما نوشتن یک راهحل اثباتی برای مسئله زیر است. اثبات شما توسط داوران انسانی برای صحت، کامل بودن و وضوح نمرهدهی خواهد شد. هنگام نوشتن اثبات، این دستورالعملها را دنبال کنید: شما در حال ایجاد یک اثبات هستید، نه یک طرح کلی از اثبات. هر مرحله باید با دقت توضیح داده و مستند شود. میتوانید از قضایا و لمهای کلی استفاده کنید، اما فقط اگر به خوبی شناخته شده باشند. هرگونه استفاده از نتایج مقالاتی که در دبیرستان یا دورههای کارشناسی سطح پایین ریاضی تدریس نمیشود، نمره شما را فورا صفر میکند. مراحل محاسباتی را در اثبات خود حذف نکنید. از نمادگذاری صحیح LaTeX استفاده کنید. اثبات شما باید مستقل و کامل باشد. اگر در مورد یک مرحله خاص مطمئن نیستید یا نمیدانید چگونه یک نتیجه میانی را اثبات کنید، این را به وضوح بیان کنید».

پارامترهای فنی: علاوه بر پرامپت، تنظیمات فنی مدلها هم اهمیت داشت. به عنوان مثال، پارامتر «temperature» که میزان خلاقیت یا تصادفی بودن پاسخ رو کنترل میکنه، برای بیشتر مدلها روی صفر تنظیم شده بود. این یعنی مدل همیشه محتملترین کلمه بعدی رو انتخاب میکنه و پاسخها با یک پرامپت یکسان، همیشه یکسان خواهند بود. برای مدل DeepSeek R1، این پارامتر روی ۰.۶ تنظیم شده بود تا کمی خلاقیت داشته باشه.

واکنشها و بحثهای پیرامون نتایج

انتشار این نتایج باعث ایجاد بحثهای زیادی در شبکههای اجتماعی مثل ایکس (توییتر سابق) و لینکدین شد.

«دنی ژو» از گوگل نتایج اولیه مثارینا رو منتشر کرد که نشاندهنده برتری Gemini 2.5 Pro بود. کاربرانی مثل «تیانه یو» و «لیسان الغیب» در پاسخ به این پست، مدل جمینی رو تحسین کردن. «امدی فضل مصطفی» هم با اشاره به امتیاز جمینی، نوشت که مدلهای گوگل در حال درخشش هستن.

در لینکدین، پست «دیدی داس» که نتایج رو خلاصه کرده بود، نظرات جالبی رو به همراه داشت. «شریآس وایدیا» اشاره کرد که جمینی در آزمون پیشرفته JEE هند عملکردی نزدیک به رتبه یک داشته و این نشون میده که آزمون JEE به سمت تطبیق الگو رفته، در حالی که مسائل المپیاد هنوز به تفکر اصیل نیاز دارن. «یوراج ساردا» که خودش در المپیاد ریاضی مدال گرفته، معتقد بود که کسب امتیازات جزئی چندان معنادار نیست. او گفت اگه مدلها حتی یک مسئله رو به طور کامل حل میکردن، قابل توجه بود. به گفته او، مدلها به همه قضایا و ترفندها دسترسی دارن و فشار زمانی و استرس شرکتکنندههای واقعی رو تجربه نمیکنن.

بحث جانبی: کدام مدل هوش مصنوعی ارزش خرید اشتراک را دارد؟

در میان این بحثهای تخصصی، یک سوال کلیتر هم در لینکدین توسط «برایان ژولیوس» مطرح شد: «اگر قرار باشد اشتراک پولی یکی از مدلهای اصلی هوش مصنوعی را بخرید، کدام یک را انتخاب میکنید و چرا؟». او معتقد بود که برای متخصصان داده، دسترسی به ابزارهای کامل حداقل یکی از مدلهای پیشرو یک ضرورت است و یادگیری مهارتهای هوش مصنوعی با نسخههای رایگان مثل این است که بخواهید سه وعده غذای متعادل را فقط با نمونههای رایگان در فروشگاه بخورید.

او در تحلیل خود، گوگل Gemini 2.5 Pro را به عنوان «اسلحه بزرگ» مورد علاقه خود معرفی کرد، اما معتقد بود اشتراک ۲۰ دلاری آن ارزش کمتری نسبت به اشتراکهای انتروپیک (کلود) یا اوپنایآی دارد.

مقایسه کلود و اوپنایآی از نگاه برایان ژولیوس:

- کلود پرو (Claude Pro): به نظر او، کلود بهترین تجربه کاربری کلی را دارد. مدلهای آن «گفتگو محورتر» و کار با آنها لذتبخشتر است. این مدل به طور گستردهای توسط کدنویسها ترجیح داده میشود و مدل Claude Code آن که فقط در نسخههای پولی در دسترس است، یکی از بهترین دستیارهای کدنویسی هوش مصنوعی به حساب میآید. او همچنین کلود را برای تصویرسازی داده و استفاده از پروتکل MCP (که خود انتروپیک توسعه داده) بهتر میداند.

- اوپنایآی پلاس (OpenAI Plus): در مقابل، اوپنایآی با اشتراک ۲۰ دلاری خود ارزش فوقالعادهای ارائه میدهد. کاربران به طیف وسیعتری از مدلها دسترسی دارند و قابلیتهای چندوجهی آن بسیار قویتر از کلود است. برای مثال، دسترسی به یکی از بهترین ابزارهای تولید و ویرایش تصویر (DALL-E) و ابزارهای ویدیویی Sora را فراهم میکند، در حالی که کلود قابلیتهای بومی تولید تصویر یا ویدیو ندارد.

در نهایت، او انتخاب بین این دو را به وزندهی فردی به نقاط قوت هر کدام وابسته دانست، هرچند خودش با اختلاف کمی کلود را ترجیح میداد. نظرات کاربران دیگر هم جالب بود؛ برخی هر دو اشتراک را داشتند و آن را بهترین هزینهای که کردهاند میدانستند، در حالی که برخی دیگر به خاطر ویژگیهای خاصی مثل حافظه بلندمدت یا رابط کاربری، یکی را بر دیگری ترجیح میدادند.

منابع

- Gemini 2.5 Pro scores best on the 2025 IMO on MathArena! : r/Bard

- Denny Zhou on X: “LLMs for IMO 2025: gemini-2.5-pro (31.55%), o3 high (16.67%), Grok 4 (11.90%). https://t.co/MoaRJgBeN1 https://t.co/qJ6RQalEiH” / X

- MathArena – IMO Blogpost

- IMO 2025 Results — Humans Still Rule! 💪 | by Russell Lim | Nice Math Problems | Jul, 2025 | Medium

- MD Fazal Mustafa on X: “The best score was by Gemini 2.5. Hats off to Google their fou national models are now killing it.” / X

- The hardest high school math exam in the world, the 6 problem 9 hour IMO 2025, was this week. | Deedy Das

- IMO 2025 LLM Experiment Reveals AI’s Mathematical Reasoning Breakthroughs – Efficient Coder

- Tianhe (Kevin) Yu on X: “Such a good model. Generalizes well to the latest IMO problems” / X

- Lisan al Gaib on X: “Can I get one Gemini 3 Ultra please?” / X

- Great question in my DMs – “I’ve played with the free versions of the major AI models. | Brian Julius

دیدگاهتان را بنویسید