خلاصه

- دیپسیک یه مدل آزمایشی جدید به اسم V3.2-exp معرفی کرده که اصلیترین ویژگیش کاهش شدید هزینههای هوش مصنوعیه، مخصوصا برای کار با متنهای طولانی.

- این مدل از یه سیستم هوشمند به اسم «توجه پراکنده دیپسیک» (DSA) استفاده میکنه که باعث میشه مدل به جای پردازش همه کلمات، فقط روی مهمترینها تمرکز کنه و محاسبات کمتر بشه.

- قیمت API این مدل تا بیش از ۵۰ درصد، بخصوص برای توکنهای خروجی، کم شده؛ این یعنی استفاده ازش خیلی اقتصادیتر شده.

- تو بنچمارکها، عملکرد V3.2-exp تقریبا مثل مدل قبلی (V3.1-Terminus) مونده، هرچند تو بعضی تستهای استدلالی و کاربردی، یه کوچولو ضعیفتر عمل کرده و کوتاهتر جواب داده.

- شرکتهای بزرگ چینی مثل هواوی و کمبریکون خیلی سریع با این مدل سازگار شدن و پشتیبانی Day 0 رو براش فراهم کردن که نشون دهنده اهمیت این نوآوریه.

- دیپسیک این مدل رو متنباز و با لایسنس MIT منتشر کرده تا محققها و توسعهدهندهها بتونن آزادانه ازش استفاده و اصلاحش کنن.

- فرآیند آموزش این مدل شامل «تقطیر متخصص» و «یادگیری تقویتی یکپارچه» میشه که به حفظ دانش تخصصی و جلوگیری از فراموشی فاجعهبار کمک میکنه.

- برای شرکتها، استفاده از این مدل میتونه هزینهها رو کم کنه، اما باید ملاحظات امنیتی، انطباق با مقررات و انتخاب بین API یا میزبانی شخصی رو هم در نظر بگیرن.

- این مدل یه قدم مهم برای دیپسیک محسوب میشه که نشون میده این شرکت چینی میخواد در رقابت جهانی هوش مصنوعی با نوآوری و مقرون به صرفه بودن پیشرو باشه.

شرکت دیپسیک، که یه شرکت چینی فعال در حوزه هوش مصنوعیه، یه مدل آزمایشی جدید به اسم V3.2-exp رو معرفی کرده که سر و صدای زیادی به پا کرده. قضیه از این قراره که این مدل طوری طراحی شده که هزینههای استفاده ازش، مخصوصا وقتی با حجم زیادی از متن و اطلاعات کار میکنیم، به شکل قابل توجهی پایین بیاد. این خبر روز دوشنبه توسط خود محققهای دیپسیک اعلام شد و اونها این مدل رو روی پلتفرم هاگینگ فیس (Hugging Face) منتشر کردن و کنارش یه مقاله علمی هم در گیتهاب (GitHub) گذاشتن تا همه بتونن جزئیات فنیاش رو ببینن.

این مدل جدید یه جورایی یه قدم میانی به سمت معماری نسل بعدی دیپسیک به حساب میاد. در واقع، این مدل بر پایه نسخه قبلی یعنی V3.1-Terminus ساخته شده، اما یه ویژگی خیلی مهم و جدید بهش اضافه شده که کل ماجرا رو عوض کرده. این ویژگی جدید، که اسمش رو گذاشتن «توجه پراکنده دیپسیک» یا DeepSeek Sparse Attention، یه مکانیزم هوشمنده که باعث میشه مدل خیلی بهینهتر کار کنه. هدف اصلی از ارائه این نسخه آزمایشی این بوده که این مکانیزم جدید رو تست کنن و ببینن چقدر میتونه در آموزش و استفاده از مدل در سناریوهایی که با متنهای طولانی سر و کار داریم، کارایی رو بالا ببره.

این حرکت دیپسیک رو میشه به عنوان بخشی از تحقیقات مداوم این شرکت برای ساختن معماریهای ترنسفورمر کارآمدتر دید. تمرکز اصلی اونها روی بهبود بهرهوری محاسباتیه، مخصوصا زمانی که مدل داره دنبالههای متنی طولانی رو پردازش میکنه. این مشکل هزینههای پردازش، که بهش میگن «هزینه استنتاج» (inference cost)، یکی از چالشهای بزرگ دنیای هوش مصنوعیه. هزینه استنتاج در واقع خرج سرور و پردازشیه که برای استفاده از یه مدل هوش مصنوعیِ از قبل آموزش دیده لازمه و با هزینه آموزش اولیه مدل فرق داره. محققهای دیپسیک با این مدل جدید نشون دادن که دنبال راههایی برای بهینهتر کردن معماری بنیادی ترنسفورمر هستن و به نظر میرسه که هنوز جای زیادی برای بهبودهای بزرگ وجود داره.

راز کارایی بالا: سیستم «توجه پراکنده» چطور کار میکنه؟

مهمترین و کلیدیترین ویژگی مدل V3.2-exp همین سیستم «توجه پراکنده دیپسیک» یا به اختصار DSA هست. این یه سیستم پیچیده است که برای اولین بار تونسته به یه نوع توجه پراکنده خیلی دقیق و جزئینگر برسه. بیایم یه کم سادهتر توضیحش بدیم. مدلهای زبانی بزرگ قدیمیتر از یه مکانیزمی به اسم «توجه متراکم» (dense attention) استفاده میکنن. توی این روش، وقتی شما یه متن طولانی به مدل میدین، مدل برای پردازش هر کلمه (یا توکن)، اون رو با تک تک کلمههای دیگه توی کل متن مقایسه میکنه. این کار باعث میشه حجم محاسبات به صورت تصاعدی با طول متن زیاد بشه. یعنی اگه طول متن شما دو برابر بشه، حجم محاسبات خیلی بیشتر از دو برابر میشه. این قضیه باعث میشه مصرف حافظه و قدرت پردازشی سرورها به شدت بالا بره و در نتیجه هزینهها سر به فلک بکشه، مخصوصا وقتی با متنهای چند صد صفحهای کار میکنیم.

حالا سیستم DSA که دیپسیک طراحی کرده میاد این مشکل رو حل میکنه. این سیستم به جای اینکه همه توکنها رو با هم مقایسه کنه، خیلی هوشمندانه فقط توکنهای مهم و مرتبط رو برای توجه کردن انتخاب میکنه. این کار از طریق دو تا بخش اصلی انجام میشه:

- نمایهساز برقآسا (lightning indexer): این بخش اول کار رو شروع میکنه. وظیفهاش اینه که از بین کل متن طولانی که به مدل دادیم، یه سری بخشها و گزیدههای مشخص رو اولویتبندی کنه و بگه این قسمتها مهمترن.

- سیستم انتخاب توکن جزئینگر (fine-grained token selection system): بعد از اینکه بخشهای مهم مشخص شدن، این سیستم وارد عمل میشه و از داخل همون بخشهای انتخاب شده، توکنها یا کلمههای خاصی رو انتخاب میکنه تا وارد پنجره توجه محدود مدل بشن.

این دو تا سیستم در کنار هم باعث میشن که مدل بتونه روی بخشهای طولانی از متن کار کنه، در حالی که بار محاسباتی روی سرورها به مراتب کمتره. با این روش، منحنی افزایش هزینه خیلی صافتر و پایینتر باقی میمونه و دیگه با زیاد شدن طول متن، هزینهها به صورت انفجاری بالا نمیره. این ویژگی باعث میشه کارهایی مثل خلاصهسازی اسناد طولانی، چتهای چند مرحلهای با تاریخچه بلند، یا تحلیل کدهای بزرگ خیلی عملیتر و مقرون به صرفهتر بشه. در واقع، این سیستم بدون اینکه کیفیت خروجی مدل به شکل محسوسی پایین بیاد، تونسته بهبود قابل توجهی در کارایی آموزش و استفاده از مدل برای متنهای طولانی ایجاد کنه.

کاهش چشمگیر هزینهها در عمل

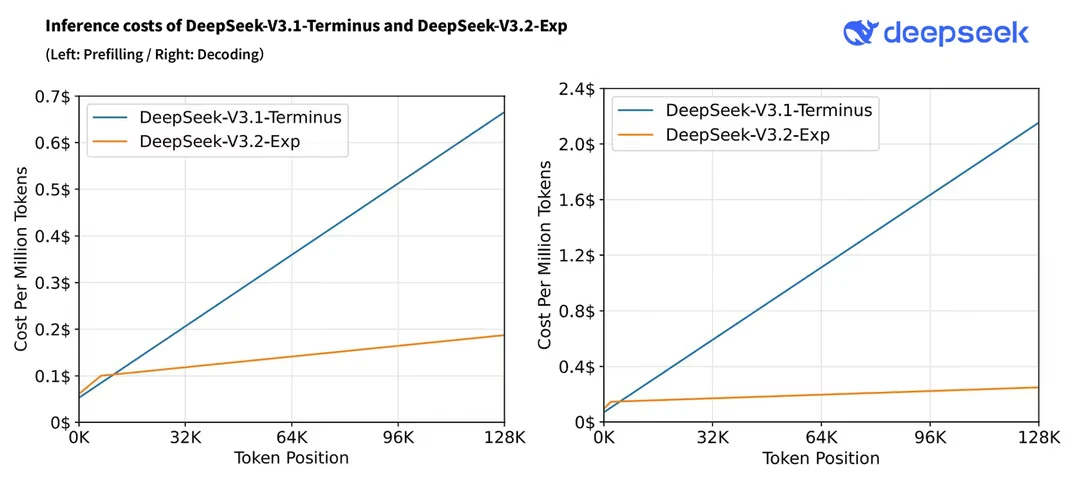

یکی از جذابترین نتایج استفاده از این معماری جدید، کاهش شدید هزینههاست. دیپسیک به خاطر همین بهبود، یه سیاست قیمتگذاری جدید رو پیاده کرده که هزینه فراخوانی API این مدل رو برای توسعهدهندهها بیشتر از ۵۰ درصد کم کرده. تستهای اولیهای که خود دیپسیک انجام داده نشون میده که قیمت یه فراخوانی ساده API در شرایطی که با متنهای طولانی کار میکنیم، میتونه تا نصف کاهش پیدا کنه.

برای اینکه دقیقتر متوجه بشیم، بیایم به اعداد و ارقام نگاه کنیم. قیمتگذاری جدید API به این صورته:

- ورودی (cache miss): برای هر یک میلیون توکن ورودی که در حافظه پنهان نیست، هزینه ۰.۲۸ دلاره.

- ورودی (cache hit): برای هر یک میلیون توکن ورودی که قبلا پردازش شده و در حافظه پنهان موجوده، هزینه فقط ۰.۰۲۸ دلاره.

- خروجی: برای هر یک میلیون توکن خروجی که مدل تولید میکنه، هزینه ۰.۴۲ دلاره.

این قیمتها در مقایسه با مدل قبلی یعنی V3.1-Terminus خیلی پایینتره. قیمتهای مدل قبلی به ترتیب ۰.۵۶ دلار، ۰.۰۷ دلار و ۱.۶۸ دلار برای هر یک میلیون توکن بود. بزرگترین کاهش قیمت مربوط به توکنهای خروجی بوده؛ قیمت تولید یک میلیون توکن خروجی در مدل جدید فقط ۳ دلاره که این یعنی یک چهارم قیمت مدلهای سری V3.1. این کاهش هزینه باعث شده بعضی از کاربرا بگن که API دیپسیک «تقریبا مجانی» شده.

برای اینکه یه مقایسه بهتر داشته باشیم، بیایم قیمت این مدل رو کنار چند تا از مدلهای معروف دیگه بذاریم:

| ارائهدهنده | مدل (نسخه ارزان/پایه) | قیمت ورودی (برای ۱ میلیون توکن) | قیمت خروجی (برای ۱ میلیون توکن) | نکات |

| DeepSeek | V3.2-Exp | $۰.۲۸ / $۰.۰۲۸ (کش شده) | $۰.۴۲ | |

| OpenAI | GPT-5 Nano | $۰.۰۵ / $۰.۰۰۵ (کش شده) | $۰.۴۰ | |

| Gemini 2.5 Flash-Lite | $۰.۱۰ | $۰.۴۰ | قیمت ورودی کش شده نداره | |

| Anthropic | Claude Haiku 3.5 | $۰.۸۰ / $۰.۰۸ (کش شده) | $۴.۰۰ | |

| xAI | Grok-4 Fast Non-Reasoning | $۰.۲۰ / $۰.۰۵ (کش شده) | $۰.۵۰ |

همونطور که تو جدول مشخصه، مدل V3.2-Exp یکی از ارزونترین گزینهها برای توسعهدهندهها به حساب میاد، هرچند که مدل GPT-5 Nano از OpenAI هنوز عنوان ارزونترین رو در اختیار داره.

عملکرد مدل در بنچمارکها چطوره؟

حالا سوال مهم اینه که آیا این کاهش هزینه به قیمت پایین اومدن کیفیت و تواناییهای مدل تموم شده؟ دیپسیک برای اینکه تاثیر این معماری جدید رو به دقت ارزیابی کنه، عمدا تنظیمات آموزشی مدل V3.2-Exp رو با مدل قبلی یعنی V3.1-Terminus یکسان نگه داشته. نتایج نشون میده که عملکرد این دو مدل در بنچمارکهای عمومی در زمینههای مختلف، تقریبا یکسانه و تفاوت محسوسی با هم ندارن. بنچمارکها تایید میکنن که این بدهبستان به درستی کار کرده. در حالی که امتیازها در بعضی از تستهای سنگین استدلالی مثل GPQA-Diamond و Humanity’s Last Exam یه مقدار کم شده، اما بهبود کارایی مدل و عملکرد پایدارش در بقیه زمینهها نشون میده که رویکرد پراکنده به طور قابل توجهی قابلیتهای مدل رو به خطر ننداخته.

در واقع، مدل V3.2-Exp با استفاده از توکنهای خیلی کمتری میتونه تسکها رو انجام بده. بیایم نگاهی به جدول مقایسه عملکرد این دو مدل بندازیم:

| بنچمارک | DeepSeek-V3.1-Terminus | DeepSeek-V3.2-Exp |

| استدلال بدون استفاده از ابزار | ||

| MMLU-Pro | ۸۵.۰ | ۸۵.۰ |

| GPQA-Diamond | ۸۰.۷ | ۷۹.۹ |

| Humanity’s Last Exam | ۲۱.۷ | ۱۹.۸ |

| LiveCodeBench | ۷۴.۹ | ۷۴.۱ |

| AIME 2025 | ۸۸.۴ | ۸۹.۳ |

| HMMT 2025 | ۸۶.۱ | ۸۳.۶ |

| Codeforces | ۲۰۴۶ | ۲۱۲۱ |

| Aider-Polyglot | ۷۶.۱ | ۷۴.۵ |

| استفاده ابزاری ایجنت | ||

| BrowseComp | ۳۸.۵ | ۴۰.۱ |

| BrowseComp-zh | ۴۵.۰ | ۴۷.۹ |

| SimpleQA | ۹۶.۸ | ۹۷.۱ |

| SWE Verified | ۶۸.۴ | ۶۷.۸ |

| SWE-bench Multilingual | ۵۷.۸ | ۵۷.۹ |

| Terminal-bench | ۳۶.۷ | ۳۷.۷ |

همونطور که میبینید، امتیاز MMLU-Pro روی ۸۵.۰ ثابت مونده، امتیاز AIME 2025 یه مقدار بهتر شده و به ۸۹.۳ رسیده، در حالی که امتیاز GPQA-Diamond از ۸۰.۷ به ۷۹.۹ کاهش پیدا کرده. بنچمارکهای کدنویسی و ایجنت هم داستان مشابهی دارن؛ امتیاز Codeforces از ۲۰۴۶ به ۲۱۲۱ افزایش پیدا کرده و امتیاز BrowseComp از ۳۸.۵ به ۴۰.۱ بهتر شده. این تعادل نشون دهنده همون بدهبستانیه که در طراحی مدل در نظر گرفته شده.

تجربه کاربری و بازخوردهای اولیه

با وجود نتایج خوب در بنچمارکها، بعضی از کاربرها و کارشناسها تو تجربههای اولیه خودشون متوجه تفاوتهایی شدن. به نظر میرسه مدل V3.2-Exp برای اینکه به کارایی بالاتری برسه، در بعضی از قابلیتهاش یه سری مصالحهها کرده.

برای مثال، در زمینه برنامهنویسی، کدی که این مدل مینویسه به شکل قابل توجهی کوتاهتر از مدل قبلیه. برای یه تسک یکسان، تعداد خطوط کد کمتری تولید میکنه. اما این کوتاهی گاهی روی عملکرد کد تاثیر منفی میذاره. در یه تستی که انجام شده، کد مربوط به یه انیمیشن پرش توپ که توسط V3.2-Exp نوشته شده بود، به درستی اجرا نشد و توپ از محدوده شش ضلعی خارج شد. این در حالیه که در تست قبلی، مدل V3.1-Terminus همین کار رو به خوبی انجام داده بود.

در یه تست دیگه مربوط به استخراج اطلاعات، از مدل خواسته شد چند تا گیاه مناسب برای گلدونهای بالکنی تازهکارها معرفی کنه که سریع رشد کنن، میوههاشون خام خوردنی باشه و برای بچهها کاملا امن باشن. در مقایسه با مدل V3.1-Terminus، جواب مدل V3.2-Exp کوتاهتر بود و کلماتی که استفاده کرده بود، یه مقدار «ساده» و معمولی به نظر میرسید. علاوه بر این، گیاههایی که معرفی کرده بود، مثل انجیر و پشن فروت، نیاز به کارهایی مثل قلمه زدن و نگهداری مداوم دارن که با شرط «مناسب برای تازهکارها» در صورت سوال همخوانی نداشت.

یه وبلاگنویس در پلتفرم Zhihu به اسم toyama nao هم در ارزیابی خودش به مشکلات مشابهی اشاره کرده. به نظر اون، مدل V3.2-Exp در حافظه کاری، پایداری دقت محاسباتی و موارد دیگه کمبودهای مشخصی داره و ممکنه مستعد کمکاری یا افتادن در حلقههای بینهایت باشه. این دیدگاه توسط بقیه کاربرها هم تایید شده. مثلا یه کاربری در پلتفرم ایکس (X) نوشته که هیچ بهبودی در این مدل ندیده و این سوال رو مطرح کرده که «چرا باید از مدلی با قابلیتهای کمتر استفاده کنیم؟».

با همه اینها، باید در نظر داشت که V3.2-Exp یه مدل «آزمایشی» هست. دیپسیک هم گفته که با اینکه کارایی این مدل روی دیتاستهای ارزیابی عمومی تایید شده، اما هنوز لازمه که در مقیاس بزرگتری در سناریوهای واقعی کاربر تست بشه تا احتمال عملکرد ضعیف در بعضی شرایط خاص رد بشه. شاید بشه گفت سهم بزرگتر این مدل در حال حاضر در سطح تئوری و معماریه تا بهبود عملکرد.

واکنش سریع صنعت و سازگاری شرکتهای بزرگ

به محض اینکه مدل V3.2-Exp عرضه شد، واکنش شدیدی در صنعت و بین توسعهدهندهها به وجود آورد. خیلی از شرکتهای داخلی چین بلافاصله اعلام کردن که سازگاری با این مدل رو انجام دادن و اون رو عرضه کردن.

- هواوی (Huawei): حساب رسمی محاسبات هواوی اعلام کرد که پلتفرم Ascend به سرعت سازگاری و پیادهسازی این مدل رو بر اساس فریمورکهای استنتاجی مثل vLLM و SGLang انجام داده و به پشتیبانی روز صفر (Day 0 support) رسیده. اونها تمام کدهای استنتاج و پیادهسازیهای اپراتور رو برای توسعهدهندهها متنباز کردن. طبق اعلام هواوی، وقتی مدل V3.2-Exp یه دنباله طولانی ۱۲۸ هزار توکنی رو روی دستگاههای Ascend تولید میکنه، میتونه سرعت استنتاج رو با زمان تا اولین توکن (TTFT) کمتر از ۲ ثانیه و زمان برای هر توکن خروجی (TPOT) کمتر از ۳۰ میلیثانیه حفظ کنه. همچنین، پلتفرم ابری هواوی (Huawei Cloud) اولین پلتفرمی بود که این مدل رو عرضه کرد و از سوپرنود CloudMatrix 384 برای ارائه خدمات استنتاج این مدل استفاده میکنه.

- کمبریکون (Cambricon): فقط چهار دقیقه بعد از اینکه دیپسیک خبر متنباز شدن مدل رو اعلام کرد، کمبریکون هم پستی منتشر کرد و گفت که به طور همزمان به سازگاری روز صفر با این مدل رسیده و سورس کد موتور استنتاج مدل بزرگ vLLM-MLU رو هم متنباز کرده. این شرکت تونسته با استفاده از توسعه اپراتور تریتون (Triton) به سازگاری سریع برسه و با توسعه اپراتور ترکیبی BangC عملکرد رو بهینه کنه. با توجه به اینکه حجم مدل V3.2-Exp به ۶۷۱ گیگابایت میرسه و دانلودش ممکنه چند ساعت طول بکشه، این سازگاری سریع چهار دقیقهای احتمالا به این معنیه که کمبریکون و دیپسیک قبل از عرضه رسمی مدل، کار سازگاری رو شروع کرده بودن.

- هایگون اینفورمیشن (Hygon Information): طبق گزارشها، واحد محاسبات عمیق (DCU) این شرکت هم به سرعت به سطح سازگاری و بهینهسازی روز صفر برای این مدل رسیده تا استقرار قدرت محاسباتی برای این مدل بزرگ «بدون هیچ انتظاری» ممکن باشه.

علاوه بر این شرکتهای تولیدکننده چیپ، پلتفرمهای ابری مثل PPIO و UCloud هم عرضه این مدل رو اعلام کردن. این واکنش سریع صنعت باعث شده بعضی از کاربرها بگن که شاید «لحظه دوم دیپسیک» در حال رخ دادنه.

دیپسیک در منظره هوش مصنوعی جهانی

دیپسیک که در چین مستقره، یه چهره غیرمعمول در رونق هوش مصنوعی بوده، مخصوصا برای کسایی که تحقیقات هوش مصنوعی رو یه مبارزه ناسیونالیستی بین آمریکا و چین میبینن. این شرکت در ابتدای سال با مدل R1 خودش موجی ایجاد کرد. اون مدل عمدتا با استفاده از یادگیری تقویتی (reinforcement learning) و با هزینهای خیلی کمتر از رقبای آمریکاییاش آموزش داده شده بود. اما برخلاف پیشبینی بعضیها، مدل R1 باعث یه انقلاب تمامعیار در آموزش هوش مصنوعی نشد و این شرکت در ماههای بعد از کانون توجهها دور شد.

مدلهای سری V3 که در دسامبر ۲۰۲۴ معرفی شدن، به عنوان جایگزینهای چندمنظوره و مقرون به صرفه برای سری R1 که بیشتر روی استدلال سنگین تمرکز داره، قرار گرفتن. در حالی که R1 در منطق ساختاریافته، ریاضیات و استدلال چند مرحلهای عالی عمل میکنه، اما کندتر و گرونتره. در مقابل، مدلهای V3 برای کاربردهای عمومی مثل نوشتن، خلاصهسازی، چت با مشتری و کدنویسی پایه ساخته شدن. مدل V3.1-Terminus که فقط یک هفته قبل از V3.2-Exp منتشر شد، یه اصلاحیه روی V3.1 بود که برای بهبود استدلال مبتنی بر ابزار و کاهش خطاهای ترکیب زبان (مثل وارد کردن کلمات چینی در پاسخهای انگلیسی) طراحی شده بود.

حالا با V3.2-Exp، دیپسیک داره نوآوری معماری رو از طریق توجه پراکنده وارد بازی میکنه و همزمان مدل انتشار متنباز و لایسنس MIT رو حفظ کرده. رویکرد جدید «توجه پراکنده» احتمالا به اندازه مدل R1 سر و صدا به پا نمیکنه، اما هنوز میتونه به ارائهدهندههای آمریکایی ترفندهای خیلی لازمی رو برای پایین نگه داشتن هزینههای استنتاج یاد بده.

فرآیند پس از آموزش: تقطیر متخصص و یادگیری تقویتی

علاوه بر تغییرات معماری، مدل V3.2-Exp اصلاحاتی رو هم در فرآیند پس از آموزش (post-training) معرفی میکنه. این شرکت از یه رویکرد دو مرحلهای استفاده میکنه: تقطیر متخصص (specialist distillation) و یادگیری تقویتی.

مرحله اول، یعنی تقطیر متخصص، با آموزش مدلهای جداگانه برای ریاضیات، برنامهنویسی رقابتی، استدلال منطقی، کدنویسی ایجنتی و جستجوی ایجنتی شروع میشه. این متخصصها که از روی یه چکپوینت پایه یکسان فاینتون شدن، با آموزش در مقیاس بزرگ تقویت میشن تا دادههای مخصوص به حوزه خودشون رو تولید کنن. بعد، این دادهها دوباره به داخل چکپوینت نهایی «تقطیر» میشن تا اطمینان حاصل بشه که مدل نهایی از دانش متخصصها بهرهمند شده در حالی که هنوز یه مدل عمومی باقی میمونه.

مرحله دوم، یعنی یادگیری تقویتی، یه تغییر بزرگ رو نشون میده. به جای رویکرد چندمرحلهای که در مدلهای قبلی دیپسیک استفاده میشد، آموزش استدلال، ایجنت و همسوسازی انسانی در یک مرحله واحد RL با استفاده از بهینهسازی سیاست نسبی گروهی (GRPO) ادغام شدن. این فرآیند یکپارچه، عملکرد رو در حوزههای مختلف متعادل میکنه و همزمان از مشکلات «فراموشی فاجعهبار» (catastrophic forgetting) که اغلب در پایپلاینهای چندمرحلهای به وجود میاد، جلوگیری میکنه. طراحی پاداش در این مرحله ترکیبی از سیگنالهای نتیجه مبتنی بر قانون، جریمههای طول متن، بررسیهای ثبات زبان و یه مدل پاداش مولد هست که توسط دستورالعملهای مخصوص هر تسک هدایت میشه. نتایج آزمایشی نشون میده که مدل تقطیر شده و تقویت شده تقریبا همسطح با متخصصهای حوزههای خاص عمل میکنه و این شکاف بعد از آموزش RL به طور موثری بسته میشه.

دسترسی متنباز و گزینههای پیادهسازی

دیپسیک در راستای رویکرد باز خودش، وزنهای مدل V3.2-Exp رو در هاگینگ فیس تحت لایسنس MIT منتشر کرده. این یعنی محققها و شرکتها میتونن آزادانه این مدل رو دانلود، اصلاح و برای استفاده تجاری پیادهسازی کنن. این مدل با حجم ۶۸۵ میلیارد پارامتر، از انواع تنسورهای مختلفی مثل BF16، FP8 و FP32 پشتیبانی میکنه.

این عرضه با کرنلهای متنباز همراه شده:

- TileLang: برای نمونهسازی سریع تحقیقاتی.

- CUDA/FlashMLA/DeepGEMM: کرنلهای CUDA با کارایی بالا، کرنلهای لاجیت نمایهساز (شامل نسخههای صفحهبندی شده) در DeepGEMM و کرنلهای توجه پراکنده در FlashMLA در دسترس هستن.

علاوه بر این، دیپسیک کدهای دموی استنتاج بهروز شده رو هم ارائه کرده تا جامعه کاربری بتونه به سرعت با مدل شروع به کار کنه و جزئیات معماری اون رو بفهمه. برای شروع، باید وزنهای مدل هاگینگ فیس رو به فرمت مورد نیاز دموی استنتاج تبدیل کرد. همچنین، دیپسیک ایمیجهای داکر (Docker) سازگار با چیپهای NVIDIA H200، AMD MI350 و NPU ها رو هم فراهم کرده تا پیادهسازی محلی راحتتر بشه.

پشتیبانی فریمورکها هم خیلی سریع اتفاق افتاد. LMSYS Org، تیم پشتیبان SGLang، اعلام کرد که این فریمورک حالا به طور رسمی از V3.2 با کرنلهای بهینه توجه پراکنده، کشینگ دینامیک کلید-مقدار و مقیاسپذیری تا ۱۲۸ هزار توکن پشتیبانی میکنه. فریمورک vLLM هم پشتیبانی روز اول رو برای این مدل فراهم کرده.

ملاحظاتی برای تصمیمگیرندگان سازمانی

برای شرکتها، مخصوصا شرکتهای آمریکایی، صرفهجویی در هزینهای که API دیپسیک ارائه میده خیلی جذابه، اما قبل از پذیرش اون باید ملاحظات دیگهای رو هم در نظر گرفت:

- امنیت داده و انطباق با مقررات: استفاده از API میزبانی شده دیپسیک به این معنیه که دادهها از طریق سرورهایی که توسط یه شرکت مستقر در هنگکنگ اداره میشن، عبور میکنن. شرکتهایی که با دادههای حساس مشتریان سر و کار دارن یا در صنایع تحت نظارت مثل بهداشت، مالی یا دفاعی فعالیت میکنن، باید پیامدهای قانونی و حاکمیتی این موضوع رو به دقت ارزیابی کنن. البته میزبانی شخصی وزنهای متنباز مدل میتونه این ریسکها رو کم کنه، هرچند که مسئولیتهای زیرساختی و نگهداری رو به داخل شرکت منتقل میکنه.

- عملکرد در برابر کنترل: API دسترسی فوری با هزینههای قابل پیشبینی و مقیاسپذیری رو ارائه میده. اما میزبانی شخصی حداکثر کنترل رو، مخصوصا روی محل نگهداری داده و تاخیر، فراهم میکنه ولی به منابع مهندسی قابل توجه و در دسترس بودن GPU نیاز داره. تصمیمگیرندهها باید بین سرعت پذیرش و هزینههای عملیاتی یه تعادل برقرار کنن.

- تنوعبخشی به فروشندگان: با توجه به اینکه خیلی از شرکتهای آمریکایی در حال حاضر به OpenAI، Anthropic یا Google وابسته هستن، رویکرد متنباز دیپسیک میتونه یه راه برای جلوگیری از وابستگی به یک فروشنده خاص باشه. با این حال، ادغام مدلهای یه ارائهدهنده چینی ممکنه سوالاتی رو از طرف هیئت مدیره یا مسئولین امنیتی ایجاد کنه.

- هزینه کل مالکیت: در حالی که API به ازای هر توکن ارزونتره، شرکتهایی که حجم کاری بالا و ثابتی دارن ممکننه در بلندمدت با اجرای مدل متنباز روی زیرساختهای خودشون یا از طریق میزبانهای شخص ثالث مورد اعتماد، صرفهجویی بیشتری کنن. با این حال، بر اساس معماری مدل، حتی اونهایی که مدل جدید V3.2-Exp رو روی سرورها و سختافزارهای خودشون اجرا میکنن، باید هزینههای به مراتب کمتری رو برای ورودیهای با تعداد توکن بالا ببینن.

برای تصمیمگیرندگان آمریکایی که دیپسیک رو ارزیابی میکنن، محاسبات فقط مربوط به قیمت API نیست؛ بلکه مربوط به همسو کردن مقرون به صرفه بودن با تحمل ریسک، الزامات قانونی و استراتژی زیرساختیه.

قدم بعدی برای دیپسیک چیست؟

مدل DeepSeek-V3.2-Exp نشون میده که چطور یه بازیگر متنباز میتونه مدلهای پیشرفته رو توسعه بده و همزمان به چالشهای عملی هزینه و پیادهسازی رسیدگی کنه. با معرفی توجه پراکنده، کاهش قیمتهای API، ادغام یادگیری تقویتی در یک مرحله واحد و حفظ شفافیت کامل از طریق انتشار در هاگینگ فیس و گیتهاب، دیپسیک هم یه بستر آزمایشی تحقیقاتی و هم یه گزینه سازمانی قابل قبول رو ارائه کرده.

اضافه شدن فریمورکهایی مثل SGLang و vLLM به اکوسیستم رسمی عرضه این مدل، این پیام رو میده که دیپسیک به دنبال ایجاد یکپارچگی گسترده با جامعه کاربریه تا اینکه توزیع رو محدود کنه. در عین حال، ماهیت آزمایشی V3.2-Exp جا رو برای تکرار و بهبود باز میذاره. ارزیابیهای داخلی نتایج امیدوارکنندهای رو نشون میدن، اما دیپسیک تایید میکنه که به طور فعال در حال تست این معماری در سناریوهای دنیای واقعیه تا هرگونه محدودیتی رو کشف کنه.

اینکه آیا این معماری آزمایشی به پایه و اساس یه نسخه گستردهتر V3.3 یا V4 تبدیل میشه یا نه، هنوز مشخص نیست. اما در حال حاضر، عرضه V3.2-Exp نشوندهنده عزم دیپسیک برای باقی موندن در صحنه رقابتی جهانی هوش مصنوعیه. دیپسیک برای اینکه توسعهدهندهها بتونن این دو مدل رو با هم مقایسه کنن، به طور موقت رابط API مدل V3.1-Terminus رو تا تاریخ ۱۵ اکتبر ۲۰۲۵ در دسترس نگه داشته، اما بعد از اون این مدل کنار گذاشته میشه.

دیدگاهتان را بنویسید