اینکه مدلهای هوش مصنوعی بتونن همزمان با تولید جواب به صورت زنده و آنی، ایمنی رو هم رعایت کنن، سوال مهمیه. تیم Qwen در شرکت علیبابا با معرفی خانواده جدیدی از مدلها به اسم Qwen3Guard، به این سوال جواب داده. این مدلها به طور خاص برای نظارت روی پرامپتها و پاسخهای در حال تولید (استریم) به صورت لحظهای و برای استفاده جهانی ساخته شدن.

این خانواده مدل، چندزبانه هست و برای نظارت روی محتوا طراحی شده. Qwen3Guard در دو مدل اصلی عرضه میشه:

- Qwen3Guard-Gen: این مدل یک طبقهبندی کننده مولد (generative) هست که کل متن پرامپت و پاسخ رو با هم میخونه و تحلیل میکنه.

- Qwen3Guard-Stream: این مدل یک طبقهبندی کننده در سطح توکن (token-level) هست و همزمان با تولید متن، کلمه به کلمه اون رو نظارت میکنه.

هر دوی این مدلها در سه اندازه مختلف با پارامترهای ۰.۶ میلیارد، ۴ میلیارد و ۸ میلیارد ارائه شدن. هدف اصلیشون هم پوشش جهانیه و به همین خاطر از ۱۱۹ زبان و گویش مختلف پشتیبانی میکنن. این مدلها به صورت متن-باز منتشر شدن و وزنهاشون روی Hugging Face و کدهاشون در ریپازیتوری GitHub در دسترسه.

ویژگیهای جدید Qwen3Guard چی هست؟

این مدلها چندتا قابلیت کلیدی دارن که اونها رو از بقیه متمایز میکنه.

نظارت همزمان با تولید متن (Streaming)

مدل Qwen3Guard-Stream دو تا «هِد» یا سر طبقهبندی کننده سبکوزن داره که به آخرین لایه ترنسفورمر مدل متصل شدن. کار این دو بخش به این صورته:

- یک «هد» پرامپت یا دستور کاربر رو نظارت میکنه.

- «هد» دوم هر توکنی (کلمه یا بخشی از کلمه) که توسط مدل تولید میشه رو به صورت لحظهای امتیازبندی میکنه.

این امتیازدهی در سه سطح انجام میشه: Safe (ایمن) / Controversial (بحثبرانگیز) / Unsafe (ناامن). این قابلیت باعث میشه که بشه قوانین ایمنی رو همون موقع که جواب داره تولید میشه اعمال کرد و دیگه لازم نیست تا پایان تولید پاسخ صبر کرد و بعدا اون رو فیلتر کرد.

سه سطح برای طبقهبندی ریسک

به جای اینکه محتوا فقط به دو دسته «ایمن» و «ناامن» تقسیم بشه، یک سطح سوم به اسم «بحثبرانگیز» (Controversial) هم بهش اضافه شده. این سطح برای محتواییه که در مرز قرار داره و کاملا ایمن یا کاملا ناامن نیست. این ویژگی به تیمها اجازه میده که میزان سختگیری رو تنظیم کنن. مثلا میشه در بعضی کاربردهای حساس، محتوای «بحثبرانگیز» رو هم جزو دسته ناامن حساب کرد، یا در جاهای دیگه مثل چتهای عمومی، اجازه داد که این محتوا با نظارت بیشتر نمایش داده بشه.

خروجیهای ساختاریافته در مدل Gen

مدل Qwen3Guard-Gen که کل متن رو بررسی میکنه، خروجی خودش رو در یک قالب استاندارد و مشخص ارائه میده. این قالب به این شکله:

Safety: ... Categories: ... Refusal: ...

این ساختار منظم باعث میشه که پردازش خروجی برای خطوط لوله (pipelines) و توابع پاداش در یادگیری تقویتی (RL) خیلی ساده بشه. دستهبندیهایی که این مدل برای محتوای ناامن در نظر گرفته شامل موارد زیر میشه:

- خشونت (Violent)

- اقدامات غیرقانونی بدون خشونت (Non-violent Illegal Acts)

- محتوای جنسی (Sexual Content)

- اطلاعات هویتی شخصی (PII)

- خودکشی و خودآزاری (Suicide & Self-Harm)

- اقدامات غیراخلاقی (Unethical Acts)

- موضوعات حساس سیاسی (Politically Sensitive Topics)

- نقض حق کپیرایت (Copyright Violation)

- جیلبریک یا تلاش برای دور زدن مدل (Jailbreak)

- پاداش فقط بر اساس گاردریل (Guard-only reward): در این حالت، ایمنی به حداکثر میرسه اما مدل خیلی بیشتر از قبل از جواب دادن امتناع میکنه و نرخ پیروزیش در بنچمارک arena-hard-v2 کمی پایین میاد.

- پاداش ترکیبی (Hybrid reward): در این حالت، علاوه بر ایمنی، به مدل برای امتناع بیش از حد امتیاز منفی داده میشه و سیگنالهای کیفیت هم در نظر گرفته میشه. نتیجه این بود که امتیاز ایمنی مدل در بنچمارک WildGuard از حدود ۶۰ به بالای ۹۷ رسید، بدون اینکه عملکردش در تسکهای استدلالی افت کنه. حتی نرخ پیروزیش در arena-hard-v2 کمی هم بهتر شد. این روش یک راهکار عملی برای تیمهایی هست که قبلا با مشکل «امتناع از پاسخ به همه چیز» در مدلهاشون مواجه بودن.

- Qwen3-VL-235B-A22B: یک مدل غولپیکر در زمینه بینایی کامپیوتری با ۲۳۵ میلیارد پارامتر و حجم ۴۷۱ گیگابایت که در دو نسخه Instruct و Thinking عرضه شده. گفته شده که نسخه Instruct اون در بنچمارکهای ادراک بصری با Gemini 2.5 Pro رقابت میکنه یا حتی از اون بهتره.

- Qwen3-Max: بزرگترین و تواناترین مدل تیم Qwen تا به امروز که یک مدل «تریلیون پارامتری» توصیف شده و فقط از طریق API در دسترسه.

- Qwen 3 Coder: نسخه ارتقا یافته مدل کدنویسی Qwen که این هم فقط از طریق API قابل استفاده هست.

- Qwen3-LiveTranslate-Flash: یک مدل برای ترجمه و تفسیر چندرسانهای به صورت لحظهای.

- [۱] Qwen

- [۳] Qwen on X: “🛡️ Meet Qwen3Guard — the Qwen3-based safety moderation model series built for global, real-time AI safety! 🌍 Supports ۱۱۹ languages and dialects ✅ ۳ sizes available: ۰.6B, 4B, 8B ⚡ Low-latency, Real-time streaming detection with Qwen3Guard-Stream 📝 Robust Full-context safety https://t.co/4ofo0jALk1” / X

عملکرد در بنچمارکها و یادگیری تقویتی ایمنی

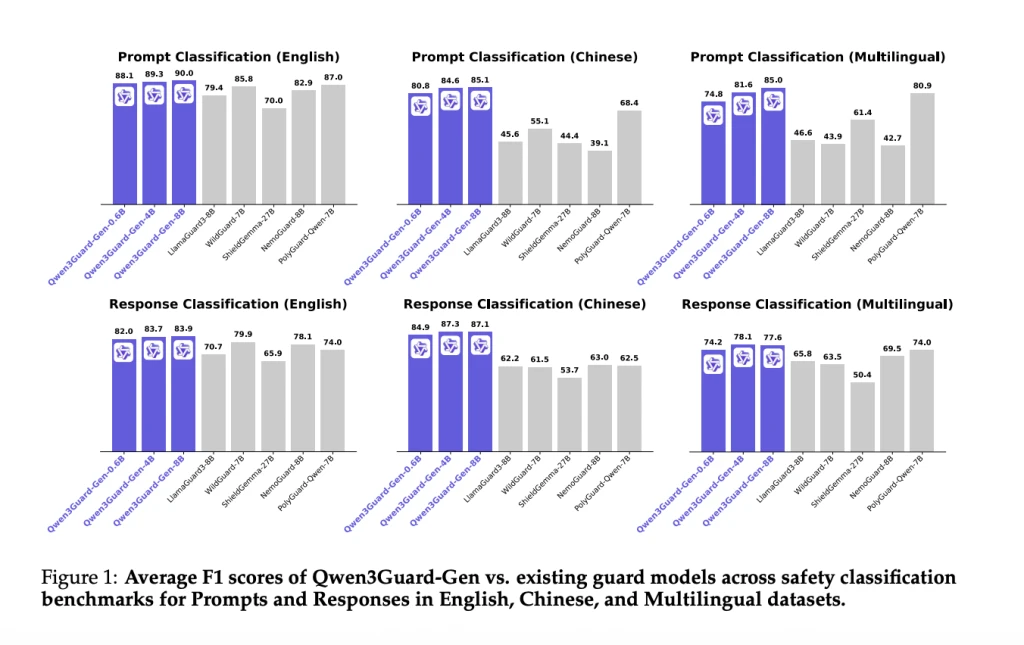

تیم تحقیقاتی Qwen نتایجی رو منتشر کرده که نشون میده مدل Qwen3Guard-Gen در طبقهبندی پرامپت و پاسخ، در بنچمارکهای ایمنی انگلیسی، چینی و چندزبانه به میانگین امتیاز F1 بالایی رسیده و عملکردی «state-of-the-art» یا پیشرفته داشته. تیم سازنده بیشتر روی برتری مداوم این مدل در شرایط مختلف نسبت به مدلهای متن-باز قبلی تاکید داره تا اینکه فقط به یک عدد نهایی تکیه کنه.

این تیم همچنین از Qwen3Guard-Gen به عنوان یک سیگنال پاداش برای آموزش مدلهای دستیار با استفاده از یادگیری تقویتی (RL) استفاده کرده. نتایج این آزمایشها به دو شکل بوده:

جایگاه Qwen3Guard کجاست؟

بیشتر مدلهای گاردریل متن-باز فقط خروجیهای کامل شده رو طبقهبندی میکنن. اما Qwen3Guard با داشتن دو «هد» نظارتی و امتیازدهی در سطح توکن، برای دستیارهای هوش مصنوعی که پاسخها رو به صورت استریم و زنده تولید میکنن، خیلی مناسبتره. این ویژگی امکان مداخله سریع (مثل مسدود کردن، ویرایش یا تغییر مسیر پاسخ) رو با تاخیر (latency) کمتری فراهم میکنه. دسته «بحثبرانگیز» هم به راحتی با سیاستهای شرکتها و سازمانها هماهنگ میشه. مثلا یک شرکت میتونه در محیطهای کاری حساس، این دسته رو ناامن در نظر بگیره ولی در یک چتبات عمومی، اجازه نمایش اون رو با بررسی بیشتر بده.

بخشی از یک خانواده بزرگتر

انتشار Qwen3Guard همزمان با معرفی چند مدل دیگه از طرف تیم Qwen بوده. این نشون میده که این مدل بخشی از یک اکوسیستم بزرگتر و در حال توسعه هست. مدلهای دیگهای که تقریبا همزمان معرفی شدن عبارتند از:

این مدلها در کنار پروژههای دیگهای مثل Qwen-Image-Edit ،Qwen3-Omni و Qwen3-TTS-Flash قرار میگیرن و نشون دهنده فعالیت گسترده تیم Qwen در زمینههای مختلف هوش مصنوعیه. در این بین، Qwen3Guard که با هدف مشابهی با مدل Llama Guard از شرکت متا ساخته شده، به عنوان یک ابزار ایمنی متن-باز با لایسنس Apache 2.0 در دسترس عموم قرار گرفته.

دیدگاهتان را بنویسید