خلاصه

- لیکویید ایآی مدلهای جدید هوش مصنوعی LFM2-VL رو معرفی کرده که برای اجرا مستقیم روی گوشی و لپتاپ طراحی شدن.

- هدف اصلی این مدلها آوردن هوش مصنوعی پیشرفته، مخصوصاً درک تصویر، به دستگاههای شخصی شماست تا به اینترنت دائمی وابسته نباشید.

- LFM2-VL خیلی سریع کار میکنه و اطلاعاتتون هم امن میمونه، چون دیگه لازم نیست دادهها به سرورهای ابری فرستاده بشن.

- دو نسخه از این مدل هست: LFM2-VL-450M برای دستگاههای با منابع کم و LFM2-VL-1.6B برای تحلیلهای پیچیدهتر با حفظ بهینگی.

- این مدلها میتونن تصاویر رو با رزولوشن اصلیشون پردازش کنن و حتی تصاویر بزرگ رو به صورت هوشمندانه تکه تکه کنن تا جزئیات حفظ بشن.

- لیکویید ایآی این مدلها رو بر اساس معماریهای جدید خودش ساخته که از ترنسفورمرهای سنتی بهینهتر هستن.

- نتایج بنچمارکها نشون میده که LFM2-VL در کنار سرعت بالا، دقت خوبی هم داره و حتی از بعضی رقبای بزرگتر هم بهتره.

- این مدلها روی Hugging Face در دسترس توسعهدهندهها هستن و میتونن برای ساخت اپلیکیشنهای هوش مصنوعی لبه استفاده بشن.

- این حرکت میتونه صنعت گوشیهای هوشمند رو متحول کنه و دستگاههای واقعاً هوشمند رو بدون نیاز به سرورهای ابری به بازار بیاره.

- در کل، هدف اینه که هوش مصنوعی قدرتمند و چندوجهی روی دستگاههای شخصی، بدون فدا کردن کیفیت، در دسترس همه باشه.

این روزها حرف و حدیث در مورد هوش مصنوعی همه جا هست، اما بیشتر وقتها وقتی از یک هوش مصنوعی قدرتمند حرف میزنیم، منظورمون یک سیستم خیلی بزرگه که روی سرورهای غولپیکر در یک دیتاسنتر دوردست اجرا میشه. ما سوالی میپرسیم یا دستوری میدیم، اطلاعات ما به اون سرورها فرستاده میشه، اونجا پردازش میشه و جوابش برای ما برمیگرده. این روش کار میکنه، اما مشکلاتی هم داره. ممکنه کند باشه، به اینترنت دائمی نیاز داشته باشه و همیشه این نگرانی در مورد حریم خصوصی و اینکه اطلاعات ما کجا میره وجود داره. حالا یک شرکت به اسم لیکویید ایآی (Liquid AI) وارد میدون شده و میخواد این بازی رو عوض کنه. اونها یک مدل هوش مصنوعی جدید به اسم LFM2-VL رو منتشر کردن که هدفش اینه که هوش مصنوعی پیشرفته رو از دیتاسنterها بیاره و مستقیم بذاره توی جیب ما، روی گوشیهای هوشمند، لپتاپها، گجتهای پوشیدنی و سیستمهای کوچیک دیگه.

ایده اصلی اینه که یک هوش مصنوعی کوچیک، سریع و در عین حال توانا داشته باشیم که بتونه «ببینه». یعنی فقط با متن کار نکنه، بلکه تصاویر رو هم درک و تحلیل کنه. این مدلهای جدید، که نسل تازهای از مدلهای بنیادی زبان-تصویر به حساب میان، جوری طراحی شدن که روی سختافزارهای مختلف، از قوی تا ضعیف، به شکل بهینهای اجرا بشن. این یعنی دیگه لازم نیست برای هر کاری به سرورهای ابری وابسته باشیم. این مدلها عملکردی با تاخیر کم و دقت بالا رو ارائه میدن و خیلی منعطف هستن، که باعث میشه برای کاربردهای دنیای واقعی حسابی مناسب باشن. این یک قدم مهم در مسیر غیرمتمرکز کردن هوش مصنوعیه، یعنی به جای اینکه قدرت پردازش در دست چند شرکت بزرگ با دیتاسنترهای عظیم باشه، پخش بشه و روی دستگاههای شخصی خودمون اجرا بشه. این کار هم سرعت پاسخگویی رو بالا میبره و هم اطلاعات شخصی ما رو امن نگه میداره، چون دیگه لازم نیست از دستگاه ما خارج بشن.

یک هوش مصنوعی جدید برای دستگاههای روزمره

شرکت لیکویید ایآی با معرفی LFM2-VL، یک حرکت جسورانه انجام داده تا روش کار هوش مصنوعی روی دستگاههای روزمره ما رو متحول کنه. این مدل بنیادی زبان-تصویر به طور خاص برای «محاسبات لبه» یا همون «edge computing» طراحی شده. محاسبات لبه یعنی پردازش اطلاعات تا جای ممکن نزدیک به منبع تولید اونها انجام بشه، یعنی روی خود دستگاه، نه در یک سرور مرکزی. این مدل میخواد هوش بصری پیچیده رو مستقیما به گوشیهای هوشمند، لپتاپها و بقیه گجتهای قابل حمل بیاره، بدون اینکه نیازی به تکیه بر سرورهای ابری داشته باشه.

این مدل روی کارهای قبلی شرکت لیکویید ایآی در زمینه مدلهای بنیادی که برای اجرا روی دستگاههای محلی بهینه شده بودن، ساخته شده. کارشناسهای این صنعت میگن این عرضه جدید، مشکلات اصلی فناوری هوش مصنوعی فعلی مثل تاخیر بالا و نگرانیهای مربوط به حریم خصوصی که با سیستمهای وابسته به ابر به وجود میاد رو هدف گرفته. با پردازش دادهها روی خود دستگاه، این مدل پاسخهای سریعتری رو تضمین میکنه و اطلاعات کاربر رو امن نگه میداره. این موضوع خیلی حیاتیه، مخصوصا حالا که قوانین مربوط به حریم خصوصی دادهها در سراسر جهان روز به روز سختگیرانهتر میشه.

مدل LFM2-VL در واقع بر پایه معماری قبلی همین شرکت یعنی LFM2 ساخته شده که حدود یک ماه قبل از این مدل معرفی شده بود. اون موقع، LFM2 به عنوان «سریعترین مدل بنیادی روی دستگاه در بازار» شناخته میشد. دلیل این سرعت، رویکرد خاصی بود که در اون «وزنها» یا همون تنظیمات مدل، برای هر ورودی به صورت لحظهای و درجا تولید میشن. این سیستم که بهش «سیستم خطی متغیر با ورودی» یا «Linear Input-Varying (LIV)» میگن، حالا در LFM2-VL گسترش پیدا کرده و بهش قابلیت پردازش چندوجهی یا «multimodal» داده. این یعنی مدل جدید میتونه هم ورودیهای متنی و هم ورودیهای تصویری رو با رزولوشنهای مختلف پردازش کنه. به گفته لیکویید ایآی، این مدلها تا دو برابر سرعت استنتاج (inference) روی پردازندههای گرافیکی (GPU) رو در مقایسه با مدلهای زبان-تصویر مشابه ارائه میدن و همزمان عملکرد رقابتی خودشون رو در بنچمارکهای رایج حفظ میکنن.

رامین حسنی، یکی از بنیانگذاران و مدیرعامل لیکویید ایآی، در یک پست در شبکه اجتماعی ایکس (توییتر سابق) برای معرفی این خانواده جدید از مدلها نوشت: «بهینگی محصول ماست». این جمله کوتاه نشون میده که تمرکز اصلی این شرکت روی ساختن هوش مصنوعیای هست که با منابع کمتر، کارایی بیشتری داشته باشه.

دو نسخه برای نیازهای متفاوت

لیکویید ایآی برای اینکه بتونه نیازهای مختلفی رو پوشش بده، دو نسخه از این مدل رو منتشر کرده. این دو نسخه از نظر اندازه و قابلیت با هم فرق دارن ولی هر دو برای اجرا روی دستگاههای شخصی طراحی شدن.

- LFM2-VL-450M: این نسخه یک مدل فوقالعاده بهینه است که کمتر از نیم میلیارد پارامتر (تنظیمات داخلی) داره. این مدل به طور خاص برای محیطهایی طراحی شده که منابع خیلی محدودی دارن. مثلا دستگاههای کوچیکی که پردازنده و حافظه کمی دارن. با داشتن کمتر از ۵۰۰ میلیون پارامتر، این مدل میتونه روی خیلی از دستگاههای ضعیفتر هم به خوبی کار کنه و قابلیتهای هوش مصنوعی بصری رو به اونها اضافه کنه.

- LFM2-VL-1.6B: این نسخه، مدل قویتر این خانواده است. با داشتن ۱.۶ میلیارد پارامتر، توانایی بیشتری برای تحلیلهای پیچیدهتر داره. اما نکته مهم اینجاست که با وجود این قدرت بیشتر، هنوز هم به اندازهای سبک و بهینه است که میتونه روی یک پردازنده گرافیکی (GPU) معمولی یا مستقیما روی دستگاههای مختلف اجرا بشه. این مدل یک تعادل خوب بین قدرت و بهینگی برقرار میکنه.

هر دوی این مدلها میتونن تصاویر رو با رزولوشن اصلی خودشون تا ابعاد ۵۱۲ در ۵۱۲ پیکسل پردازش کنن. این یک ویژگی خیلی مهمه چون از تغییر شکل یا بزرگنماییهای غیرضروری تصاویر جلوگیری میکنه. وقتی یک مدل مجبور میشه تصویر رو بزرگ یا کوچیک کنه، معمولا بخشی از جزئیات از بین میره یا تصویر دچار اعوجاج میشه. اما این مدلها با پردازش رزولوشن اصلی، این مشکل رو ندارن. برای تصاویر بزرگتر از این ابعاد هم یک راه حل هوشمندانه در نظر گرفته شده. سیستم، تصویر بزرگ رو به تکههای مربعی ۵۱۲ در ۵۱۲ پیکسلی که همپوشانی ندارن تقسیم میکنه و در کنارش، یک تصویر بندانگشتی (thumbnail) از کل تصویر رو هم به مدل میده تا یک درک کلی از صحنه داشته باشه. اینطوری مدل میتونه هم جزئیات دقیق هر تکه از تصویر رو ببینه و هم تصویر کلی و زمینه اصلی رو درک کنه. این قابلیت، توانایی مدل در تحلیل صحنههای پیچیده و بزرگ رو به شدت افزایش میده.

در ادامه یک جدول برای مقایسه ویژگیهای این دو مدل ارائه شده:

| ویژگی | LFM2-VL-450M | LFM2-VL-1.6B |

|---|---|---|

| تعداد پارامترها (فقط مدل زبان) | ۳۵۰ میلیون | ۱.۲ میلیارد |

| انکودر تصویر | SigLIP2 NaFlex نسخه پایه (۸۶ میلیون پارامتر) | SigLIP2 NaFlex بهینهشده برای شکل (۴۰۰ میلیون پارامتر) |

| لایههای اصلی | ترکیبی از کانولوشن و توجه (hybrid conv+attention) | ترکیبی از کانولوشن و توجه (hybrid conv+attention) |

| ظرفیت متن (کانتکست) | ۳۲,۷۶۸ توکن | ۳۲,۷۶۸ توکن |

| توکنهای تصویر | پویا، قابل تنظیم توسط کاربر | پویا، قابل تنظیم توسط کاربر |

| تعداد واژگان (Vocab size) | ۶۵,۵۳۶ | ۶۵,۵۳۶ |

| دقت عددی | bfloat16 | bfloat16 |

| مجوز (لایسنس) | LFM Open License v1.0 | LFM Open License v1.0 |

همونطور که در جدول دیده میشه، مدل ۱.۶ میلیاردی نه تنها پارامترهای بیشتری در بخش زبان داره (۱.۲ میلیارد در مقابل ۳۵۰ میلیون)، بلکه از یک انکودر تصویر بسیار قویتر هم استفاده میکنه (۴۰۰ میلیون پارامتر در مقابل ۸۶ میلیون). این باعث میشه توانایی درک بصری این مدل به مراتب بالاتر باشه. با این حال، هر دو مدل ظرفیت ورودی متن یکسانی دارن و از یک ساختار ترکیبی مشابه برای لایههای پردازشیشون استفاده میکنن.

داستان لیکویید ایآی و نگاهی به گذشته

برای اینکه بهتر بفهمیم LFM2-VL از کجا اومده، باید کمی با خود شرکت لیکویید ایآی آشنا بشیم. این شرکت توسط پژوهشگران سابقی از آزمایشگاه علوم کامپیوتر و هوش مصنوعی دانشگاه امآیتی (CSAIL) تاسیس شد. هدف اصلی این تیم از اول این بود که معماریهای هوش مصنوعی جدیدی بسازن که فراتر از مدل بسیار پرکاربرد «ترنسفورمر» (Transformer) عمل کنن. مدل ترنسفورمر پایهی خیلی از مدلهای بزرگ امروزی مثل جیپیتی هست، اما این تیم باور داشت که میشه راههای بهینهتری پیدا کرد.

نوآوری پرچمدار این شرکت، «مدلهای بنیادی لیکویید» یا Liquid Foundation Models (LFMs) هستن. این مدلها بر اساس اصولی از حوزههای سیستمهای دینامیکی، پردازش سیگنال و جبر خطی عددی ساخته شدن. نتیجهی این ترکیب، مدلهای هوش مصنوعی همهکارهای هست که میتونن دادههای متوالی از انواع مختلف مثل متن، ویدیو، صدا، سریهای زمانی و غیره رو پردازش کنن.

برخلاف معماریهای سنتی، رویکرد «لیکویید» اینه که با استفاده از منابع محاسباتی به مراتب کمتر، عملکردی رقابتی یا حتی بهتر ارائه بده. این مدلها میتونن در حین استنتاج (inference) یا همون زمان استفاده از مدل، به صورت لحظهای خودشون رو تطبیق بدن و در عین حال حافظه کمی مصرف کنن. این ویژگیها باعث شده که مدلهای LFM هم برای کاربردهای سازمانی در مقیاس بزرگ و هم برای پیادهسازی روی دستگاههای لبه که منابع محدودی دارن، خیلی مناسب باشن.

این شرکت در جولای ۲۰۲۵ (توجه: این تاریخ در متن منبع ذکر شده)، استراتژی پلتفرم خودش رو با عرضه پلتفرم هوش مصنوعی لبه لیکویید (Liquid Edge AI Platform) یا به اختصار LEAP، گسترش داد. LEAP یک کیت توسعه نرمافزار (SDK) چندپلتفرمیه که برای توسعهدهندهها طراحی شده تا بتونن مدلهای زبان کوچیک (SLM) رو راحتتر و به طور مستقیم روی دستگاههای موبایل و تعبیهشده (embedded) اجرا کنن.

LEAP از سیستمعاملهای iOS و اندروید بدون وابستگی به یکی از اونها پشتیبانی میکنه. این پلتفرم هم با مدلهای خود لیکویید ایآی و هم با مدلهای زبان کوچیک متنباز دیگه سازگاره. همچنین یک کتابخونه داخلی داره که مدلهایی با حجم تنها ۳۰۰ مگابایت رو شامل میشه؛ این حجم به اندازهای کوچیکه که برای گوشیهای مدرن با حداقل رم هم مناسبه. اپلیکیشن همراه این پلتفرم به اسم آپولو (Apollo)، به توسعهدهندهها اجازه میده مدلها رو به صورت کاملا آفلاین تست کنن. این موضوع با تاکید لیکویید ایآی بر هوش مصنوعی حافظ حریم خصوصی و با تاخیر کم، کاملا هماهنگه. در مجموع، LEAP و آپولو نشوندهنده تعهد این شرکت به غیرمتمرکز کردن اجرای هوش مصنوعی، کاهش وابستگی به زیرساختهای ابری و توانمندسازی توسعهدهندهها برای ساختن مدلهای بهینه و مخصوص برای کارهای مشخص در محیطهای واقعی هستن.

معماری فنی و جزئیات طراحی LFM2-VL

حالا بیایم عمیقتر به ساختار فنی LFM2-VL نگاه کنیم و ببینیم این مدل دقیقا چطور کار میکنه. LFM2-VL از یک معماری ماژولار استفاده میکنه که از سه بخش اصلی تشکیل شده: یک ستون فقرات مدل زبان، یک انکودر تصویر، و یک پروژکتور چندوجهی.

- ستون فقرات مدل زبان (Language Model Backbone):

این بخش، هستهی پردازش متن مدله. LFM2-VL بر پایه ستون فقرات مدلهای قبلی LFM2 ساخته شده. برای نسخه LFM2-VL-1.6B، از ستون فقرات مدل LFM2-1.2B استفاده شده و برای نسخه کوچیکتر یعنی LFM2-VL-450M، از ستون فقرات مدل LFM2-350M بهره گرفته شده. این یعنی مدلهای جدید، قابلیتهای زبانی خودشون رو از نسل قبلی به ارث بردن. - برج تصویر (Vision Tower):

این قسمت مسئول درک و پردازش تصاویره. LFM2-VL از انکودرهای SigLIP2 NaFlex برای تبدیل تصاویر ورودی به دنبالهای از توکنها استفاده میکنه. توکنها در واقع واحدهای اطلاعاتیای هستن که مدل میتونه اونها رو بفهمه. دو نوع از این انکودرها پیادهسازی شده:- یک نسخه بهینهشده برای شکل (Shape-optimized) با ۴۰۰ میلیون پارامتر که برای مدل بزرگتر یعنی LFM2-VL-1.6B استفاده میشه. این انکودر قابلیتهای بصری دقیقتری رو فراهم میکنه.

- یک نسخه پایه (Base) با ۸۶ میلیون پارامتر که برای مدل کوچکتر یعنی LFM2-VL-450M به کار میره و برای پردازش سریع تصاویر طراحی شده.

این انکودرها، همونطور که قبلا گفته شد، تصاویر رو با رزولوشن اصلیشون تا ابعاد ۵۱۲ در ۵۱۲ پیکسل پردازش میکنن. این کار باعث میشه تصاویر کوچیک بدون نیاز به بزرگنمایی و تصاویر با نسبت ابعاد غیر استاندارد بدون تغییر شکل و اعوجاج پردازش بشن. برای تصاویر بزرگتر، استراتژی کاشیکاری (Tiling) به کار میره. یعنی تصویر به تکههای مربعی غیرهمپوشان ۵۱۲ در ۵۱۲ تقسیم میشه تا جزئیات حفظ بشن. در مدل LFM2-VL-1.6B، یک قابلیت اضافه هم وجود داره: مدل علاوه بر این تکهها، یک تصویر بندانگشتی (thumbnail) هم دریافت میکنه. این تصویر بندانگشتی، یک نسخه کوچیک و کمحجم از کل تصویره که به مدل کمک میکنه یک درک کلی از صحنه و زمینه داشته باشه و ارتباط بین تکههای مختلف رو بهتر بفهمه. توکنهای ویژهای هم برای مشخص کردن موقعیت هر تکه و نشان دادن شروع تصویر بندانگشتی استفاده میشن.

- پروژکتور چندوجهی (Multimodal Projector):

این بخش مثل یک پل بین دنیای تصویر و دنیای متن عمل میکنه. کارش اینه که توکنهای تولید شده توسط انکودر تصویر رو به فرمتی تبدیل کنه که مدل زبان بتونه اونها رو بفهمه. برای این کار، یک اتصالدهنده MLP دو لایه (یک نوع شبکه عصبی ساده) به همراه تکنیک pixel unshuffle پیادهسازی شده. این تکنیک کمک میکنه تعداد توکنهای تصویر کاهش پیدا کنه و در نتیجه سرعت پردازش (throughput) بدون افت کیفیت زیاد، بالا بره.

برای مثال، یک تصویر با ابعاد ۲۵۶ در ۳۸۴ پیکسل، فقط ۹۶ توکن تصویری تولید میکنه. یک تصویر ۳۸۴ در ۶۸۰ پیکسلی، ۲۴۰ توکن تولید میکنه و یک تصویر بزرگ ۱۰۰۰ در ۳۰۰۰ پیکسلی، ۱۰۲۰ توکن. این اعداد نشون میدن که سیستم چقدر بهینه عمل میکنه.

انعطافپذیری در زمان اجرا

یکی از نکات برجسته این معماری، انعطافپذیری اونه. این معماری به کاربرها اجازه میده تا بدون نیاز به آموزش مجدد مدل، تعادل بین سرعت و کیفیت رو در زمان استنتاج (inference) تنظیم کنن. دو پارامتر اصلی قابل تنظیم هستن:

- حداکثر تعداد توکنهای تصویر: این پارامتر به طور موثر رزولوشن ورودی رو کنترل میکنه. با کم کردن این عدد، سرعت بالاتر میره ولی ممکنه مقداری از جزئیات از دست بره.

- تعداد تکههای تصویر: برای تصاویر بزرگ، کاربر میتونه مشخص کنه که چند تکه از تصویر برای تحلیل استفاده بشه.

این قابلیت تنظیم، بهینهسازی عملکرد رو برای کاربردهای خاص و نیازمندیهای مختلف از نظر تاخیر (latency) ممکن میسازه. مثلا برای یک کاربرد زنده که سرعت حرف اول رو میزنه، میشه تنظیمات رو روی حالت سریعتر قرار داد و برای یک تحلیل آفلاین که دقت اهمیت بیشتری داره، میشه کیفیت رو در اولویت گذاشت.

فرآیند آموزش: LFM2-VL چطور یاد گرفت؟

ساختن یک مدل هوش مصنوعی قدرتمند، نیازمند یک فرآیند آموزش دقیق و هوشمندانه است. LFM2-VL هم از این قاعده مستثنی نیست و مراحل مختلفی رو برای رسیدن به تواناییهای فعلیش طی کرده.

فرآیند آموزش با مدل پایه LFM2 شروع میشه. بعد از اون، قابلیتهای بصری و زبانی در یک فاز «آموزش میانی مشترک» (joint mid-training) با هم ترکیب و ادغام میشن. در این مرحله، نسبت دادههای متنی به تصویری به تدریج تغییر میکنه. در ابتدا ۹۵ درصد دادهها متنی هستن و فقط ۵ درصد تصویری، و این نسبت به مرور زمان به ۳۰ درصد داده تصویری میرسه. این کار به مدل اجازه میده که به آرامی قابلیتهای بصری رو یاد بگیره و اونها رو با درک زبانی خودش ترکیب کنه.

بعد از این مرحله، یک فاز «تنظیم دقیق نظارتشده مشترک» (joint supervised fine-tuning) یا SFT انجام میشه که تاکید اصلی در اون روی درک تصویره. در این مرحله، مدل روی مجموعهای از وظایف و دادههای مشخص آموزش داده میشه تا در کارهایی مثل پاسخ به سوالات در مورد تصاویر یا دنبال کردن دستورالعملهای چندوجهی، بهتر عمل کنه.

دادههای آموزشی که برای بخش بصری استفاده شدن، ترکیبی از مجموعه دادههای متنباز در مقیاس بزرگ و دادههای بصری سنتتیک (ساختگی) تولید شده در خود شرکت هستن. این دادهها با دقت انتخاب شدن تا پوشش متعادلی از وظایف مختلف رو فراهم کنن. در مجموع، LFM2-VL روی حجمی در حدود ۱۰۰ میلیارد توکن چندوجهی آموزش دیده. این حجم عظیم از دادههای متنی و تصویری به مدل کمک کرده تا به درک عمیقی از ارتباط بین کلمات و تصاویر برسه.

به طور خلاصه، استراتژی آموزش رو میشه به سه مرحله تقسیم کرد:

- مدل پایه: استفاده از مدل LFM2 که از قبل آموزش دیده.

- آموزش میانی مشترک: ادغام قابلیتهای بصری با تغییر تدریجی نسبت دادههای تصویری.

- تنظیم دقیق نظارتشده: تمرکز روی وظایف درک تصویر و دنبال کردن دستورالعمل.

این رویکرد آموزشی پیشرونده، یکی از دلایل اصلی عملکرد خوب این مدلهاست.

عملکرد در عمل: سرعت و دقت مدل

خب، همه این جزئیات فنی و فرآیندهای آموزشی پیچیده در نهایت باید به یک نتیجه ملموس برسن: عملکرد مدل در دنیای واقعی چطوره؟ لیکویید ایآی هم مدلهاش رو روی بنچمارکهای عمومی مختلف ارزیابی کرده و هم سرعتش رو با رقبا مقایسه کرده.

نتایج بنچمارکها

مدلهای LFM2-VL در مجموعهای از ارزیابیهای زبان-تصویر، نتایج رقابتیای رو به دست آوردن. این مدلها به خصوص در درک تصاویر با رزولوشن بالا و دنبال کردن دستورالعملهای چندوجهی عملکرد خیلی خوبی از خودشون نشون دادن و در بقیه وظایف هم عملکرد قوی خودشون رو حفظ کردن.

در اینجا جداول مقایسه عملکرد LFM2-VL با مدلهای رقیب در بنچمارکهای مختلف آورده شده. این بنچمارکها جنبههای مختلفی از توانایی یک مدل چندوجهی رو میسنجن، از جمله درک دنیای واقعی (RealWorldQA)، پاسخ به سوالات بر اساس اطلاعات بصری (InfoVQA)، خواندن متن از روی تصویر (OCRBench)، و استدلال چندوجهی (MMMU).

مقایسه مدلهای بزرگتر (کلاس حدود ۱ تا ۲ میلیارد پارامتر):

| مدل | RealWorldQA | MM-IFEval | InfoVQA (Val) | OCRBench | BLINK | MMStar | MMMU (Val) | MathVista | SEEDBench_IMG | MMVet | MME | MMLU |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| InternVL3-2B | ۶۵.۱۰ | ۳۸.۴۹ | ۶۶.۱۰ | ۸۳۱ | ۵۳.۱۰ | ۶۱.۱۰ | ۴۸.۷۰ | ۵۷.۶۰ | ۷۵.۰۰ | ۶۷.۰۰ | ۲۱۸۶.۴۰ | ۶۴.۸۰ |

| InternVL3-1B | ۵۷.۰۰ | ۳۱.۱۴ | ۵۴.۹۴ | ۷۹۸ | ۴۳.۰۰ | ۵۲.۳۰ | ۴۳.۲۰ | ۴۶.۹۰ | ۷۱.۲۰ | ۵۸.۷۰ | ۱۹۱۲.۴۰ | ۴۹.۸۰ |

| SmolVLM2-2.2B | ۵۷.۵۰ | ۱۹.۴۲ | ۳۷.۷۵ | ۷۲۵ | ۴۲.۳۰ | ۴۶.۰۰ | ۴۱.۶۰ | ۵۱.۵۰ | ۷۱.۳۰ | ۳۴.۹۰ | ۱۷۹۲.۵۰ | – |

| LFM2-VL-1.6B | ۶۵.۲۳ | ۳۷.۶۶ | ۵۸.۶۸ | ۷۴۲ | ۴۴.۴۰ | ۴۹.۵۳ | ۳۸.۴۴ | ۵۱.۱۰ | ۷۱.۹۷ | ۴۸.۰۷ | ۱۷۵۳.۰۴ | ۵۰.۹۹ |

همونطور که میبینید، مدل LFM2-VL-1.6B در بنچمارک RealWorldQA حتی از مدل بزرگتر InternVL3-2B هم نمره بهتری گرفته (۶۵.۲۳ در مقابل ۶۵.۱) و در خیلی از بنچمارکهای دیگه هم عملکردی نزدیک به رقبا یا بهتر از اونها داشته.

مقایسه مدلهای کوچکتر (کلاس حدود نیم میلیارد پارامتر):

| مدل | RealWorldQA | MM-IFEval | InfoVQA (Val) | OCRBench | BLINK | MMStar | MMMU (Val) | MathVista | SEEDBench_IMG | MMVet | MME | MMLU |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| SmolVLM2-500M | ۴۹.۹۰ | ۱۱.۲۷ | ۲۴.۶۴ | ۶۰۹ | ۴۰.۷۰ | ۳۸.۲۰ | ۳۴.۱۰ | ۳۷.۵۰ | ۶۲.۲۰ | ۲۹.۹۰ | ۱۴۴۸.۳۰ | – |

| LFM2-VL-450M | ۵۲.۲۹ | ۲۶.۱۸ | ۴۶.۵۱ | ۶۵۵ | ۴۱.۹۸ | ۴۰.۸۷ | ۳۳.۱۱ | ۴۴.۷۰ | ۶۳.۵۰ | ۳۳.۷۶ | ۱۲۳۹.۰۶ | ۴۰.۱۶ |

در این دسته هم، مدل LFM2-VL-450M در اکثر بنچمارکها به طور قابل توجهی از رقیب اصلیش یعنی SmolVLM2-500M بهتر عمل کرده. این نتایج نشون میده که تمرکز لیکویید ایآی روی بهینگی، باعث فدا شدن دقت نشده.

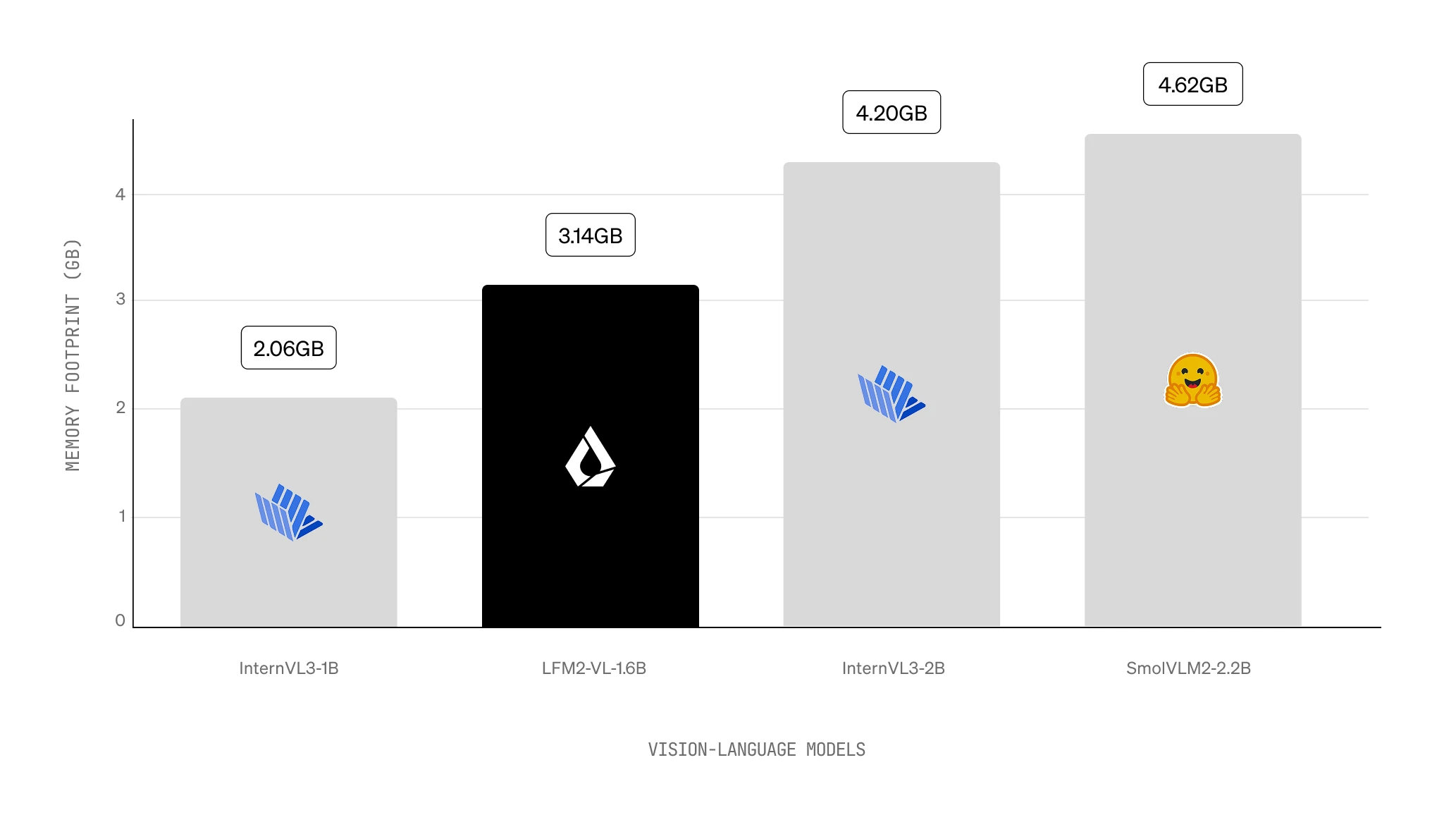

سرعت استنتاج (Inference Speed)

اما نقطه قوت اصلی این مدلها، سرعته. مدلهای LFM2-VL در سرعت استنتاج برتری دارن و سریعترین عملکرد رو در بین تمام رقبا روی GPU به دست آوردن. برای ارزیابی این موضوع، یک تست استاندارد انجام شده: یک تصویر با ابعاد ۱۰۲۴ در ۱۰۲۴ پیکسل به همراه یک پرامپت (دستور) کوتاه مثل «این تصویر رو با جزئیات توصیف کن» به مدل داده شده و از مدل خواسته شده تا ۱۰۰ توکن خروجی تولید کنه. این تست با تنظیمات پیشفرض هر مدل انجام شده. در این شرایط، LFM2-VL تا دو برابر سریعتر از سریعترین مدل قابل مقایسه عمل کرده، در حالی که دقت رقابتی خودش رو هم حفظ کرده.

این سرعت بالا به لطف معماری خاص این مدلها، به خصوص رویکرد تولید وزنهای لحظهای (LIV) و پروژکتور بهینه برای کاهش توکنهای تصویری به دست اومده. این ویژگی، LFM2-VL رو برای کاربردهای لحظهای و real-time مثل واقعیت افزوده یا تحلیل آنی تصاویر در گوشیهای هوشمند، به یک گزینه ایدهآل تبدیل میکنه.

استفاده از مدل برای توسعهدهندهها

لیکویید ایآی تلاش کرده تا استفاده از این مدلهای جدید رو برای جامعه توسعهدهندهها تا حد ممکن ساده کنه.

دسترسی و مجوز استفاده

مدلهای LFM2-VL در حال حاضر روی پلتفرم محبوب Hugging Face در دسترس هستن. همراه با مدلها، کدهای نمونه برای تنظیم دقیق (fine-tuning) در محیط Colab هم ارائه شده. این مدلها با کتابخانههای معروف Hugging Face transformers و TRL هم سازگار هستن.

این مدلها تحت یک مجوز متنباز به اسم «LFM Open License v1.0» منتشر شدن. لیکویید ایآی اعلام کرده که این مجوز بر اساس اصول مجوز معروف Apache 2.0 نوشته شده. بر اساس این مجوز، شما میتونید آزادانه از مدلهای LFM2-VL برای اهداف آکادمیک و تحقیقاتی استفاده کنید. استفاده تجاری هم برای شرکتهای کوچیک (با درآمد سالانه زیر ۱۰ میلیون دلار) مجازه. شرکتهایی که درآمدی بالاتر از این مقدار دارن، برای استفاده تجاری باید با تیم فروش لیکویید ایآی از طریق ایمیل `[email protected]` تماس بگیرن و مجوز تجاری دریافت کنن. با اینکه جزئیات کامل متن مجوز هنوز منتشر نشده، این رویکرد باز، در راستای روند کلی دسترسی آزاد به هوش مصنوعی قرار داره و به مهندسها و توسعهدهندهها اجازه میده تا این مدل رو برای دستگاههای لبه مختلف، یکپارچهسازی و سفارشیسازی کنن.

چطور با مدل کار کنیم؟

از اونجایی که این مدلها برای عملکرد بهینه روی دستگاه طراحی شدن، توصیه شده که اونها رو به صورت خصوصی و محلی روی دستگاه خودتون تست کنید. LFM2-VL از یک الگوی چت شبیه به ChatML استفاده میکنه. این الگو ساختار یک مکالمه رو برای مدل مشخص میکنه:

<|startoftext|><|im_start|>system

You are a helpful multimodal assistant by Liquid AI.<|im_end|>

<|im_start|>user

<image>Describe this image.<|im_end|>

<|im_start|>assistant

This image shows a Caenorhabditis elegans (C. elegans) nematode.<|im_end|>در این الگو، بخش `system` شخصیت و وظیفه مدل رو مشخص میکنه. بخش `user` پیام کاربر رو شامل میشه و بخش `assistant` جاییه که مدل جواب خودش رو قرار میده. تصاویر با یک نشانگر خاص یعنی `<image>` مشخص میشن که پردازشگر به طور خودکار اون رو با توکنهای تصویری جایگزین میکنه. برای استفاده از این الگو میشه از تابع `.apply_chat_template()` در کتابخانه Hugging Face transformers استفاده کرد.

برای اجرای مدل در پایتون با استفاده از کتابخانه `transformers` (نسخه ۴.۵۵ یا جدیدتر)، میتونید از کد نمونه زیر استفاده کنید:

# اول باید کتابخانههای لازم رو نصب کنید

# pip install -U transformers pillow

from transformers import AutoProcessor, AutoModelForImageTextToText

from transformers.image_utils import load_image

# مدل و پردازشگر رو بارگذاری کنید

model_id = "LiquidAI/LFM2-VL-1.6B"

model = AutoModelForImageTextToText.from_pretrained(

model_id,

device_map="auto",

torch_dtype="bfloat16",

trust_remote_code=True

)

processor = AutoProcessor.from_pretrained(model_id, trust_remote_code=True)

# تصویر رو بارگذاری کنید و مکالمه رو بسازید

url = "https://www.ilankelman.org/stopsigns/australia.jpg"

image = load_image(url)

conversation = [

{

"role": "user",

"content": [

{"type": "image", "image": image},

{"type": "text", "text": "What is in this image?"},

],

},

]

# جواب رو تولید کنید

inputs = processor.apply_chat_template(

conversation,

add_generation_prompt=True,

return_tensors="pt",

return_dict=True,

tokenize=True,

).to(model.device)

outputs = model.generate(**inputs, max_new_tokens=64)

# خروجی رو نمایش بدید

processor.batch_decode(outputs, skip_special_tokens=True)[0]

# جواب مدل:

# This image depicts a vibrant street scene in what appears to be a Chinatown or

# similar cultural area. The focal point is a large red stop sign with white

# lettering, mounted on a pole.همچنین یک نوتبوک Colab برای تست و اجرای مستقیم مدل و یک نوتبوک دیگه برای آموزش تنظیم دقیق نظارتشده (SFT) با استفاده از TRL و LoRA در اختیار توسعهدهندهها قرار گرفته. از اونجایی که این مدلها اندازهی کوچیکی دارن، توصیه میشه که برای به دست آوردن حداکثر عملکرد، اونها رو روی کاربردهای خاص و محدود خودتون تنظیم دقیق (fine-tune) کنید. این مدلها برای دنبال کردن دستورالعمل و جریانهای کاری سبک مبتنی بر عامل (agentic flows) آموزش دیدن و برای تصمیمگیریهای حیاتی از نظر ایمنی در نظر گرفته نشدن.

تاثیرات بر صنعت گوشیهای هوشمند و آینده

عرضه LFM2-VL میتونه تاثیر عمیقی روی صنعت گوشیهای هوشمند و به طور کلی دستگاههای مصرفی داشته باشه. تصور کنید دستگاهی داشته باشید که میتونه فورا عکسها رو توصیف کنه، با استفاده از نشانههای بصری در محیط به شما در مسیریابی کمک کنه، یا در ترجمه زنده به شما یاری برسونه؛ و همه این کارها به صورت محلی و بدون نیاز به اینترنت انجام بشه. این قابلیتها شبیه پیشرفتهایی هست که در مدلهایی مثل Eagle 2 انویدیا دیده شده، اما تمرکز LFM2-VL روی فشردگی و حجم کم، اون رو به عنوان یک پیشتاز برای یکپارچهسازی با موبایل مطرح میکنه. مدلهایی مثل این، یک تعادل بهینه بین کیفیت، تاخیر و هزینه برقرار میکنن و میتونن موانع ورود هوش مصنوعی به لوازم الکترونیکی مصرفی رو کاهش بدن.

برای بازیگران بزرگ این صنعت مثل اپل و گوگل که در حال حاضر هم هوش مصنوعی رو در اکوسیستمهای خودشون تعبیه کردن، LFM2-VL هم یک فرصت و هم یک رقیب به حساب میاد. این مدل میتونه تغییر به سمت هوش مصنوعی لبه رو تسریع کنه، وابستگی به دیتاسنترها رو کاهش بده و هزینههای انرژی رو کم کنه.

با این همه هیجان، چالشهایی هم وجود داره. اطمینان از استحکام و پایداری مدل روی سختافزارهای متنوع و کاهش سوگیریها (biases) در وظایف بصری، از نگرانیهای مداوم در این حوزه هستن. با این حال، تحقیقات لیکویید ایآی روی معماریهای ترکیبی نشوندهنده تعهد این شرکت به بهبودهای مداوم و تکرارشونده است.

نگاه به آینده نشون میده که این عرضه میتونه موج جدیدی از دستگاههای «ذاتا هوشمند» (AI-native) رو به راه بندازه. با قرار دادن «بهینگی» به عنوان محصول اصلی، همونطور که مدیرعامل لیکویید ایآی گفته، این شرکت در موقعیتی قرار گرفته که میتونه روی همه چیز، از وسایل نقلیه خودران گرفته تا سیستمهای خانه هوشمند، تاثیر بذاره. در حالی که این حوزه به تکامل خودش ادامه میده، LFM2-VL به عنوان یک قدم محوری به سوی محاسبات هوشمند و فراگیر در همه جا، برجسته میشه. هدف نهایی اینه که هوش مصنوعی با عملکرد بالا و چندوجهی، برای پیادهسازی روی دستگاههای شخصی و محیطهای با منابع محدود، بدون فدا کردن قابلیتها، در دسترستر بشه.

دیدگاهتان را بنویسید