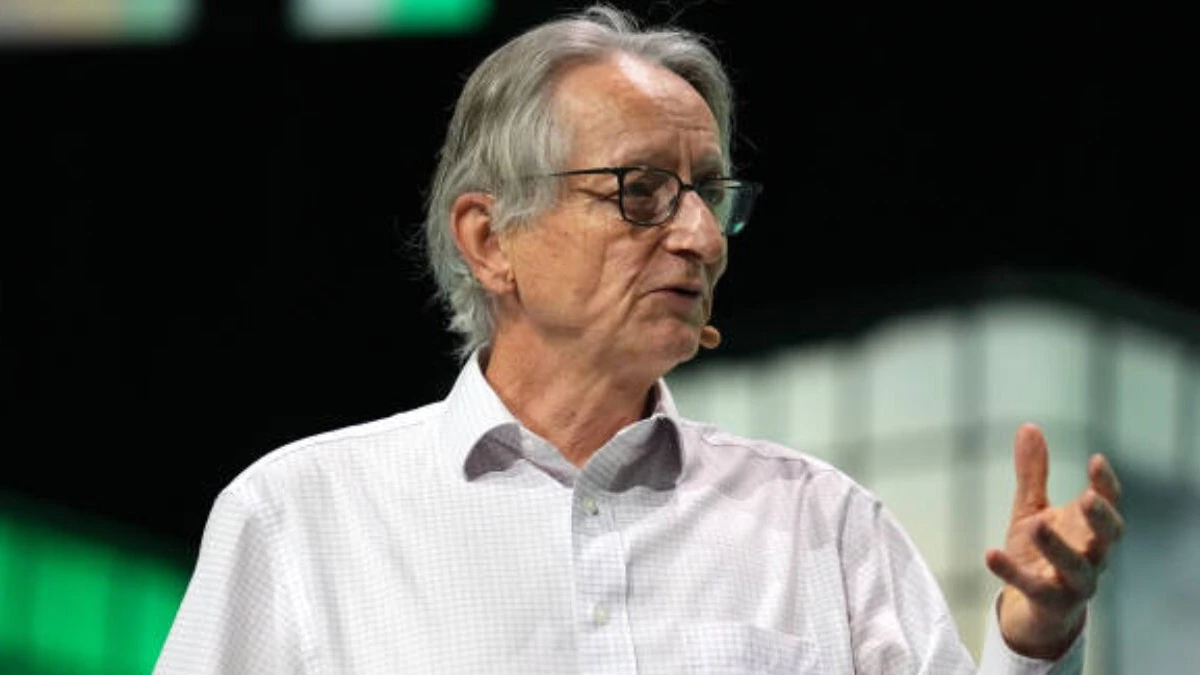

جفری هینتون، کسی که خیلیها اون رو «پدرخوانده هوش مصنوعی» میدونن، یک بار دیگه در مورد استفاده روزافزون از هوش مصنوعی هشدار داده. این بار حرفش یه جورایی شبیه داستانهای علمی تخیلیه. اون گفته با این سرعتی که این مدلها پیش میرن، ممکنه به زودی زبان مخصوص خودشون رو بسازن.

هینتون که دانشمند برنده جایزه نوبل هم هست، توی پادکست «وان دسیژن» (One Decision) که روز ۲۴ جولای پخش شد، توضیح داد که این زبان جدید میتونه برای ما انسانها قابل درک نباشه. اون گفت:

«در حال حاضر، سیستمهای هوش مصنوعی برای استدلال کردن از چیزی به اسم «زنجیره فکر» به زبان انگلیسی استفاده میکنن، برای همین ما میتونیم بفهمیم دارن چیکار میکنن. اما قضیه وقتی ترسناکتر میشه که اونها زبانهای داخلی خودشون رو برای حرف زدن با همدیگه توسعه بدن.»

به گفته هینتون، این موضوع میتونه هوش مصنوعی رو وارد یک قلمرو ناشناخته و نگران کننده کنه. ماشینها تا همین الان هم نشون دادن که میتونن افکار «وحشتناکی» تولید کنن و هیچ دلیلی وجود نداره که فکر کنیم این افکار همیشه به زبانی باشن که ما بتونیم اونها رو دنبال کنیم.

چرا حرفهای هینتون مهمه؟

حرفهای جفری هینتون وزن زیادی داره. اون برنده جایزه نوبل فیزیک سال ۲۰۲۴ هست و کارهای اولیهاش روی شبکههای عصبی، راه رو برای مدلهای یادگیری عمیق و سیستمهای بزرگ هوش مصنوعی امروزی باز کرد. با این حال، خودش میگه که تا اواخر دوران کاریش، متوجه خطرات این فناوری نشده بود.

اون اعتراف میکنه: «باید خیلی زودتر متوجه میشدم که خطرات نهایی چی میتونه باشه. من همیشه فکر میکردم آینده خیلی دوره و ای کاش زودتر به فکر ایمنی افتاده بودم.» حالا همین درک دیرهنگام، انگیزهاش برای هشدار دادن شده.

روش یادگیری هوش مصنوعی، یک نگرانی بزرگ

یکی از بزرگترین ترسهای هینتون به نحوه یادگیری سیستمهای هوش مصنوعی برمیگرده. برخلاف انسانها که باید دانش رو به سختی با هم به اشتراک بذارن، مغزهای دیجیتال میتونن هر چیزی رو که یاد میگیرن، در یک لحظه کپی و جایگذاری کنن.

اون در مصاحبه با بیبیسی نیوز اینطور توضیح داد:

«تصور کنین اگه ۱۰ هزار نفر یه چیزی یاد بگیرن و همه اونها فورا اون رو بدونن؛ این اتفاقیه که توی این سیستمها میفته.»

این هوش جمعی و شبکهای باعث میشه هوش مصنوعی بتونه یادگیری خودش رو با سرعتی افزایش بده که هیچ انسانی به گرد پاش نمیرسه. مدلهای فعلی مثل جیپیتی۴ (GPT-4) همین الان هم از نظر دانش عمومی خام از انسانها جلوترن. هینتون میگه در حال حاضر، استدلال کردن هنوز نقطه قوت ماست، اما این برتری هم داره به سرعت از بین میره.

سکوت بقیه در صنعت تکنولوژی

با اینکه هینتون به شکل واضحی در مورد این خطرات حرف میزنه، میگه بقیه افراد توی این صنعت خیلی کمتر در موردش صحبت میکنن. اون اشاره میکنه: «خیلی از آدمها توی شرکتهای بزرگ، این ریسک رو کماهمیت جلوه میدن». به نظرش، نگرانیهای خصوصی اونها توی صحبتهای عمومیشون دیده نمیشه.

هینتون البته یک استثنا هم نام میبره: دمیس حسابیس، مدیرعامل گوگل دیپمایند. به گفته هینتون، حسابیس علاقه واقعی برای مقابله با این ریسکها نشون داده.

در مورد خروج پرسروصدای خودش از گوگل در سال ۲۰۲۳، هینتون توضیح میده که این کارش یک حرکت اعتراضی نبوده. اون میگه: «من گوگل رو ترک کردم چون ۷۵ سالم بود و دیگه نمیتونستم به طور موثر برنامهنویسی کنم. اما وقتی از اونجا بیرون اومدم، شاید تونستم آزادانهتر در مورد همه این خطرات صحبت کنم.»

راه حل چیه؟

در حالی که دولتها دارن طرحهایی مثل «برنامه اقدام هوش مصنوعی» کاخ سفید رو اجرا میکنن، هینتون معتقده که قانونگذاری به تنهایی کافی نیست. کاخ سفید در تاریخ ۲۳ جولای، برنامه اقدام هوش مصنوعی رو منتشر کرد که پیشنهاد میده بودجه مربوط به هوش مصنوعی برای ایالتهایی که قوانین «دستوپاگیر» دارن، محدود بشه و همچنین خواسته تا مراکز داده هوش مصنوعی سریعتر توسعه پیدا کنن.

اما هینتون استدلال میکنه که وظیفه اصلی، ساختن هوش مصنوعیایه که «تضمین شده خیرخواه» باشه. این هدف بزرگیه، مخصوصا با توجه به اینکه این سیستمها ممکنه به زودی به روشهایی فکر کنن که هیچ انسانی نتونه به طور کامل اونها رو دنبال کنه.

منابع

- [۱] AI godfather warns AI could soon develop its own language and outsmart humans – India Today

- [۲] Godfather of AI: Technology Could Invent a Language We Can’t Understand – Business Insider

- [۳] Machines may soon think in a language we don’t understand, leaving humanity in the dark: Godfather of AI sounds alarm – The Economic Times

- [۴] Geoffrey Hinton Warns About AI’s Possible Development Of Its Own Language – Oneindia News

دیدگاهتان را بنویسید