مدت زمان مطالعه: حدود ۱۵ دقیقه

اهداف:

- فهمیدن اینکه چطور یک هوش مصنوعی میتونه فقط با دیدن، کنترل رباتها رو یاد بگیره.

- آشنایی با سیستمی به اسم «میدانهای ژاکوبین عصبی» یا NJF.

- دیدن کاربردهای این تکنولوژی روی رباتهای واقعی و مختلف.

فصل اول: یک ایده جدید، رباتهایی که خودشان یاد میگیرند

تصور کن یک ربات نرم و انعطافپذیر توی آزمایشگاه علوم کامپیوتر و هوش مصنوعی امآیتی (CSAIL) نشسته و داره با دقت انگشتهاش رو خم میکنه تا یک جسم کوچیک رو برداره. نکته جالب این نیست که این ربات چقدر طراحی مکانیکی پیشرفتهای داره یا پر از سنسورهای مختلفه؛ در واقع، هیچ سنسور خاصی روی خودش نداره. کل این سیستم به یک دوربین تکیه کرده که حرکات ربات رو تماشا میکنه و از همین دادههای تصویری برای کنترل کردنش استفاده میکنه.

دانشمندان موسسه فناوری ماساچوست (MIT) یک سیستم هوش مصنوعی جدید توسعه دادن که میتونه به خودش یاد بده چطور انواع مختلف رباتها رو فقط با استفاده از یک دوربین کنترل کنه. این سیستم، که توسط محققان آزمایشگاه CSAIL ساخته شده، به رباتها اجازه میده تا حرکت و کنترل بدن خودشون رو فقط با استفاده از دادههای تصویری یاد بگیرن. این روش دیگه نیازی به سنسورهای پیچیده یا برنامهریزیهای دقیق و جزئی نداره و به ربات اجازه میده از طریق مشاهده یاد بگیره.

بر اساس گزارشی که در «Live Science» منتشر شده، این هوش مصنوعی اطلاعات مربوط به ساختار ربات رو با استفاده از دوربینها جمعآوری میکنه، تقریبا شبیه به روشی که انسانها از چشمهاشون برای درک نحوه حرکت بدن خودشون استفاده میکنن. این متد یک راه کاملا جدید برای آموزش رباتها به حساب میاد. به جای استفاده از مدلهای فیزیکی دقیق یا سنسورهای پیچیده، هوش مصنوعی یاد میگیره که یک ربات به دستورات چطور پاسخ میده، اون هم فقط با تماشای نحوه حرکتش.

این دستاورد در واقع یک پارادایم کنترلی جدید رو معرفی میکنه. هوش مصنوعی یک مدل خودآموز برای کار با هر رباتی ایجاد میکنه و در اصل به ماشینها یک حس خودآگاهی فیزیکی شبیه به انسان میده. این یعنی جدا کردن طراحی سختافزار ربات از توانایی ما برای مدلسازی دستی اون. در گذشته، طراحی رباتها تحت تاثیر توانایی ما در مدلسازی دقیق بود که به تولید دقیق، مواد گرانقیمت، سنسورهای زیاد و تکیه بر قطعات سفت و سخت معمولی منجر میشد. حالا این محدودیت برداشته شده و طراحان آزادی بیشتری برای کشف ساختارهای غیرمتعارف و بدون محدودیت دارن، بدون اینکه نگران باشن بعدا میتونن اون رو مدلسازی یا کنترل کنن یا نه.

فصل دوم: راز ماجرا چیه؟ آشنایی با میدانهای ژاکوبین عصبی (NJF)

کلید اصلی این تکنولوژی، سیستمیه که توسط CSAIL توسعه داده شده و بهش میگن «میدانهای ژاکوبین عصبی» یا (Neural Jacobian Fields – NJF). این سیستم یک مدل بصری از حرکات ربات میسازه. بذار سادهتر بگم، یک نقشه درست میکنه که نشون میده چطور نقاط سهبعدی قابل مشاهده روی ربات به موتورهای داخلیش ربط دارن.

سایژه لستر لی (Sizhe Lester Li)، دانشجوی دکتری در امآیتی و محقق اصلی این پروژه، در یک بیانیه مطبوعاتی میگه: «این سیستم به رباتها نوعی آگاهی از بدن خودشون رو میده. این کار به یک تغییر جهت از برنامهنویسی رباتها به سمت آموزش دادن به رباتها اشاره داره. امروز، خیلی از وظایف رباتیک به مهندسی زیادی احتیاج دارن. در آینده، ما میتونیم فقط یک وظیفه رو به ربات نشون بدیم و اجازه بدیم خودش یاد بگیره چطور اون رو انجام بده».

اون اضافه میکنه: «فکر کن چطور یاد میگیری انگشتهات رو کنترل کنی: اونها رو تکون میدی، مشاهده میکنی، و خودت رو تطبیق میدی. این دقیقا کاریه که سیستم ما انجام میده. اون با اقدامات تصادفی آزمایش میکنه و کشف میکنه که کدوم کنترلها کدوم بخش از ربات رو حرکت میدن».

این سیستم روی دو جنبه درهمتنیده از بدن ربات تمرکز میکنه: هندسه سهبعدی و حساسیتش به ورودیهای کنترلی. این تکنولوژی بر اساس میدانهای تابش عصبی (NeRF) ساخته شده، که یک تکنیک برای بازسازی صحنههای سهبعدی از روی تصاویره. NJF این رویکرد رو یک قدم جلوتر میبره و نه تنها شکل ربات رو یاد میگیره، بلکه یک «میدان ژاکوبین» هم یاد میگیره؛ یعنی یک تابع که پیشبینی میکنه هر نقطه از بدن ربات در پاسخ به دستورات موتور چطور حرکت میکنه.

جالبی ماجرا اینجاست که سیستم خودش کشف میکنه کدوم موتورها کدوم قسمتهای ربات رو کنترل میکنن. این موضوع از قبل برنامهریزی نشده و به طور طبیعی از طریق یادگیری به وجود میاد، خیلی شبیه به انسانی که دکمههای یک دستگاه جدید رو کشف میکنه.

این ایده از درک انسان الهام گرفته شده. آدمها وقتی با یک کنترلر بازی ویدیویی رباتها رو کنترل میکنن، میتونن در عرض چند دقیقه برداشتن و گذاشتن اشیا رو یاد بگیرن. تنها سنسوری که ما لازم داریم چشمهامونه. ما فقط از طریق دیدن میتونیم ساختار سهبعدی ربات رو بازسازی کنیم و حرکتش رو به عنوان تابعی از ورودیهای کنترلی که تولید میکنیم، پیشبینی کنیم.

فصل سوم: ربات چطور آموزش میبینه؟ یک فرآیند خودآموز

فرآیند آموزش این مدل کاملا خودکاره و نیازی به دخالت انسان یا دانش قبلی در مورد طراحی ربات نداره.

- انجام حرکات تصادفی: برای آموزش مدل، ربات شروع به انجام حرکات تصادفی میکنه.

- ضبط با چندین دوربین: در حین انجام این حرکات، چندین دوربین (به طور مشخص ۱۲ دوربین RGB-D مصرفی مثل Realsense D415) از زوایای مختلف اتفاقات رو ضبط میکنن. این دوربینها تصاویر چندنمایی از ربات در حال اجرای دستورات تصادفی رو برای مدت ۲ تا ۳ ساعت ثبت میکنن.

- یادگیری از طریق مشاهده: سیستم هیچ دانش قبلی در مورد طراحی ربات نداره. اون با مرتبط کردن سیگنالهای کنترلی خودش به نحوه حرکت بدنش، یاد میگیره. در واقع، یک مدل یادگیری عمیق اجازه میده ربات تشخیص بده خودش و اعضای بدنش در فضای سهبعدی کجا قرار دارن. این بهش اجازه میده پیشبینی کنه که با اجرای دستورات حرکتی خاص، موقعیتش چطور تغییر میکنه.

- استفاده از رندرینگ تفاضلی: فرآیند آموزش از چیزی به اسم «رندرینگ تفاضلی» استفاده میکنه. در هر مرحله از آموزش، سیستم یکی از ۱۲ دوربین رو به عنوان ورودی انتخاب میکنه و از روی همون یک تصویر، میدانهای ژاکوبین و تابش رو که هندسه و ظاهر سهبعدی ربات رو کدگذاری میکنن، بازسازی میکنه. بعد، با توجه به یک دستور ربات، از میدان ژاکوبین برای پیشبینی میدان حرکت سهبعدی حاصل استفاده میکنه. این میدان حرکت سهبعدی رو به جریان نوری دوبعدی یکی دیگه از ۱۲ دوربین رندر میکنه و با جریان نوری مشاهده شده واقعی مقایسه میکنه. این کار به میدان ژاکوبین یاد میده که حرکت ربات رو به درستی پیشبینی کنه.

وقتی مرحله یادگیری تموم شد، ربات برای کار در زمان واقعی فقط به یک دوربین استاندارد احتیاج داره. بعد از اون میتونه خودش رو تماشا کنه، تصمیم بگیره و به سرعت پاسخ بده. این سیستم با سرعتی حدود ۱۲ سیکل در ثانیه (۱۲ هرتز) کار میکنه که سریعتر و کاربردیتر از خیلی از سیستمهای سنتیه که برای رباتهای نرم استفاده میشن.

محققان امآیتی معتقدن که این رویکرد میتونه روزی در محیطهای دنیای واقعی مثل کشاورزی، ساخت و ساز، یا محیطهای پویا بدون نیاز به سنسورهای سنگین یا برنامهنویسی سفارشی استفاده بشه.

فصل چهارم: این سیستم روی چه رباتهایی امتحان شده؟

برای اینکه نشون بدن این چارچوب چقدر کارآمده، اون رو روی طیف وسیعی از سیستمهای رباتیک آزمایش کردن که از نظر مواد، پیچیدگی حرکتی و قیمت متفاوت بودن.

- دست پنوماتیک هیبریدی نرم-سخت: یک دست رباتیک نرم که با هوا کار میکنه و با پرینتر سهبعدی به صورت یکپارچه ساخته شده. این دست ۳۰۰ دلاری روی یک بازوی رباتیک معمولی نصب شده بود. این دست انگشتان نرم PneuNet رو با یک هسته سخت ترکیب میکنه و توسط ۱۵ کانال پنوماتیک کنترل میشه.

- پلتفرم رباتیک مچمانند (HSA): یک پلتفرم رباتیک نرم موازی که از فعالکنندههای برشی دستی آکستیک (HSA) ساخته شده. این پلتفرم با طرح سازگارش حرکات مچمانند و کشش خطی رو ممکن میکنه، اما مدلسازی دقیقش به خاطر تغییر شکل تحت نیروهای خارجی سخته.

- دست Allegro: یک دست رباتیک انساننما که به صورت تجاری در دسترسه و ۱۶ درجه آزادی داره. این دست به خاطر درجات آزادی بالا و مهارت مکانیکی، یک بستر آزمایشی چالشبرانگیزه.

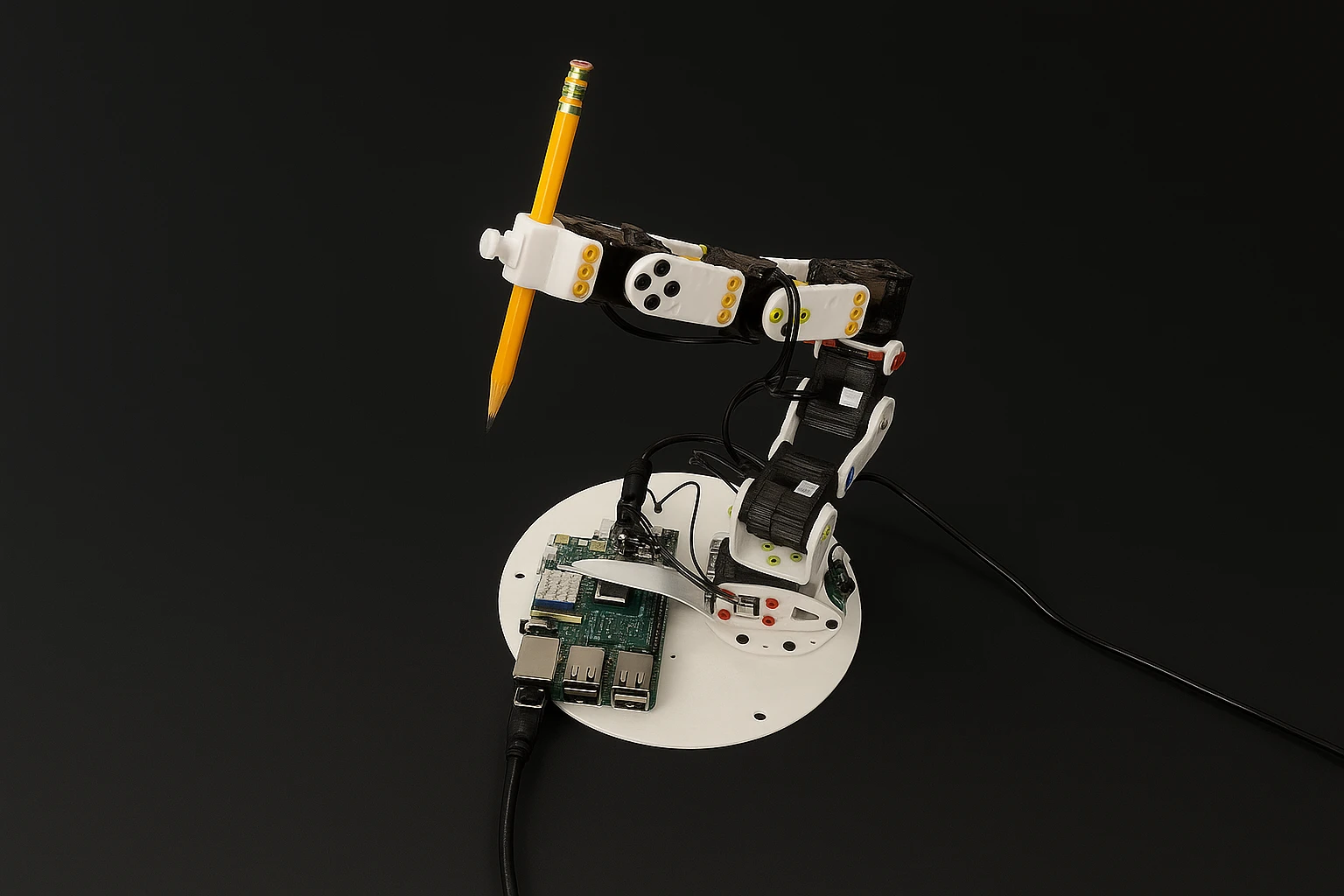

- بازوی رباتیک Poppy Ergo Jr: یک بازوی رباتیک متنباز و کمهزینه با شش درجه آزادی که با استفاده از سرووهای Dynamixel و قطعات پرینت سهبعدی ساخته شده. این ربات به راحتی قابل تهیه است، اما تلرانسهای مکانیکی و لقی (backlash) اون مدلسازی دقیقش رو سخت میکنه.

در تمام این سیستمهای چالشبرانگیز، میدانهای ژاکوبین عصبی موفق شدن یک نمایش سهبعدی دقیق از هر ربات رو فقط از روی یک تصویر بازسازی کنن. جالبه که این سیستم ساختار حرکتی علی هر ربات رو یاد گرفت و تشخیص داد که کدوم کانال فرمان مسئول فعال کردن کدوم قسمت از ربات در فضای سهبعدی هست. این قابلیت کاملا به صورت خودنظارتی و بدون هیچگونه حاشیهنویسی یا نظارتی که موتورها رو با قطعات ربات تطبیق بده، به وجود اومد.

فصل پنجم: نتایج و عملکرد در دنیای واقعی

این سیستم فقط در تئوری خوب کار نمیکنه، بلکه در عمل هم نتایج قابل توجهی داشته.

عملکرد در کنترل حلقه-بسته

- دست Allegro: برای این دست، یک مسیر دوبعدی برای ردیابی یک حالت مشخص به کنترلر داده شد. پس از تکمیل مسیر، خطا با استفاده از سنسورهای داخلی با دقت بالای هر مفصل و مدل سینماتیک پیشروی دقیق سهبعدی دست اندازهگیری شد. سیستم فقط با استفاده از بینایی، دست Allegro رو طوری کنترل کرد که هر انگشت رو کاملا باز و بسته کنه و به خطایی کمتر از ۳ درجه در هر مفصل و کمتر از ۴ میلیمتر برای هر نوک انگشت رسید.

- پلتفرم HSA: روی این پلتفرم، سیستم تونست ربات رو تحت دینامیکهای بسیار تغییریافته بدون نیاز به آموزش مجدد کنترل کنه. محققان به عمد با وصل کردن وزنههای کالیبراسیون با مجموع جرم ۳۵۰ گرم به یک میله چوبی که به بالای پلتفرم چسبانده شده بود، اون رو مختل کردن. این وزنهها یک نیروی عمودی و یک گشتاور به بالای پلتفرم وارد میکردن که باعث میشد در حالت استراحت به طور محسوسی کج بشه. با این حال، چارچوب مبتنی بر بینایی تونست ربات رو برای تکمیل حرکات چرخشی پیچیده کنترل کنه و به پیکربندی هدف برسه، و به خطای ۷.۳۰۳ میلیمتر دست پیدا کرد.

- بازوی رباتیک Poppy: برای این بازوی پرینت سهبعدی، مسیرهای هدفی طراحی شد که ربات رو ملزم میکرد یک مربع و حروف «MIT» رو در هوا بکشه. این توالی حرکتی در دادههای آموزشی وجود نداشت. چارچوب به خطای متوسط کمتر از ۶ میلیمتر در وظیفه ردیابی حالت هدف دست پیدا کرد.

مقاومت در برابر اختلالات

سیستم در برابر اختلالات بصری هم مقاومه. با استفاده از تکنیکهای تصادفیسازی دامنه (domain randomization) در طول آموزش، مثل قرار دادن پیشزمینه ربات روی پسزمینههای تصادفی، مقاومت ماژول بازسازی سهبعدی عصبی در برابر شلوغی بصری و انسداد جزئی بهبود پیدا کرد.

- آزمایش با انسداد: وقتی تیم موانع بصری رو به صحنه اضافه کرد، روشهای کنترلی قدیمیتر وارد حالت خطا شدن. اما ماشینهایی که از روش جدید استفاده میکردن، حتی وقتی صحنهها تا حدی با شلوغی تصادفی مسدود شده بودن، با موفقیت نقشههای سهبعدی قابل پیمایش ایجاد کردن. حتی با وجود موانع بزرگی مثل حصارهای مقوایی، سیستم تونست مسیرهای سهبعدی رو با دست Allegro به دقت ردیابی کنه و به خطای مفصلی متوسط ۲.۸۹ درجه برسه.

در کل، این چارچوب کنترل دقیقی رو برای سیستمهای رباتیک متنوع، از جمله سیستمهای سفت و سخت معمولی و سیستمهای هیبریدی پرینت سهبعدی، بدون نیاز به مدلسازی تخصصی، دخالت یا هرگونه تخصصسازی الگوریتم برای هر ربات، ممکن کرده.

فصل ششم: نگاهی عمیقتر به تکنولوژی پشت صحنه

حالا که با کلیات ماجرا آشنا شدیم، بیا کمی عمیقتر به اجزای فنی این سیستم نگاه کنیم.

دو جزء کلیدی چارچوب

این چارچوب از دو جزء اصلی تشکیل شده:

- مدل تخمین حالت مبتنی بر یادگیری عمیق: این مدل یک نمایش سهبعدی از ربات رو استنتاج میکنه که هم هندسه سهبعدی و هم سینماتیک دیفرانسیل اون رو کدگذاری میکنه (یعنی هر نقطه در فضای سهبعدی تحت هر فرمان ممکن ربات چطور حرکت میکنه). این کار فقط از روی یک جریان ویدیویی انجام میشه.

- کنترلر دینامیک معکوس: این کنترلر حرکات مورد نظر رو به صورت متراکم در فضای تصویر دوبعدی یا سهبعدی پارامتریزه میکنه و دستورات ربات رو با سرعتهای تعاملی پیدا میکنه.

این سیستم به جای اینکه به یک نمایش حالت طراحی شده توسط متخصص (مثل زوایای مفاصل) وابسته باشه، میدان ژاکوبین رو مستقیما از تصویر ورودی با استفاده از یادگیری عمیق بازسازی میکنه.

میدان ژاکوبین بصری-حرکتی (Visuomotor Jacobian Field)

این مفهوم، یک تعمیم فضایی سهبعدی و متراکم از ژاکوبین سیستم متعارف در زمینه سیستمهای دینامیکیه. در رباتیک سنتی، ژاکوبین سیستمی ماتریسیه که تغییر فرمان رو به تغییر حالت ربات مرتبط میکنه. اما طراحی این سیستم برای رباتهای نرم و هیبریدی سخته چون حالت اونها (state) به سادگی رباتهای سفت و سخت تعریف نمیشه.

میدان ژاکوبین بصری-حرکتی این چالشها رو حل میکنه. این میدان مستقیما هر نقطه سهبعدی رو به ژاکوبین سیستم مربوط به خودش نگاشت میکنه. این کار به ما اجازه میده حرکت سهبعدی هر نقطهای در فضا رو پیشبینی کنیم. ترکیب میدان ژاکوبین و میدان تابش عصبی، یک نمایش کامل از حالت رباته که موقعیت هر نقطه سهبعدی و همچنین سینماتیک اون رو کدگذاری میکنه.

ردیابی مسیر (Trajectory Tracking)

الگوریتم کنترل پیشبین مدل (MPC) هم از وظایف ردیابی دوبعدی و هم سهبعدی پشتیبانی میکنه.

- ردیابی دوبعدی: برای این کار، مسیرهای نقطهای از ویدیوهای نمایشی استخراج میشن. در زمان تست، از ویژگیهای TAPIR برای تطبیق یا انتشار نقاط بین فریمها استفاده میشه. میدانهای ژاکوبین حرکت هر پیکسل رو پیشبینی میکنن و دستورات برای به حداقل رسوندن فاصله L2 تا مکانهای نقطه هدف بهینه میشن.

- ردیابی سهبعدی: برای این کار، فریمهای ویدیوی RGB با استفاده از PixelNeRF به ابرهای نقطهای سهبعدی تبدیل میشن. دستورات ربات با به حداقل رسوندن فاصله Wasserstein-1 بین ابرهای نقطهای فعلی و هدف بهینه میشن.

این توانایی برای انتقال نمایش از یک دیدگاه به دیدگاه دیگه مهمه. یک ویدیو که از یک زاویه دید ضبط شده و در زمان اجرا دیگه در دسترس نیست، هنوز هم میتونه برای دنبال کردن مسیر استفاده بشه. مدل این کار رو با تبدیل هر فریم ویدیوی دوبعدی به یک حالت ذرهای سهبعدی انجام میده و ویدیو رو به یک مسیر سهبعدی ترجمه میکنه.

فصل هفتم: چالشها و آینده این تکنولوژی

این چارچوب به ما اجازه داده طیف وسیعی از رباتها رو فقط از طریق بینایی کنترل کنیم. برای اینکه این کار ممکن باشه، حیاتیه که سینماتیک دیفرانسیل ربات رو بشه فقط از روی بینایی استنتاج کرد. اما بعضی کاربردها ممکنه این فرض رو نقض کنن.

محدودیتها

- مشکلات مشاهده: مثلا، وقتی رباتهای پادار متحرک رو از یک دوربین خارجی مشاهده میکنیم، دوربین ممکنه نبینه که یک پای مشخص با زمین تماس داره یا نه، و در نتیجه نمیتونه حرکت ربات رو به عنوان تابعی از فعالسازی اون پا تعیین کنه.

- حس لامسه: به طور مشابه، برای دستکاری ماهرانه، حس کردن تماس با یک شی حیاتیه. این سیستم در حال حاضر فاقد حس نیرو یا لامسه است که کاراییش رو در وظایف غنی از تماس محدود میکنه.

- حرکت شبه-استاتیک: این روش در حال حاضر اثرات گذرا مرتبه دوم رو در نظر نمیگیره و حرکت رو شبه-استاتیک فرض میکنه. این برای طیف وسیعی از کاربردها عملیه، اما تعمیم به اثرات دینامیکی یک حوزه هیجانانگیز برای کارهای آینده است.

- نیاز به آموزش برای هر ربات: در حال حاضر، آموزش NJF به چندین دوربین احتیاج داره و باید برای هر ربات به صورت جداگانه انجام بشه.

مسیر آینده

محققان در حال بررسی راههایی برای رفع این محدودیتها هستن:

- افزودن سنسورهای بیشتر: شرطی کردن روش استنتاج مبتنی بر یادگیری عمیق برای میدانهای ژاکوبین بصری-حرکتی روی سنسورهای بیشتر، مثل سنسورهای لمسی، میتونه به طور موثر این محدودیت رو برطرف کنه.

- عمومیتبخشی: محققان در حال تصور یک نسخه در دسترستر هستن. در آینده، علاقهمندان میتونن حرکات تصادفی یک ربات رو با تلفن همراهشون ضبط کنن و از اون فیلم برای ایجاد یک مدل کنترلی استفاده کنن، بدون اینکه به دانش قبلی یا تجهیزات خاصی نیاز داشته باشن.

- گسترش مدل: تیم در حال بررسی بهبود تعمیم، مدیریت انسدادها، و گسترش توانایی مدل برای استدلال در افقهای فضایی و زمانی طولانیتره.

این کار یک روند گستردهتر در رباتیک رو منعکس میکنه: حرکت از برنامهنویسی دستی مدلهای دقیق به سمت آموزش رباتها از طریق مشاهده و تعامل. وینسنت سیتزمن (Vincent Sitzmann)، استاد دستیار امآیتی و نویسنده ارشد، میگه: «بینایی به تنهایی میتونه سرنخهای لازم برای مکانیابی و کنترل رو فراهم کنه. این در رو به روی رباتهایی باز میکنه که میتونن در محیطهای به هم ریخته و بدون ساختار، از مزارع گرفته تا سایتهای ساختمانی، بدون زیرساختهای گرانقیمت کار کنن».

منابع

- Robots are Learning to Move on Their Own Using a Single Camera | PetaPixel

- MIT’s human-like AI can control any robot and gain physical awareness using just a single camera | Live Science

- Controlling diverse robots by inferring Jacobian fields with deep networks | Nature

- Robots that know themselves: MIT’s vision-based system teaches machines to understand their bodies | MIT CSAIL

دیدگاهتان را بنویسید