مایکروسافت به تازگی عضو جدیدی از خانواده مدلهای زبان کوچک (SLM) خودش رو با اسم «فی-۴-مینی-فلش-ریزنینگ» (Phi-4-mini-flash-reasoning) معرفی کرده. این مدل با هدف خاصی طراحی شده: آوردن قابلیتهای استدلال پیشرفته به محیطهایی که با محدودیتهای جدی در زمینه توان محاسباتی، حافظه و تاخیر (latency) روبرو هستن. این یعنی دستگاههای لبه (edge devices)، اپلیکیشنهای موبایل و بقیه سیستمهایی که منابع محدودی دارن، میتونن از این مدل استفاده کنن. این مدل جدید در ادامه مسیر مدل قبلی یعنی «فی-۴-مینی» (Phi-4-mini) ساخته شده، اما روی یک معماری کاملا جدید و ترکیبی بنا شده که بهش اجازه میده عملکرد بسیار سریعتری داشته باشه. طبق گفته مایکروسافت، این مدل میتونه تا ۱۰ برابر توان پردازشی (throughput) بالاتر و به طور متوسط ۲ تا ۳ برابر کاهش در تاخیر رو فراهم کنه، بدون اینکه به عملکرد استدلالش آسیبی برسه. هدف اینه که راهکارهای دنیای واقعی که به کارایی و انعطافپذیری نیاز دارن، با این مدل قدرت بگیرن. در حال حاضر، این مدل در پلتفرمهایی مثل Azure AI Foundry، کاتالوگ API انویدیا (NVIDIA API Catalog) و هاگینگ فیس (Hugging Face) در دسترسه.

هدف اصلی: کارایی بدون فدا کردن کیفیت

مدل فی-۴-مینی-فلش-ریزنینگ تلاش میکنه تا بین توانایی استدلال ریاضی و کارایی، یک تعادل برقرار کنه. همین ویژگی باعث میشه برای کاربردهای آموزشی، اپلیکیشنهای منطقمحور که به پاسخدهی در لحظه نیاز دارن و موارد مشابه، گزینه مناسبی باشه. مثل مدل قبلی خودش، این مدل هم یک مدل متنباز با ۳.۸ میلیارد پارامتره که برای استدلال ریاضی پیشرفته بهینهسازی شده. این مدل از طول زمینه (context length) ۶۴ هزار توکنی پشتیبانی میکنه و روی دادههای مصنوعی باکیفیت تنظیم دقیق (fine-tune) شده تا عملکردی قابل اعتماد و منطقمحور رو در زمان استقرار (deployment) ارائه بده.

این مدل به طور خاص برای حل مسائل ریاضی چند مرحلهای و منطقمحور در محیطهایی طراحی شده که حافظه و توان محاسباتی محدوده و تاخیر پایین یک فاکتور حیاتیه. بعضی از موارد استفاده اصلی اون شامل تولید اثباتهای رسمی، محاسبات نمادین، مسائل کلامی پیشرفته و طیف گستردهای از سناریوهای استدلال ریاضی میشه. این مدلها در حفظ زمینه در طول مراحل مختلف یک مسئله، به کار بردن منطق ساختاریافته و ارائه راهحلهای دقیق و قابل اتکا در حوزههایی که به تفکر تحلیلی عمیق نیاز دارن، عملکرد خوبی از خودشون نشون میدن.

با این حال، باید در نظر داشت که این مدل فقط برای استدلال ریاضی طراحی و آزمایش شده و به طور خاص برای تمام کاربردهای دیگه ارزیابی نشده. توسعهدهندهها باید محدودیتهای رایج مدلهای زبانی و همچنین تفاوت عملکرد در زبانهای مختلف رو در نظر بگیرن و قبل از استفاده در یک کاربرد خاص، به خصوص در سناریوهای پرخطر، دقت، ایمنی و انصاف مدل رو ارزیابی و برای کاهش خطرات احتمالی اقدام کنن. همچنین توسعهدهندهها باید از قوانین و مقررات مربوط به حریم خصوصی، قوانین تجاری و غیره که به کاربردشون مرتبطه، آگاه باشن و از اونها پیروی کنن.

نوآوریهای فنی: معماری جدید SambaY

چیزی که این مدل رو از نسخههای قبلی متمایز میکنه، معماری جدیدشه. در قلب مدل فی-۴-مینی-فلش-ریزنینگ، یک معماری جدید به اسم «SambaY» قرار داره که از نوع «رمزگشا-ترکیبی-رمزگشا» (decoder-hybrid-decoder) هست. نوآوری اصلی این معماری، یک واحد به اسم «واحد حافظه دروازهای» یا «Gated Memory Unit» (GMU) هست. این واحد یک مکانیزم ساده ولی موثر برای به اشتراک گذاشتن بازنماییها (representations) بین لایههای مختلف مدله.

این معماری از چند بخش تشکیل شده:

- خود-رمزگشا (Self-decoder): این بخش ترکیبی از مدل «مامبا» (Mamba) که یک مدل فضای حالت (State Space Model – SSM) هست و «توجه پنجره لغزان» (Sliding Window Attention – SWA) رو به همراه یک لایه از توجه کامل (full attention) شامل میشه.

- متقاطع-رمزگشا (Cross-decoder): این بخش لایههای پرهزینه «توجه متقاطع» (cross-attention) رو با واحدهای جدید و کارآمد GMU به صورت در هم تنیده استفاده میکنه.

این معماری جدید با ماژولهای GMU به شدت کارایی رمزگشایی (decoding) رو بهبود میده، عملکرد بازیابی در زمینههای طولانی (long-context retrieval) رو تقویت میکنه و به مدل اجازه میده در طیف وسیعی از وظایف، عملکرد استثنایی داشته باشه.

یک نکته فنی مهم در این معماری که از روشی به اسم «YOCO» الهام گرفته شده، اینه که لایه توجه کامل فقط در مرحله «prefilling» (پر کردن اولیه) با خود-رمزگشا، حافظه پنهان کلید-مقدار (KV cache) رو محاسبه میکنه. این کار باعث میشه پیچیدگی محاسباتی در مرحله prefill به صورت خطی باقی بمونه.

به طور خلاصه، مزایای کلیدی معماری SambaY این موارد هستن:

- افزایش کارایی رمزگشایی: مدل میتونه پاسخها رو سریعتر تولید کنه.

- حفظ پیچیدگی زمانی خطی برای prefill: زمان لازم برای پردازش ورودی اولیه با افزایش طول ورودی به صورت خطی زیاد میشه، نه نمایی.

- افزایش مقیاسپذیری و عملکرد بهتر در زمینه طولانی: مدل میتونه با متنهای بسیار طولانی بهتر کار کنه.

- توان پردازشی تا ۱۰ برابر بالاتر: مدل میتونه در یک زمان مشخص، حجم کار بسیار بیشتری رو انجام بده.

این معماری ترکیبی از مدلهای فضای حالت و توجه، به مدل اجازه میده هم سرعت بالایی داشته باشه و هم بتونه مسائل پیچیده رو درک کنه.

عملکرد و بنچمارکها: مقایسه با مدلهای دیگر

مثل همه مدلهای خانواده فی، فی-۴-مینی-فلش-ریزنینگ هم میتونه روی یک پردازنده گرافیکی (GPU) تکی مستقر بشه و همین موضوع اون رو برای طیف وسیعی از کاربردها در دسترس قرار میده. اما چیزی که اون رو متمایز میکنه، مزیت معماریشه. این مدل جدید در مقایسه با مدل «فی-۴-مینی-ریزنینگ»، به خصوص در تولید متنهای طولانی و وظایف استدلالی که به تاخیر حساس هستن، به طور قابل توجهی تاخیر کمتر و توان پردازشی بالاتری داره. این ویژگیها اون رو به گزینهای جذاب برای توسعهدهندهها و شرکتهایی تبدیل میکنه که میخوان سیستمهای هوشمندی رو مستقر کنن که به استدلال سریع، مقیاسپذیر و کارآمد نیاز دارن، چه به صورت محلی (on-premises) و چه روی خود دستگاه (on-device).

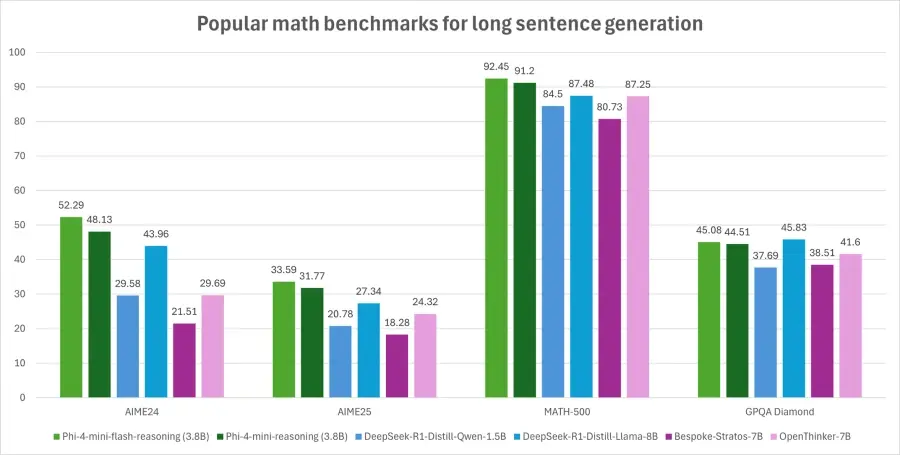

برای درک بهتر قابلیتهای این مدل ۳.۸ میلیارد پارامتری، اون رو با مجموعهای از مدلهای دیگه در بنچمارکهای مختلف استدلال مقایسه کردن. در این ارزیابیها از روش دقیقتری استفاده شده که در اون دقت «Pass@1» (یعنی موفقیت در اولین تلاش) برای بنچمارکهای AIME24/25 روی ۶۴ نمونه و برای Math500 و GPQA Diamond روی ۸ نمونه میانگینگیری شده. نتایج در جدول زیر اومده:

| مدل | AIME24 | AIME25 | Math500 | GPQA Diamond |

|---|---|---|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | ۲۹.۵۸ | ۲۰.۷۸ | ۸۴.۵۰ | ۳۷.۶۹ |

| DeepSeek-R1-Distill-Qwen-7B | ۵۳.۷۰ | ۳۵.۹۴ | ۹۳.۰۳ | ۴۷.۸۵ |

| DeepSeek-R1-Distill-Llama-8B | ۴۳.۹۶ | ۲۷.۳۴ | ۸۷.۴۸ | ۴۵.۸۳ |

| Bespoke-Stratos-7B | ۲۱.۵۱ | ۱۸.۲۸ | ۸۰.۷۳ | ۳۸.۵۱ |

| OpenThinker-7B | ۲۹.۶۹ | ۲۴.۳۲ | ۸۷.۲۵ | ۴۱.۶۰ |

| Phi4-mini-Reasoning (3.8B) | ۴۸.۱۳ | ۳۱.۷۷ | ۹۱.۲۰ | ۴۴.۵۱ |

| Phi4-mini-Flash-Reasoning (3.8B) | ۵۲.۲۹ | ۳۳.۵۹ | ۹۲.۴۵ | ۴۵.۰۸ |

همونطور که در جدول دیده میشه، مدل فی-۴-مینی-فلش-ریزنینگ با اینکه فقط ۳.۸ میلیارد پارامتر داره، تونسته به سطحی از توانایی استدلال ریاضی و علمی برسه که با مدلهای بسیار بزرگتر برابری میکنه و حتی از مدلهای دو برابر اندازه خودش هم بهتر عمل کرده. با این حال، این مدل به دلیل اندازه کوچکش، اساسا برای بعضی وظایف خاص محدودیت داره. به عبارت سادهتر، این مدل ظرفیت ذخیره کردن حجم زیادی از دانش واقعی (factual knowledge) رو نداره. به همین دلیل، ممکنه کاربران با پاسخهای نادرست از نظر واقعیتی روبرو بشن. البته این ضعف رو میشه با ترکیب کردن مدل با یک موتور جستجو، به خصوص در تنظیمات «تولید افزوده با بازیابی» (RAG)، برطرف کرد.

کارایی محاسباتی: نمودارهای تاخیر و توان پردازشی

برای نمایش کارایی این مدل، دو نمودار ارائه شده که عملکرد تاخیر و توان پردازشی مدلهای فی-۴-مینی-ریزنینگ و فی-۴-مینی-فلش-ریزنینگ رو با هم مقایسه میکنن. همه این ارزیابیها با استفاده از فریمورک استنتاج «vLLM» روی یک پردازنده گرافیکی NVIDIA A100-80GB و با موازیسازی تانسوری (TP) غیرفعال (TP=1) انجام شده.

نمودار اول (تاخیر در برابر طول تولید): این نمودار نشون میده که با افزایش طول متنی که مدل تولید میکنه، تاخیر (زمان پاسخدهی) چقدر تغییر میکنه. در مدل فی-۴-مینی-فلش-ریزنینگ، با افزایش تعداد توکنهای تولید شده (تا ۳۲ هزار توکن)، تاخیر تقریبا به صورت خطی رشد میکنه. این در حالیه که در مدل فی-۴-مینی-ریزنینگ، این رشد به صورت درجه دو (quadratic) هست که خیلی سریعتر افزایش پیدا میکنه.

نمودار دوم (تاخیر در برابر توان پردازشی): این نمودار نشون میده که تاخیر استنتاج با تغییر توان پردازشی چطور عوض میشه. این آزمایشها با سطوح مختلفی از درخواستهای همزمان کاربران انجام شده.

این یافتهها نشون میدن که مدل فی-۴-مینی-فلش-ریزنینگ مقیاسپذیرتره و برای وظایف تولید دنبالههای طولانی مناسبتره. این مدل میتونه تا ۱۰ برابر بهبود در توان پردازشی رو موقع پردازش درخواستهای کاربر با طول پرامپت ۲ هزار و طول تولید ۳۲ هزار توکن به دست بیاره.

کاربردهای بالقوه: از آموزش تا دستیارهای هوشمند

به خاطر کاهش تاخیر، بهبود توان پردازشی و تمرکز بر استدلال ریاضی، این مدل برای موارد زیر ایدهآله:

- پلتفرمهای یادگیری تطبیقی: در این پلتفرمها، حلقههای بازخورد در لحظه (real-time feedback) ضروری هستن.

- دستیارهای استدلال روی دستگاه: مثل کمکهای مطالعه موبایلی یا عاملهای منطقی مبتنی بر لبه.

- سیستمهای تدریس تعاملی: این سیستمها به صورت پویا سختی محتوا رو بر اساس عملکرد یادگیرنده تنظیم میکنن.

قدرت این مدل در ریاضیات و استدلال ساختاریافته، اون رو به خصوص برای فناوریهای آموزشی، شبیهسازیهای سبک و ابزارهای ارزیابی خودکار که به استنتاج منطقی قابل اعتماد با زمان پاسخدهی سریع نیاز دارن، ارزشمند میکنه.

راهنمای استفاده برای توسعهدهندگان

توسعهدهندهها میتونن از طریق جامعه دیسکورد توسعهدهندگان مایکروسافت با همکاران و مهندسان مایکروسافت در ارتباط باشن، سوالاتشون رو بپرسن، بازخورد بدن و موارد استفاده واقعی رو با هم بررسی کنن.

توکنایزر (Tokenizer):

فی-۴-مینی-فلش-ریزنینگ از واژگانی با اندازه حداکثر ۲۰۰,۰۶۴ توکن پشتیبانی میکنه. فایلهای توکنایزر از قبل توکنهای جایگزینی (placeholder) رو ارائه میدن که میشه برای تنظیم دقیق در مراحل بعدی ازشون استفاده کرد، اما میشه اونها رو تا سقف اندازه واژگان مدل گسترش داد.

فرمت ورودی (Input Formats):

با توجه به ماهیت دادههای آموزشی، این مدل برای پرامپتهایی که از فرمت چت خاصی برای وظایف استدلالمحور استفاده میکنن، بهترین عملکرد رو داره. فرمت پیشنهادی به این شکله:

<|user|>Please reason step by step, and put your final answer within \boxed{}. How to solve 3*x^2+4*x+5=1?<|end|><|assistant|>

این فرمت به مدل کمک میکنه تا بفهمه باید به صورت مرحله به مرحله استدلال کنه و جواب نهایی رو در یک کادر مشخص قرار بده.

استنتاج با کتابخانه transformers:

برای استفاده از این مدل، به بستههای نرمافزاری زیر نیاز دارید:

flash_attn==2.7.4.post1 torch==2.6.0 mamba-ssm==2.2.4 causal-conv1d==1.5.0.post8 transformers==4.46.1 accelerate==1.4.0

مثال کد پایتون:

بعد از دریافت چکپوینتهای مدل، کاربران میتونن از کد نمونه زیر برای استنتاج استفاده کنن:

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer, pipeline

torch.random.manual_seed(0)

model_id = "microsoft/Phi-4-mini-flash-reasoning"

model = AutoModelForCausalLM.from_pretrained(

model_id,

device_map="cuda",

torch_dtype="auto",

trust_remote_code=True,

)

tokenizer = AutoTokenizer.from_pretrained(model_id)

messages = [{

"role": "user",

"content": "How to solve 3*x^2+4*x+5=1?"

}]

inputs = tokenizer.apply_chat_template(

messages,

add_generation_prompt=True,

return_dict=True,

return_tensors="pt",

)

outputs = model.generate(

**inputs.to(model.device),

max_new_tokens=32768,

temperature=0.6,

top_p=0.95,

do_sample=True,

)

outputs = tokenizer.batch_decode(outputs[:, inputs["input_ids"].shape[-1]:])

print(outputs[0])جزئیات فرآیند آموزش مدل

مشخصات مدل:

معماری: این مدل از معماری ترکیبی SambaY با «توجه تفاضلی» (Differential Attention) استفاده میکنه، ۳.۸ میلیارد پارامتر و واژگانی با ۲۰۰ هزار توکن داره. این معماری شامل مدلهای فضای حالت، توجه گروهی-پرسشی (grouped-query attention)، مکانیزم اشتراک حافظه دروازهای، حافظه پنهان کلید-مقدار مشترک با یک لایه توجه سراسری و امبدینگهای ورودی-خروجی مشترک هست.

ورودیها: متن. بهترین عملکرد رو با پرامپتهای فرمت چت داره.

طول زمینه: ۶۴ هزار توکن.

سختافزار آموزش: برای پیشآموزش (Pre-training) از ۱۰۲۴ پردازنده گرافیکی A100-80G و برای آموزش استدلال (Reasoning training) از ۱۲۸ پردازنده H100-80G استفاده شده.

زمان آموزش: پیشآموزش ۱۴ روز و آموزش استدلال ۲ روز طول کشیده.

دادههای آموزش: برای پیشآموزش ۵ تریلیون توکن و برای آموزش استدلال ۱۵۰ میلیارد توکن استفاده شده.

خروجیها: متن تولید شده.

تاریخها: مدل در ماه می ۲۰۲۵ آموزش دیده. تاریخ قطع دادههای عمومی مورد استفاده فوریه ۲۰۲۵ هست.

وضعیت: این یک مدل ایستا (static) هست که روی مجموعه دادههای آفلاین آموزش دیده.

زبانهای پشتیبانی شده: انگلیسی.

تاریخ انتشار: ژوئن ۲۰۲۵.

مجموعه دادههای آموزشی (Training Datasets):

دادههای آموزشی این مدل به طور انحصاری از محتوای ریاضی مصنوعی تشکیل شده که توسط یک مدل استدلال قویتر و پیشرفتهتر به اسم «Deepseek-R1» تولید شده. هدف از این کار، «تقطیر دانش» (knowledge distillation) از اون مدل بزرگتره. این مجموعه داده مصنوعی شامل بیش از یک میلیون مسئله ریاضی متنوع با سطوح دشواری مختلف (از دوره راهنمایی تا سطح دکترا) هست.

برای هر مسئله در این مجموعه داده، هشت راهحل متفاوت (rollouts) نمونهبرداری شده و فقط اونهایی که صحتشون تایید شده، نگه داشته شدن. این فرآیند منجر به تولید حدود ۳۰ میلیارد توکن محتوای ریاضی شده.

این مجموعه داده سه جزء اصلی رو با هم ادغام میکنه:

- مجموعهای دستچین شده از سوالات ریاضی باکیفیت و در دسترس عموم و بخشی از دادههای SFT (تنظیم دقیق نظارت شده) که برای آموزش مدل پایه فی-۴-مینی-فلش استفاده شده.

- مجموعه گستردهای از دادههای ریاضی مصنوعی تولید شده توسط مدل Deepseek-R1 که به طور خاص برای تنظیم دقیق نظارت شده با کیفیت بالا و تقطیر مدل طراحی شده.

- مجموعهای متعادل از پاسخهای درست و نادرست که برای ساخت دادههای ترجیحی (preference data) استفاده شده. هدف از این کار، افزایش قابلیتهای استدلال مدل با یادگیری مسیرهای استدلالی موثرتره.

نرمافزار و سختافزار مورد نیاز:

نرمافزارهای اصلی مورد استفاده در توسعه این مدل شامل PyTorch، Transformers، Flash-Attention، Mamba و Causal-Conv1d هستن. به طور پیشفرض، این مدل از «فلش اتنشن» (flash attention) استفاده میکنه که برای اجرا به انواع خاصی از سختافزار GPU نیاز داره. این مدل روی پردازندههای گرافیکی NVIDIA A100 و NVIDIA H100 آزمایش شده.

تعهد مایکروسافت به هوش مصنوعی قابل اعتماد

مایکروسافت متعهده که به سازمانها کمک کنه تا از هوش مصنوعی قابل اعتماد استفاده و اون رو بسازن. هوش مصنوعی قابل اعتماد یعنی امن، خصوصی و ایمن باشه. این شرکت از تجربیات و یادگیریهای چندین دهه تحقیق و ساخت محصولات هوش مصنوعی در مقیاس بزرگ استفاده میکنه تا تعهدات و قابلیتهای پیشرو در صنعت رو در سه ستون اصلی امنیت، حریم خصوصی و ایمنی ارائه بده.

مدلهای فی، از جمله فی-۴-مینی-فلش-ریزنینگ، مطابق با اصول هوش مصنوعی مایکروسافت توسعه داده شدن: مسئولیتپذیری، شفافیت، انصاف، قابلیت اطمینان و ایمنی، حریم خصوصی و امنیت، و فراگیری.

خانواده مدلهای فی یک استراتژی قوی پس از آموزش برای ایمنی اتخاذ کردن که ترکیبی از «تنظیم دقیق نظارت شده» (SFT)، «بهینهسازی ترجیحات مستقیم» (DPO) و «یادگیری تقویتی از بازخورد انسانی» (RLHF) رو ادغام میکنه. این تکنیکها با استفاده از ترکیبی از مجموعه دادههای متنباز و اختصاصی به کار میرن و تاکید زیادی بر اطمینان از مفید بودن، به حداقل رسوندن خروجیهای مضر و پرداختن به طیف وسیعی از دستهبندیهای ایمنی دارن. توسعهدهندهها تشویق میشن که بهترین شیوههای هوش مصنوعی مسئولانه رو متناسب با موارد استفاده خاص و زمینههای فرهنگی خودشون به کار بگیرن. برای کسب اطلاعات بیشتر در مورد هرگونه ریسک و استراتژیهای کاهش اون، مطالعه کارت مدل (model card) توصیه میشه.

ملاحظات هوش مصنوعی مسئولانه و محدودیتها

مثل سایر مدلهای زبانی، خانواده مدلهای فی هم به طور بالقوه میتونن به شیوههایی رفتار کنن که ناعادلانه، غیرقابل اعتماد یا توهینآمیز باشن. بعضی از رفتارهای محدودکنندهای که باید از اونها آگاه بود عبارتند از:

- کیفیت خدمات: این مدلها عمدتا روی متن انگلیسی و مقداری متن چند زبانه اضافی آموزش دیدن. زبانهای غیر از انگلیسی عملکرد بدتری رو تجربه خواهند کرد و بین زبانهای غیرانگلیسی هم تفاوت عملکرد وجود داره. گونههای زبان انگلیسی که کمتر در دادههای آموزشی نماینده داشتن، ممکنه عملکرد بدتری نسبت به انگلیسی استاندارد آمریکایی داشته باشن.

- شکافهای عملکرد و ایمنی چند زبانه: با اینکه در دسترس قرار دادن مدلهای زبانی در زبانهای مختلف مهمه، اما مدلهای فی ۴ همچنان چالشهای رایج در نسخههای چند زبانه رو دارن. توسعهدهندهها باید برای زمینه زبانی و فرهنگی خودشون، شکافهای عملکردی یا ایمنی رو آزمایش کنن و مدل رو با تنظیم دقیق اضافی و پادمانهای مناسب سفارشیسازی کنن.

- نمایش آسیبها و تداوم کلیشهها: این مدلها میتونن گروههایی از مردم رو بیش از حد یا کمتر از حد نمایندگی کنن، نمایندگی برخی گروهها رو حذف کنن یا کلیشههای تحقیرآمیز یا منفی رو تقویت کنن. با وجود آموزشهای ایمنی، این محدودیتها ممکنه به دلیل سطوح مختلف نمایندگی گروههای مختلف، زمینههای فرهنگی یا شیوع نمونههایی از کلیشههای منفی در دادههای آموزشی که الگوهای دنیای واقعی و سوگیریهای اجتماعی رو منعکس میکنن، همچنان وجود داشته باشن.

- محتوای نامناسب یا توهینآمیز: این مدلها ممکنه انواع دیگهای از محتوای نامناسب یا توهینآمیز رو تولید کنن که اونها رو برای استقرار در زمینههای حساس بدون اقدامات کاهشی اضافی، نامناسب میکنه.

- قابلیت اطمینان اطلاعات: مدلهای زبانی میتونن محتوای بیمعنی تولید کنن یا محتوایی رو بسازن که ممکنه منطقی به نظر برسه اما نادرست یا قدیمی باشه.

- قابلیت اطمینان اطلاعات انتخابات: این مدل در پاسخ به پرسوجوهای حیاتی مربوط به انتخابات، نرخ نقص بالایی داره که ممکنه منجر به ارائه اطلاعات نادرست یا غیرمعتبر بشه. مایکروسافت در حال کار برای بهبود عملکرد مدل در این زمینه هست. کاربران باید اطلاعات مربوط به انتخابات رو با مقامات انتخاباتی منطقه خودشون تایید کنن.

- محدودیت در زمینه کدنویسی: اکثر دادههای آموزشی فی ۴ مبتنی بر پایتون هستن و از بستههای رایجی مثل «typing, math, random, collections, datetime, itertools» استفاده میکنن. اگه مدل اسکریپتهای پایتونی تولید کنه که از بستههای دیگه یا اسکریپتهایی به زبانهای دیگه استفاده میکنن، به شدت توصیه میشه که کاربران به صورت دستی تمام استفادههای API رو تایید کنن.

- مکالمات طولانی: مدلهای فی ۴، مثل مدلهای دیگه، در بعضی موارد میتونن در جلسات چت بسیار طولانی، پاسخهای تکراری، غیرمفید یا متناقض تولید کنن. به توسعهدهندهها توصیه میشه که اقدامات کاهشی مناسبی رو اعمال کنن، مثل محدود کردن تعداد نوبتهای مکالمه برای جلوگیری از این مشکل.

توسعهدهندهها باید بهترین شیوههای هوش مصنوعی مسئولانه رو به کار بگیرن، از جمله شناسایی، اندازهگیری و کاهش خطرات مرتبط با مورد استفاده خاص و زمینه فرهنگی و زبانی خودشون.

این مدل تحت مجوز «MIT» منتشر شده. این پروژه ممکنه حاوی علائم تجاری یا لوگوهایی برای پروژهها، محصولات یا خدمات باشه. استفاده مجاز از علائم تجاری یا لوگوهای مایکروسافت تابع «دستورالعملهای برند و علائم تجاری مایکروسافت» هست و باید از اونها پیروی کنه. هرگونه استفاده از علائم تجاری یا لوگوهای شخص ثالث تابع سیاستهای اون شخص ثالثه.

مدل فی-۴-مینی-فلش-ریزنینگ یک گام مهم در جهت دموکراتیزه کردن هوش مصنوعی پیشرفته به حساب میاد. با ارائه یک مدل کوچک، سریع و کارآمد که میتونه روی سختافزارهای محدود اجرا بشه، مایکروسافت در حال باز کردن درهای جدیدی برای توسعهدهندگان و شرکتهاست تا بتونن راهکارهای هوشمند رو در لبه شبکه، روی موبایلها و در سیستمهای تعبیهشده پیادهسازی کنن. معماری نوآورانه SambaY با واحدهای GMU، کلید اصلی این پیشرفته. این معماری به مدل اجازه میده تا بدون فدا کردن توانایی استدلال، به سرعت و کارایی بالایی دست پیدا کنه. با اینکه مدل در زمینه استدلال ریاضی و منطقی عملکردی در حد و حتی بهتر از مدلهای بسیار بزرگتر از خودش رو نشون میده، اما محدودیتهای خودش رو هم داره، از جمله کمبود دانش واقعی و عملکرد ضعیفتر در زبانهای غیرانگلیسی. مایکروسافت با تاکید بر هوش مصنوعی مسئولانه و ارائه چارچوبهای ایمنی، تلاش میکنه تا استفاده از این مدلها به شکلی امن و قابل اعتماد صورت بگیره، اما در نهایت این به عهده توسعهدهندههاست که با در نظر گرفتن تمام جوانب، از این ابزار قدرتمند در کاربردهای خودشون به بهترین شکل ممکن استفاده کنن. این مدل نشان میده که عصر هوش مصنوعی قدرتمند و در عین حال در دسترس، دیگر یک رویا نیست و در حال وقوعه.

منابع

- Reasoning reimagined: Introducing Phi-4-mini-flash-reasoning | Microsoft Azure Blog

- microsoft/Phi-4-mini-flash-reasoning · Hugging Face

- Phi-4-mini-flash-reasoning : r/LocalLLaMA

- New Microsoft AI Model Brings 10x Speed to Reasoning on Edge Devices, Apps | AIM

- Microsoft’s new Phi-4-mini-flash-reasoning model speeds up on-device AI by 10x

- Phi-4-mini-flash-reasoning: Powering Edge AI with Compact, Fast, and Responsible Reasoning

دیدگاهتان را بنویسید